by rainchu 11 月 29, 2024 | AI , 程式開發

v0.dev 是由 Vercel 開發的 AI 驅動工具,你只要透過簡單的文字提示,就可以快速生成前端網頁的 UI 元件程式碼,其核心特色在於用戶只需輸入需求描述,v0.dev 即可生成對應的 React、Vue 或 Svelte 組件程式碼,並可直接複製到專案中使用。

主要功能:

自然語言生成 UI 元件: 用戶可透過輸入簡單的文字描述,v0.dev 會根據提示生成相應的 UI 元件程式碼,無需手動編寫。即時程式碼複製與整合: 生成的程式碼可直接複製,並整合至現有專案中,方便進行客製化調整。 支援多種前端框架: 除了 React,v0.dev 也支援 Vue 和 Svelte 等框架,滿足不同開發者的需求。

使用方法:

訪問 v0.dev 網站: 在瀏覽器中開啟 v0.dev 。輸入提示詞: 在提示框中輸入您想要複製的網址即可。 生成並複製程式碼: v0.dev 會根據您的描述生成對應的程式碼,您可直接複製並整合至您的專案中。

參考資訊:

by rainchu 11 月 29, 2024 | AI , 圖型處理

CodeFormer 是由南洋理工大學 S-Lab 的研究人員開發的一款先進人工智慧工具,專注於人臉修復和增強。它利用代碼查找變壓器(Codebook Lookup Transformer)技術,能夠有效地修復模糊、老舊或受損的人臉圖像,甚至在嚴重退化的情況下,也能生成高品質且真實的面部圖像。

VIDEO

主要特點:

高品質人臉修復: CodeFormer 能夠自動修復模糊或失真的人臉圖像,恢復細節並提升整體畫質。靈活的保真度調節: 用戶可以通過調整保真度參數,在畫質和真實度之間取得平衡,滿足不同需求。背景增強: 結合 Real-ESRGAN 技術,CodeFormer 不僅能修復人臉,還能增強背景部分的清晰度。支援影片處理: 不僅只能處理照片,也可以直接處理影片

安裝方法:

安裝條件

Pytorch >= 1.7.1

CUDA >= 10.1

安裝步驟

# git clone this repository

git clone https://github.com/sczhou/CodeFormer

cd CodeFormer

# 官方建議 create new anaconda env

# 我用的是 python 3.11

conda create -n codeformer python=3.8 -y

conda activate codeformer

# install python dependencies

pip3 install -r requirements.txt

# 需要可視化的介面的可以加下面的命令

pip install -q gradio

python basicsr/setup.py develop

# only for face detection or cropping with dlib

conda install -c conda-forge dlib ※dlib是更心的人臉偵測器,可以找出更準確的人臉

安裝訓練模型

安裝官方兩個預先訓練好的模型

python scripts/download_pretrained_models.py CodeFormer

# only for dlib face detector

python scripts/download_pretrained_models.py dlib 需要使用影片增強要安裝 ffmpeg

# For Windows/Mac users, please install ffmpeg first

conda install -c conda-forge ffmpeg 使用方法: 到 OpenXLab 以及 Huggingface 直接使用

臉部修復

# 黑白照片適用

# For cropped and aligned faces (512x512)

# Colorize black and white or faded photo

python inference_colorization.py --input_path [image folder]|[image path]

# 臉部修復專用

# For cropped and aligned faces (512x512)

# Inputs could be masked by white brush using an image editing app (e.g., Photoshop)

# (check out the examples in inputs/masked_faces)

python inference_inpainting.py --input_path [image folder]|[image path]

影像增強

# Add '--bg_upsampler realesrgan' to enhance the background regions with Real-ESRGAN

# Add '--face_upsample' to further upsample restorated face with Real-ESRGAN

python inference_codeformer.py -w 0.7 --input_path [image folder]|[image path] 影片增強

# For video clips

# Video path should end with '.mp4'|'.mov'|'.avi'

python inference_codeformer.py --bg_upsampler realesrgan --face_upsample -w 1.0 --input_path 訓練模型的方法:

https://github.com/sczhou/CodeFormer/blob/master/docs/train.md

應用場景:

老照片修復: 將老舊或受損的照片進行數位化修復,恢復其原有風采。模糊照片清晰化: 提升低解析度或模糊照片的清晰度,使細節更加突出。AI 生成圖像優化: 對 AI 生成但存在瑕疵的人臉圖像進行修復,提升其真實感。

參考資訊:

by rainchu 11 月 28, 2024 | Agent , AI

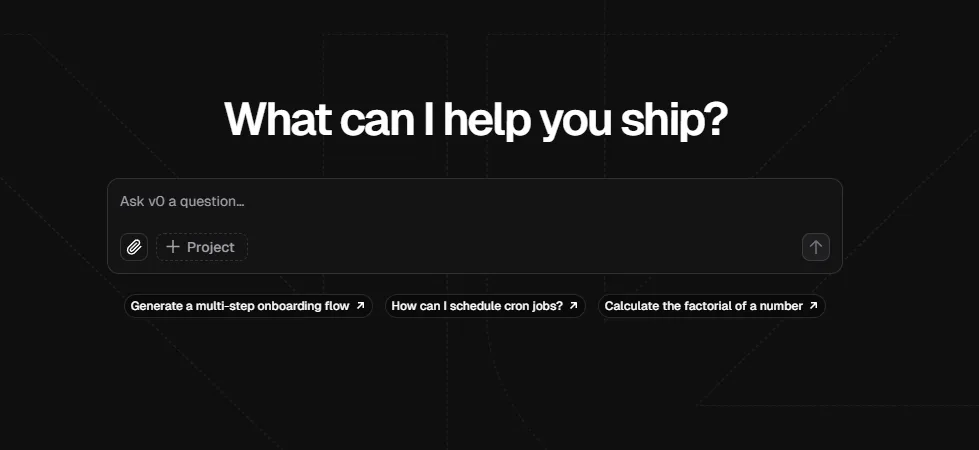

Flowise 是一款開源的低代碼工具,一般人也可以輕易地使用,用於構建自定義的大語言模型(LLM)編排流程和 AI 代理。透過直觀的拖放介面,使用者可以輕鬆設計複雜的 AI 工作流程,無需深入的程式設計知識。

Flowise 的主要特點:

開源且免費 :Flowise 完全開源,使用者可自由使用並進行二次開發,無需擔心授權問題。 GitHub 低代碼開發 :透過簡單的拖放介面,使用者可以快速構建 LLM 應用,縮短開發週期。 Flowise AI Docs 多代理支援 :Flowise 提供多代理系統,允許使用者設計可與外部工具和資料來源互動的代理,實現更高效的任務處理。 Flowise AI Docs 靈活的工作流程設計 :使用者可以根據需求,自定義工作流程的邏輯和順序,滿足不同場景的應用需求。

Flowise 與其他 AI 代理工具的差異:

與 Langflow 的比較 :Langflow 專注於自然語言處理,提供可視化介面來構建和調試語言處理流程。相比之下,Flowise 更強調 LLM 的編排和代理的靈活性,適用範圍更廣。 與 Dify 的比較 :Dify 致力於簡化 AI 應用的部署,提供一站式解決方案。而 Flowise 更專注於工作流程的設計和代理的構建,提供更大的自定義空間。 與其他工具的比較 :Flowise 的開源性和低代碼特性,使其在靈活性和可擴展性方面具有優勢,適合需要快速迭代和自定義需求的開發者。

參考資料

VIDEO

by rainchu 11 月 22, 2024 | AI , 程式 , 程式開發

LLMs Server 還是需要放在 Linux 環境中比較好,但開發階段常常用 Windows 在開發,多數人使用的 Shell export 就沒法使用

export OPENAI_API_KEY="sk-...". Windows中設置LLM環境變數的幾種方法解決方法

使用命令列 CMD

set OPENAI_API_KEY=sk-... 使用 PowerShell

[Environment]::SetEnvironmentVariable("OPENAI_API_KEY", "sk-...", "User") 放在 Python 程式中

import os

# 設置環境變數

os.environ['OPENAI_API_KEY'] = 'sk-你的API密鑰'

# 之後就可以使用這個環境變數了

# 例如,當使用OpenAI的API時,就可以從環境變數中獲取API密鑰

api_key = os.environ['OPENAI_API_KEY']

print("API Key:", api_key) 檢查是否有正確設置

相關資料

by rainchu 11 月 22, 2024 | AI , Chat

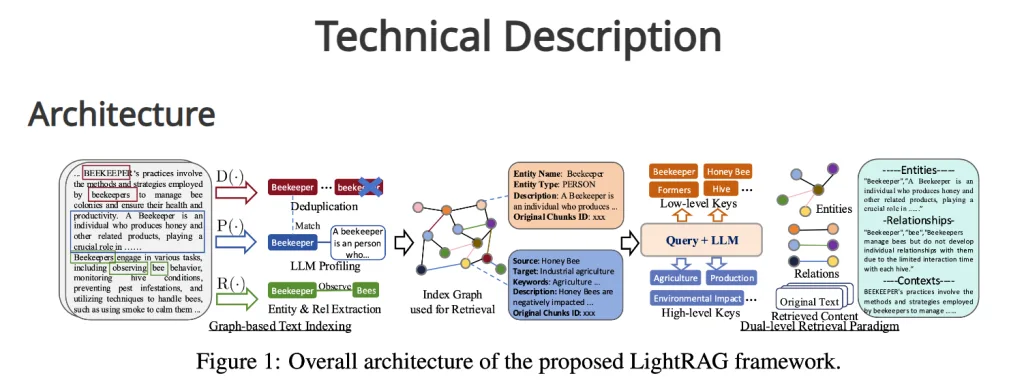

省錢增效又不失去太多的準確度,值得試試看的知識圖譜 RAG

LightRAG 框架 如何使用可以看這一篇

VIDEO

瀏覽器看這篇-browser-use

https://github.com/gregpr07/browser-use

VIDEO

相關資源

Paper

Code

近期留言