by Rain Chu | 3 月 27, 2025 | Python, 程式

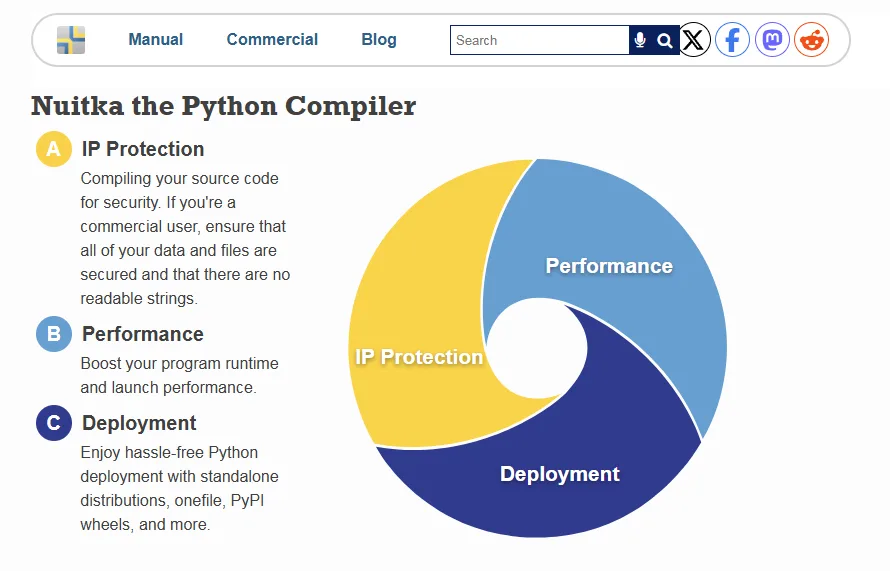

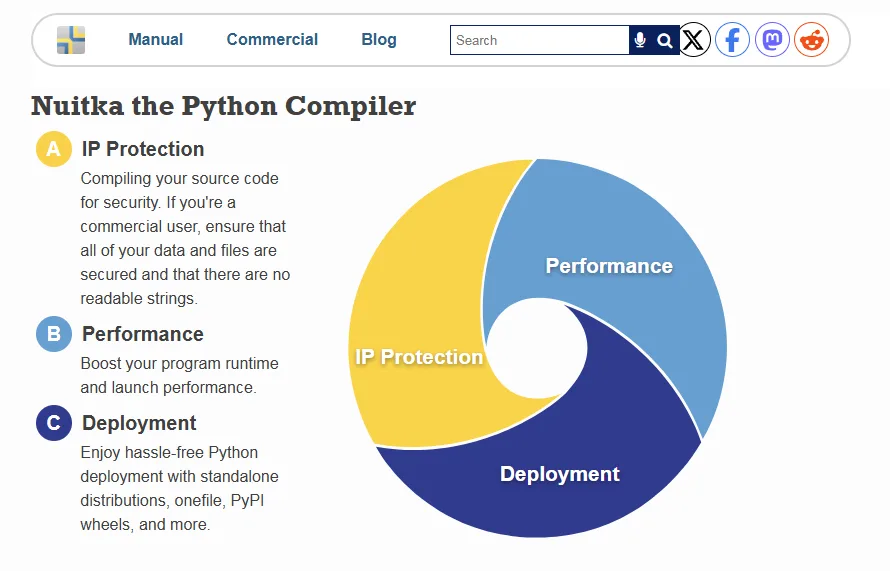

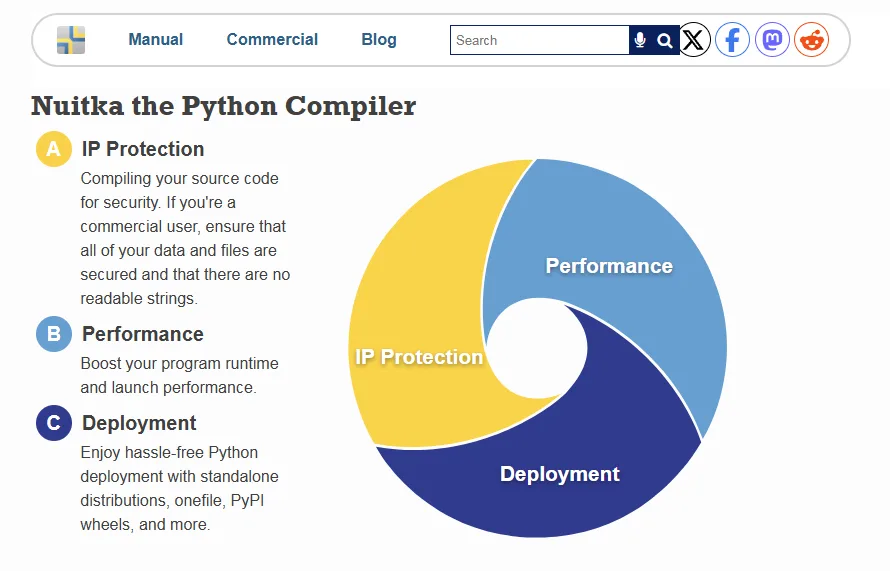

當你在開發 Python 時,將程式轉換為可執行檔案(如 .exe)並提升執行效率是許多開發者關心的議題,Nuitka 是一款大家都推薦的 Python 編譯器,能夠將 Python 原始碼編譯為 C 語言,進而生成高效的可執行檔案,今天來介紹 Nuitka 的安裝、封裝流程、靜態檔案,與相依套件的處理,以及常見問題與性能優化建議,讓即使是初學者也能輕鬆上手。

1. 安裝與執行封裝

安裝 Nuitka

- 安裝 C++ 編譯器:Nuitka 需要 C++ 編譯器來編譯生成的 C 程式碼。在 Windows 系統上,推薦安裝 MinGW64。

- 安裝 Nuitka:使用

pip 安裝 Nuitka:

執行封裝

假設您的主程式為 main.py,可以使用以下命令將其封裝為可執行檔案:

nuitka --standalone --mingw64 --enable-plugins=tk-inter --disable-console --remove-output --onefile --output-dir=output main.py

上述命令的參數說明:

--standalone:生成獨立的可執行檔案,包含所有相依套件。--mingw64:使用 MinGW64 作為編譯器。--enable-plugins=tk-inter:啟用 tkinter 插件,根據實際使用的套件啟用相應插件。--disable-console:隱藏執行時的控制台視窗,適用於 GUI 應用程式。--remove-output:在編譯完成後移除中間產物。--output-dir=output:指定輸出目錄為 output。- –onefile:如果希望輸出為單一

.exe 檔案

如果是要用 Visual Studio C++ 來封裝的話可以改用

nuitka --standalone --msvc=latest --enable-plugins=tk-inter --disable-console --remove-output --output-dir=output main.py

2.靜態檔案的處理

在某些應用中,可能需要包含額外的靜態檔案(如圖片、配置檔案)。Nuitka 提供了 --include-data-dir 參數來處理這些檔案:

此命令將當前目錄下的 static 資料夾包含到生成的可執行檔案中,並在執行時可正常訪問。

3.相依套件的處理

Nuitka 會自動檢測並包含大多數的相依套件。然而,對於某些特殊的套件,可能需要手動啟用相應的插件。例如,若您的程式使用了 PySide6,則需要在編譯時啟用該插件:

您可以使用 nuitka --plugin-list 命令查看所有可用的插件列表。

4.常見問題的處理

Nuitka 在首次編譯大型專案時可能需要較長時間。為了加快編譯速度,可以安裝 ccache 來進行編譯快取。

由於 Nuitka 會將所有相依套件包含在內,生成的可執行檔案可能較大。可以嘗試使用 --onefile 參數將所有內容打包成單一檔案,或使用壓縮工具對生成的檔案進行壓縮。

5.關於速度的優化

Nuitka 通過將 Python 程式編譯為 C 語言,通常能提升程式的執行效率。然而,實際的性能提升取決於程式的結構和內容。為了獲得最佳性能,建議:

- 優化原始碼:確保程式碼中沒有不必要的計算和冗餘。

- 使用內建函數:盡可能使用 Python 的內建函數,因為它們通常經過高度優化。

- 避免過度使用動態特性:如

eval、exec 等,這些可能影響編譯器的優化能力。

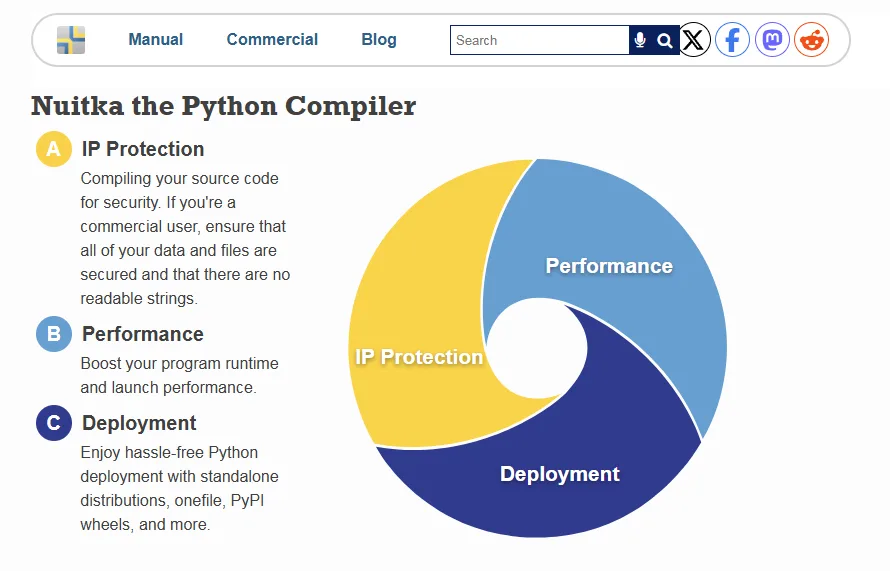

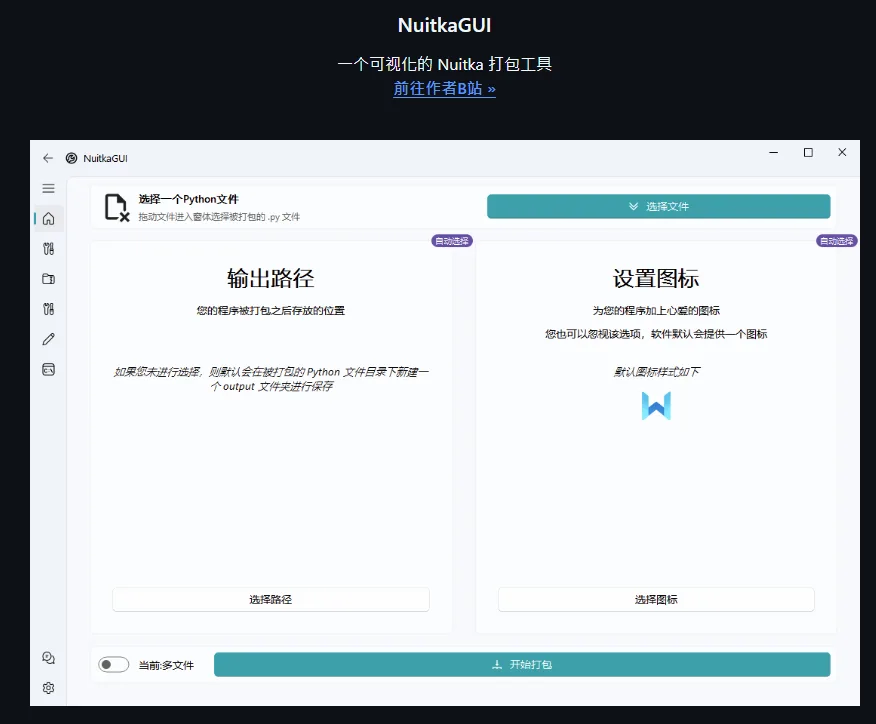

6.🌟使用 Nuitka GUI 友善介面

因為既指令很麻煩,推薦使用 Nuitka GUI,這是一款直覺且操作簡單的圖形介面工具。

Nuitka 官方 GUI 安裝:

開啟 Nuitka GUI:

或是用開源的 GUI

https://github.com/271374667/NuitkaGUI

參考資料

https://nuitka.net

by Rain Chu | 3 月 18, 2025 | AI, API

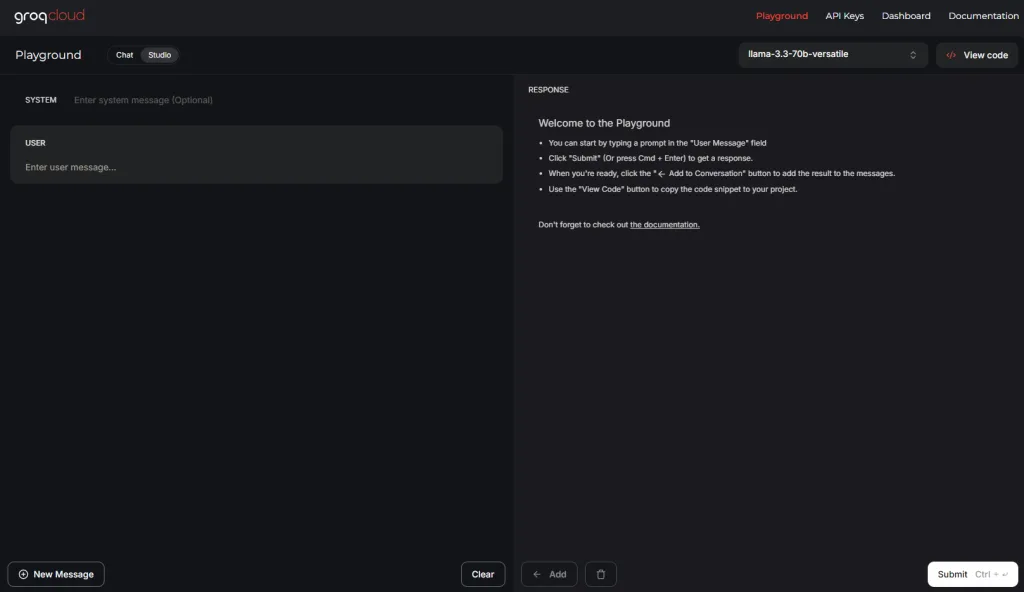

Groq 是一家擁有高效能硬體運算的公司,提供大型語言模型(LLM)的推理運算提供加速解決方案,他們的硬體相較於傳統 GPU,更加快速,並且支援多種主流開源模型,包括 Llama 3、Mistral 等。

Groq API 的主要特色

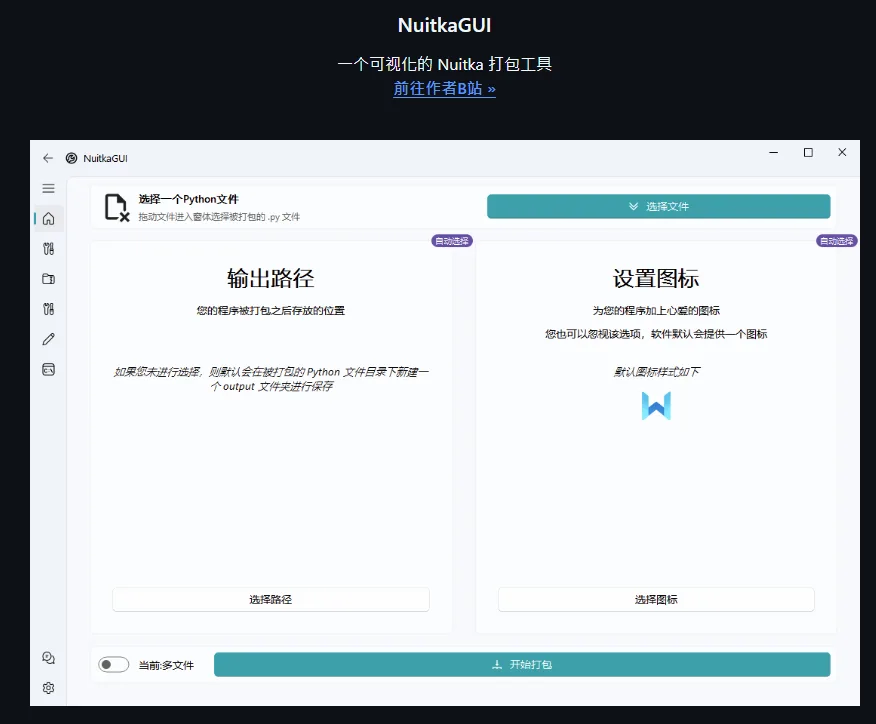

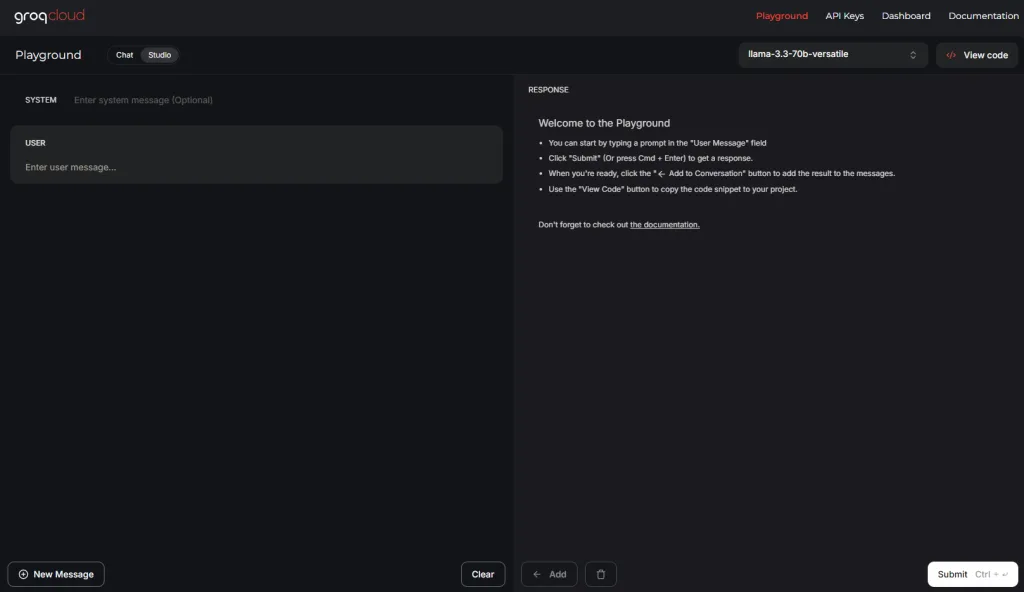

1. 提供 Playground 供快速測試

為了讓開發者能夠直觀地體驗和測試模型,Groq 提供了線上 Playground。使用者可以在此平台上直接輸入指令或問題,立即獲得模型的回應,無需進行繁瑣的設定或部署。

2. 詳細的 API 文件

Groq 提供了詳細且易於理解的 API 文件,涵蓋從基本使用到進階功能的各種說明,協助開發者快速上手並整合到自己的專案中。

3. 高速反應能力

得益於 Groq 的硬體架構,API 的反應速度極快,能夠即時處理大型語言模型的推理需求,提升使用者體驗。

如何開始使用 Groq API

- 註冊並獲取 API 金鑰:

- 前往 Groq 官方網站,點擊「Login」或「Get API Key」,按照提示完成註冊並獲取 API 金鑰。

- 選擇開發環境並調用 API:

- Python:使用 OpenAI 兼容的客戶端調用 Groq 提供的模型。

import openai

openai.api_key = 'YOUR_GROQ_API_KEY'

openai.api_base = 'https://api.groq.com/openai/v1'

response = openai.ChatCompletion.create(

model="groq/llama3-70b-8192",

messages=[

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "請介紹一下 Groq API 的特色。"}

]

)

print(response.choices[0].message['content'])

其他語言:Groq 的 API 兼容 OpenAI 的接口,因此在其他編程語言中,只需將 API 基礎 URL 更改為 https://api.groq.com/openai/v1,並使用您的 Groq API 金鑰即可。

參考資料

by Rain Chu | 3 月 18, 2025 | AI, 影片製作

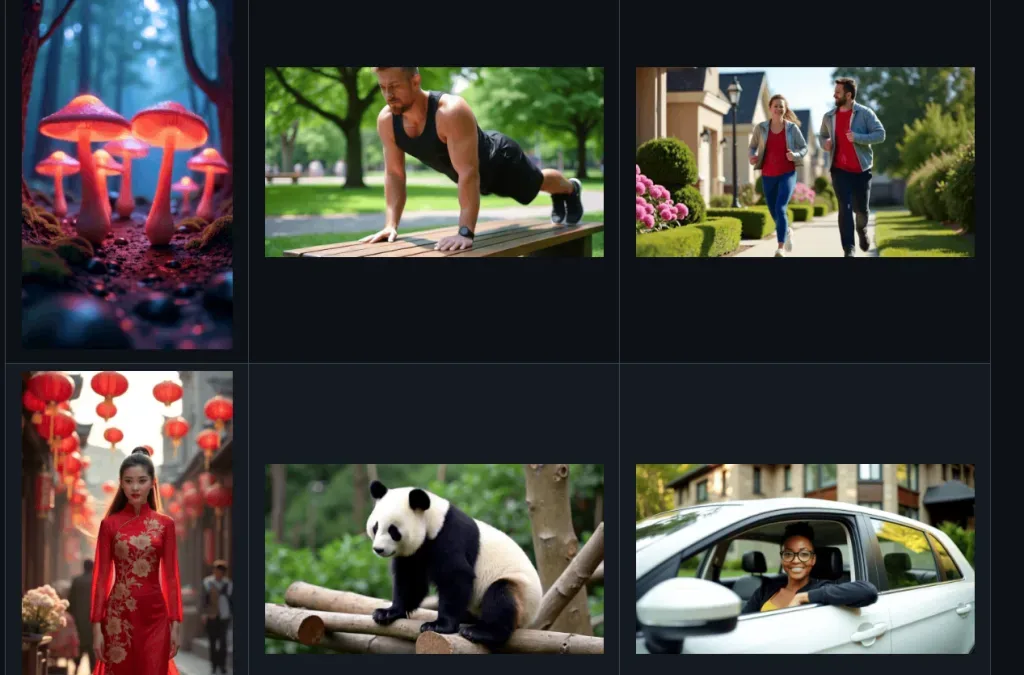

Open-Sora 這個 GitHub 專案,提供類似於 OpenAI 的 Sora 的影片生成模型,讓更多人能夠高效地製作高品質影片,無需再等待 Sora 的推出。

Open-Sora 的主要特色

1. 11B 參數模型

Open-Sora 採用了擁有 110 億參數的大型模型架構,這使其在影片生成的質量和細節上達到業界領先水平。與其他需要大量資源的模型相比,Open-Sora 以較低的成本實現了高品質的影片生成。

2. 基於 PyTorch 和 xFormers

該專案基於 PyTorch 框架開發,並結合了 xFormers 技術,這使得模型在計算效率和資源利用上有顯著提升。開發者可以利用這些技術,進行更高效的模型訓練和推理。

3. 支援本地運行

Open-Sora 支援在本地環境中運行,使用者可以在自己的設備上部署和運行模型,這不僅提高了資料的私密性,還減少了對外部伺服器的依賴。這對於需要處理敏感資料的使用者尤為重要。

如何開始使用 Open-Sora

- 獲取程式碼:前往 Open-Sora 的 GitHub 儲存庫,克隆或下載最新的程式碼。

- 安裝依賴項:確保您的環境中已安裝 PyTorch,並根據專案需求安裝其他必要的 Python 套件。

- 配置環境:根據官方文件,配置您的運行環境,包括設定模型參數和路徑。

- 運行模型:按照指導,運行模型並生成影片。您可以根據需要調整輸入參數,以獲得不同的影片效果。

by Rain Chu | 3 月 18, 2025 | AI, Chat, Prompt, Tool

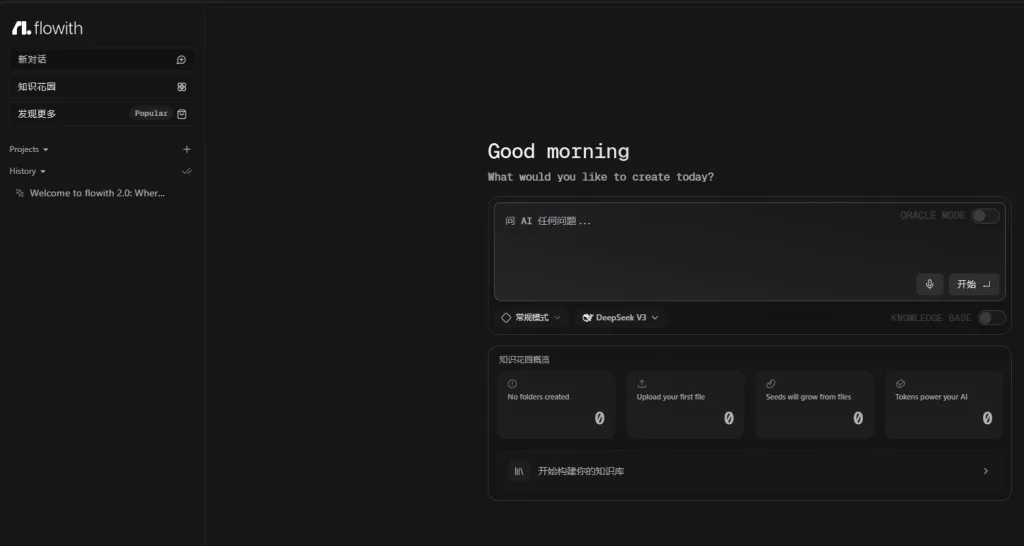

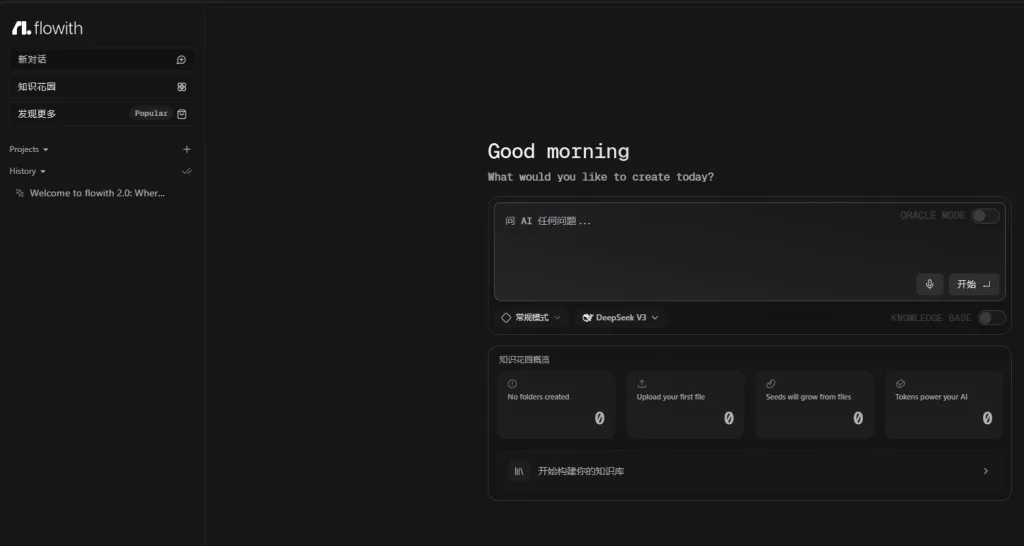

Flowith 最近正迅速崛起,成為超越 Manus 的最強 AI 自動化工具。它不僅免費且無需邀請碼,還具備強大的 ORACLE 模式、自主知識花園創建等功能,為用戶提供無與倫比的 AI 互動體驗。

Flowith 的主要特色

1. 免費使用,無需邀請碼

與其他需要邀請碼的 AI 工具不同,Flowith 完全免費,任何人都可以立即註冊並使用,無需等待或邀請碼。

2. ORACLE 模式:自動化完成文件、簡報製作

Flowith 的 ORACLE 模式是一項突破性的功能,允許數十個甚至數百個 AI 代理同時為您工作,無需手動搭建工作流。這使得複雜的數據收集和分析任務變得輕而易舉,並能自動生成文件和簡報等。

3. 知識花園:創建並變現知識庫

Flowith 的「知識花園」功能讓您可以將自己的知識資源組織成系統化的知識庫,並可選擇對外分享或收費,實現知識變現。

4. 邀請鏈接:獲得額外免費對話次數

透過邀請朋友加入 Flowith,您可以獲得額外的 500 次免費對話次數,提升使用體驗。

邀請碼如下:

https://flowith.io/invitation?code=WPS1WR

如何使用 Flowith

- 註冊帳號:訪問 Flowith 官方網站,點擊「註冊」並填寫相關資訊。

- 探索 ORACLE 模式:在主介面中,選擇 ORACLE 模式,輸入您的需求,系統將自動規劃並執行相關任務。 https://doc.flowith.io

- 建立知識花園:上傳您的資料或文件,Flowith 會自動將其拆分為知識種子,幫助您構建個人知識庫。

參考資料

by Rain Chu | 3 月 17, 2025 | AI, Chat, Tool

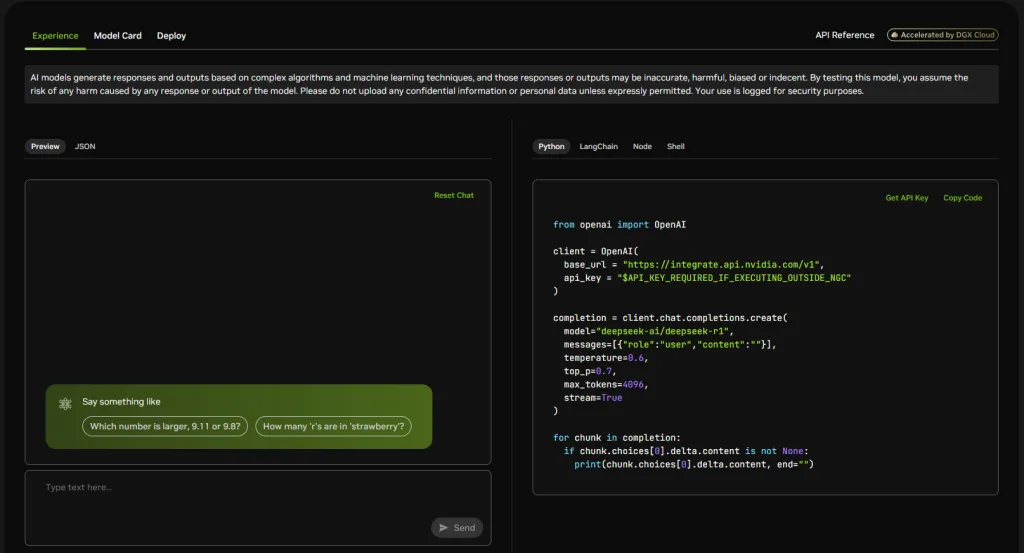

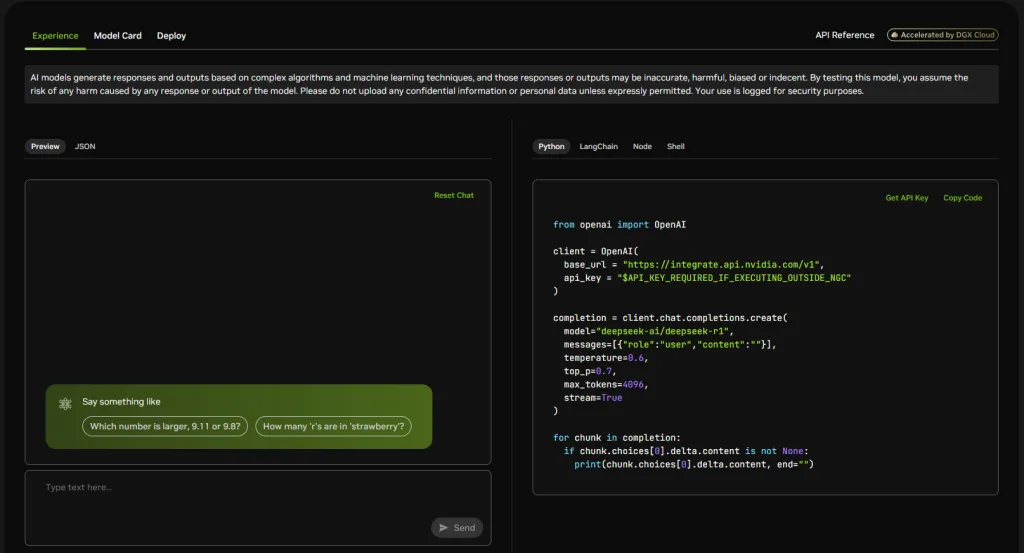

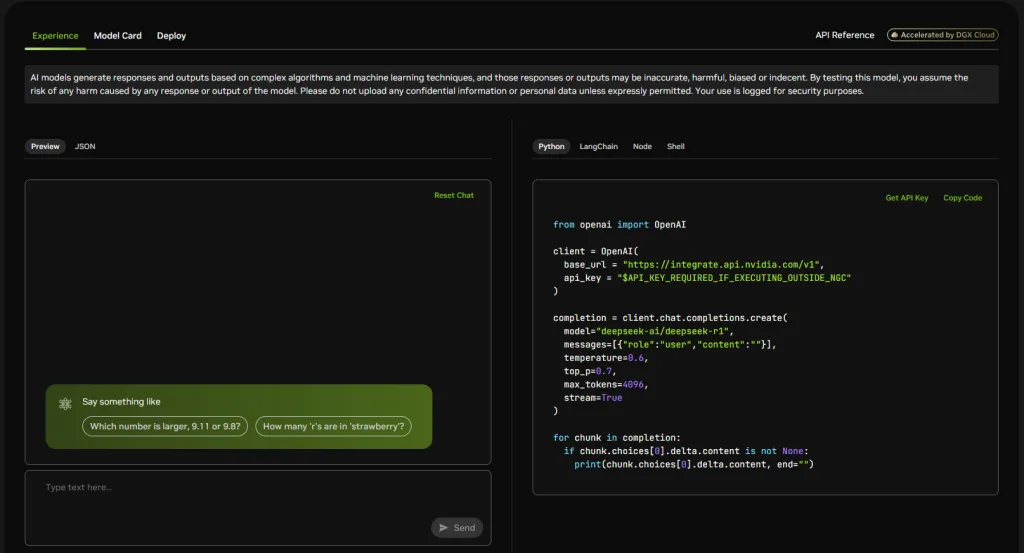

DeepSeek R1 模型已經在 NVIDIA 平台上線,這是一個擁有 6710 億參數的開放式專家混合模型(MoE),專為解決需要高級 AI 推理的問題而設計的,但就是官方API不穩定,只能到處尋找替代的解決方案。

DeepSeek R1 的主要特點

- API 友好性:DeepSeek R1 提供了多種 API 接口,支持 Python、LangChain、Node.js 和 Shell 等,方便開發者根據需求選擇合適的開發環境。

- 免費使用額度:NVIDIA 為個人和企業用戶提供了免費的使用額度。個人用戶可獲得 1000 點額度,企業用戶則可獲得 4000 點額度,讓更多人能夠體驗和使用該模型。

如何開始使用 DeepSeek R1

以下是使用 DeepSeek R1 的基本步驟:

- 註冊並獲取 API 密鑰:

- 前往 NVIDIA NIM 平台的 DeepSeek R1 頁面:

- 點擊右上角的「Login」或「Get API Key」,按照提示完成註冊並獲取 API 密鑰。

- 選擇開發環境並調用 API:

- Python:使用 OpenAI 兼容的客戶端調用 DeepSeek R1。 python複製編輯

- LangChain:可將 DeepSeek R1 集成到 LangChain 框架中,實現更複雜的語言處理任務。

- Node.js 和 Shell:NVIDIA 提供了相應的 SDK 和示例代碼,開發者可根據官方文檔進行集成。

用 python 來做示範

from openai import OpenAI

client = OpenAI(

base_url = "https://integrate.api.nvidia.com/v1",

api_key = "YOUR_API_KEY"

)

completion = client.chat.completions.create(

model="deepseek-ai/deepseek-r1",

messages=[{"role":"user","content":"你的問題內容"}],

temperature=0.6,

top_p=0.7,

max_tokens=4096,

stream=True

)

for chunk in completion:

if chunk.choices[0].delta.content is not None:

print(chunk.choices[0].delta.content, end="")

注意事項

- 使用額度:請留意您的免費使用額度,合理規劃 API 調用次數。

參考資料

https://build.nvidia.com/deepseek-ai/deepseek-r1

近期留言