by Rain Chu | 6 月 12, 2024 | Linux

Linux 的 find 指令是一個非常強大而且必定要學習的工具,用於在文件系統中搜索符合特定條件的文件或目錄。以下想要介紹這個指令,通過各種參數和選項來定制搜索條件,讓你能夠精確地找到所需的文件。

基本語法

find 指令的基本語法如下:

- 路徑:指定

find 指令開始搜索的目錄。如果不指定,默認為當前目錄。

- 選項:定義搜索的條件,例如按文件名、文件類型、修改時間等。

- 動作:對搜索結果執行的操作,如列印文件名、刪除文件等。如果不指定動作,默認動作是列印所有找到的文件的路徑。

常用選項

- 按名稱搜索:

-name 'pattern':搜索文件名匹配指定的模式的文件。模式可以包含通配符,如 * 和 ?。- 示例:

find /home/user -name '*.txt'

- 按類型搜索:

-type f:僅搜索文件。-type d:僅搜索目錄。- 示例:

find /var/log -type f

- 按修改時間搜索:

-mtime +n:搜索在 n 天之前被修改過的文件。-mtime -n:搜索在最近 n 天內被修改過的文件。- 示例:

find / -mtime -10

- 按大小搜索:

-size +n:搜索大於 n 單位的文件。單位可以是 k(KB)、M(MB)、G(GB)。-size -n:搜索小於指定大小的文件。- 示例:

find / -size +100M

常用動作

-print:輸出匹配文件的完整路徑(這是默認動作)。-delete:刪除找到的文件。-exec cmd {} \;:對找到的每個文件執行指定的命令。{} 是一個占位符,代表當前找到的文件名。- 示例:

find /tmp -type f -mtime +30 -exec rm {} \;

最常使用的動作

搜尋整個硬碟中大於100MB的log檔案(不分大小寫),並且把她刪除

find / -type f -size +100M -iname "*.log" -delete

使用案例

尋找並刪除 30 天前的臨時文件:

find /tmp -type f -mtime +30 -delete

尋找特定大小的日誌文件並列出詳細信息:

find /var/log -type f -size +50M -exec ls -lh {} \;尋找所有 JPG 文件並複製到另一個目錄:

find /home/user/Pictures -name '*.jpg' -exec cp {} /home/user/Backup/ \;find 完整參數

- -mtime : 搜尋檔案的修改時間(天)

- -mmin : 搜尋檔案的修改時間(分鐘)

- -ctime : 搜尋檔案的建立時間(天)

- -cmin : 搜尋檔案的建立時間(分鐘)

- -atime : 搜尋檔案的最後開啟時間(天)

- -amin : 搜尋檔案的最後開啟時間(分鐘)

- -size : 搜尋檔案的大小

- -name : 搜尋檔案名稱(有分大小寫)

- -iname : 搜尋檔案名稱(不分大小寫)

- -type f : 只搜尋“檔案”

- -type d : 只搜尋“目錄”

- -exec <cmd> {} \; : 把搜尋結果導向指令來執行

- -user : 搜尋特定使用者的檔案或目錄

- -o : 邏輯運算為「或」的意思

- -print : 將結果印出於螢幕

參考資料

https://www.redhat.com/sysadmin/linux-find-command

by Rain Chu | 6 月 6, 2024 | Raspberry Pi

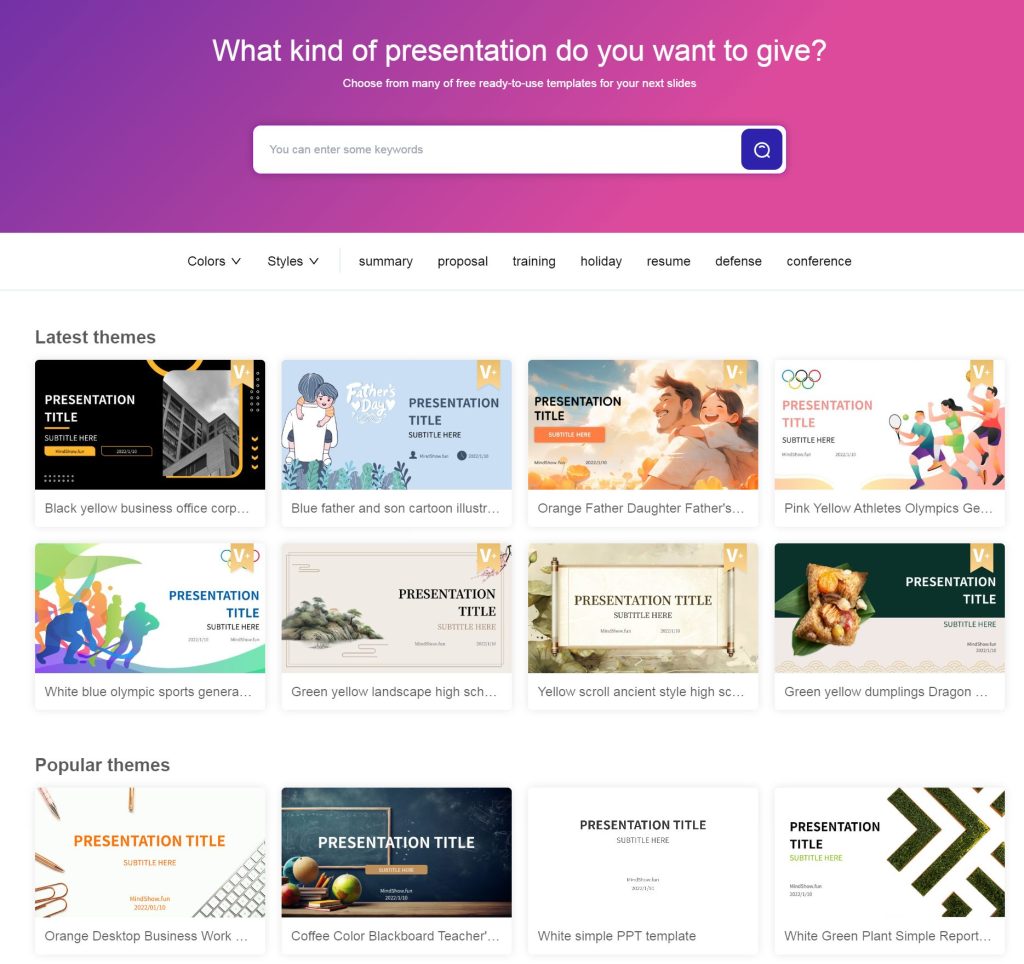

你是不是在尋找下一個大玩具來滿足你對科技的渴望?好消息來了!Raspberry Pi 最近與以色列晶片製造商 Hailo 合作,推出了一款令人驚艷的低成本人工智慧開發套件,讓你的AI夢想更近一步。

這款價格僅為 70 美元的開發套件不僅價格親民,性能也相當驚人。每秒高達 13 兆次(TOPS)的推論性能,絕對能滿足你對速度的所有幻想。不僅如此,這個套件還支持高速的單通道 PCIe 3.0 連接,用M2插槽,速度高達 8Gbps,保證數據傳輸不卡頓,讓你的開發過程更加流暢。

而且,這款開發套件與 Raspberry Pi 的映像軟體子系統實現了無縫整合,這意味著你可以輕鬆地將其應用於各種影像處理和機器學習項目。它還支持第一方或第三方相機,這樣你就可以根據項目需求選擇最適合的相機設備。

最吸引人的或許是其高效的加速硬體排程功能。這個功能讓開發者能在單一相機上運行多個神經網路,或者在兩個相機上同時運行多個神經網路,大大擴展了項目的應用範圍。

此外,Hailo 還提供了一個豐富的模型庫,包括大量已預訓練的神經網路模型,這對於快速開發和部署AI應用來說是一大福音。當然,要使用這個AI套件,缺點是必須要配備如 Raspberry Pi 5 等開發板。

RPI AI Hat

Ai-Kit Docs

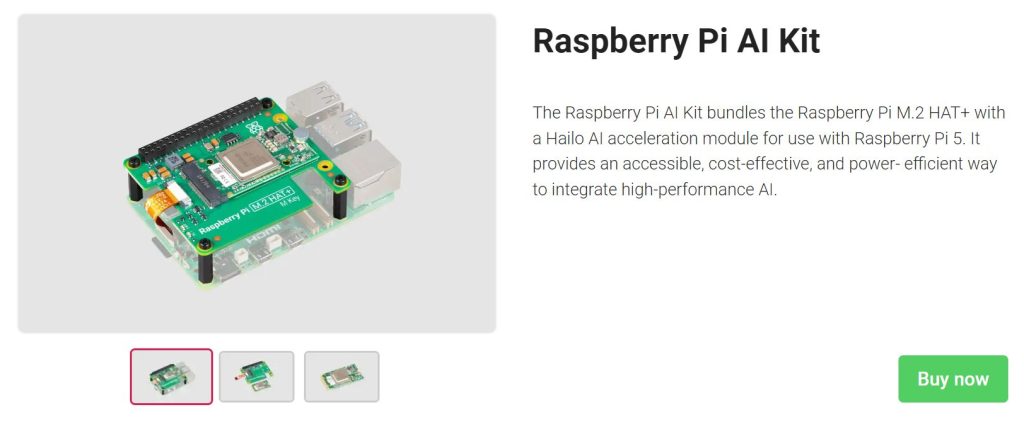

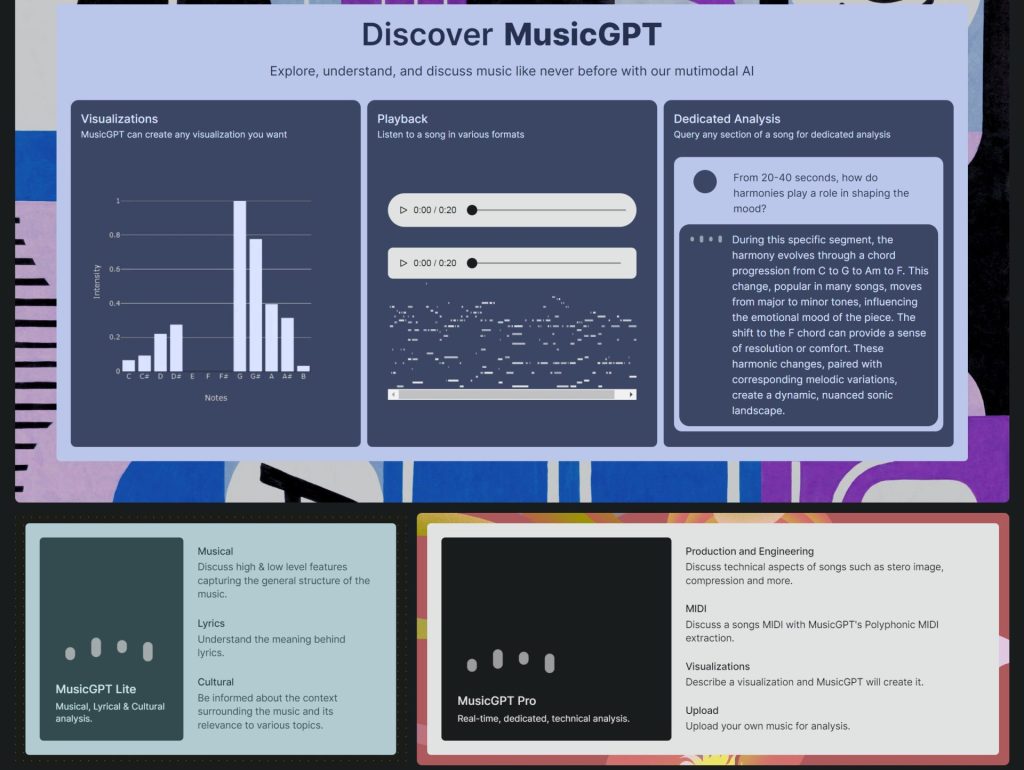

by Rain Chu | 5 月 30, 2024 | AI, 音樂

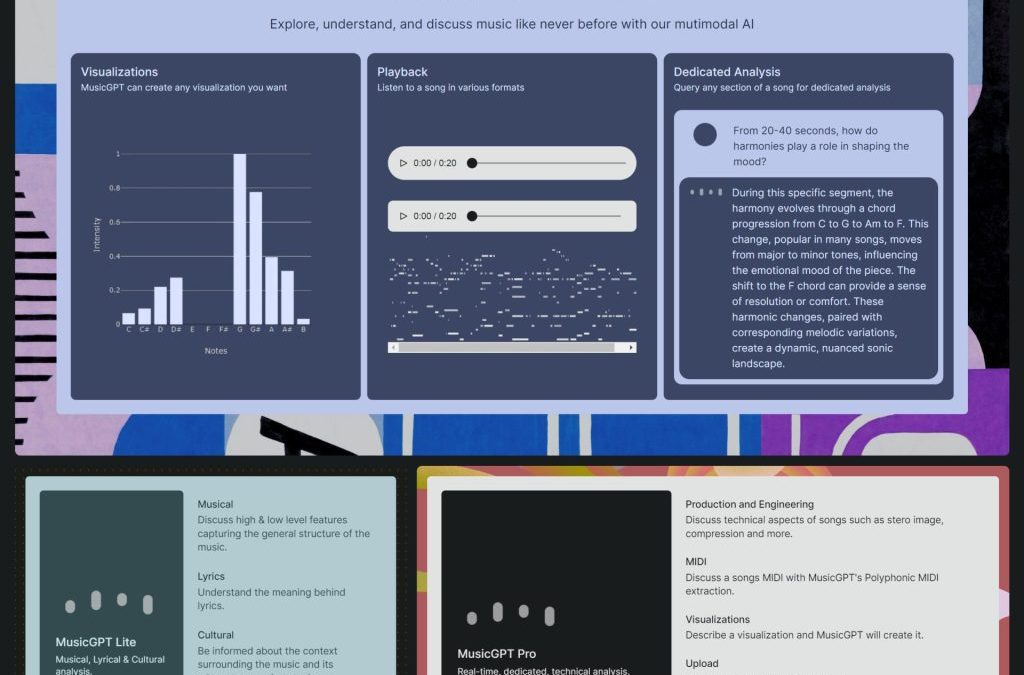

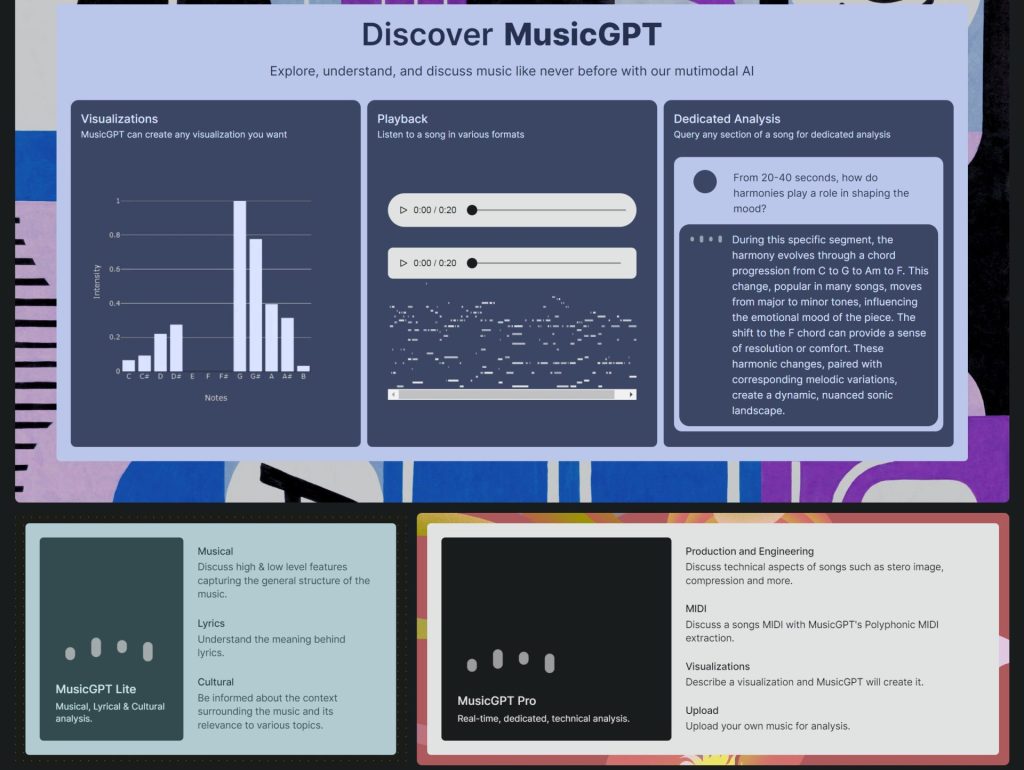

MusicGPT 可以讓使用者能夠在本地使用大型語言模型 (LLMs) 根據自然語言提示生成音樂的功能,他的重點放在文字條件音樂生成、旋律條件音樂生成以及生成無限長或無限音樂流的能力,今天要說明 MusicGPT 如何作為 Suno.ai 的開源替代方案,有甚麼樣的特色有甚麼樣的優缺點。

文字生成音樂

MusicGPT 的文字生成音樂,可以讓用戶輸入描述性文字或情感語言,然後在本地端的系統將其轉化為相應的音樂作品。這一功能對於想要通過音樂增強其敘事的作曲家和故事講述者特別有用,像是YT、小紅書、抖音,能夠完美匹配文本中描述的情緒或場景。無論是反映平靜月光夜的寧靜作品,還是回響著繁忙城市興奮感的活力曲目,MusicGPT 都能適應輸入文本的細微差別。

旋律生成音樂

旋律條件音樂生成將創新推向更深一步,允許用戶輸入特定旋律,MusicGPT 則以此為基礎生成完整的作品。這一功能非常適合那些有旋律想法但需要協助將其發展成完整作品的音樂家和作曲家。MusicGPT 不僅保留原始旋律,還增加了和聲、節奏和配器,提供豐富、飽滿的音樂體驗。

無限長音樂流

MusicGPT 最突破性的功能之一是其生成無限長的能力。這一功能對於遊戲背景音樂、冥想應用程序或公共場所的環境聲景等應用特別吸引人。與傳統的音樂曲目不同,MusicGPT 的作品可以根據需要持續進行,不斷演變而不重複。這創造了一個動態的聽覺環境,可以持續適應聽眾的需求或互動。

Suno.ai 的開源替代方案

MusicGPT 不僅在技術進步上脫穎而出,也因其作為開源解決方案的可訪問性而受到關注。與可能運行專有技術的平台如 Suno.ai 不同,MusicGPT 提供了一種透明、可定制的方法。用戶可以在自己的系統上本地運行它,利用大型語言模型的力量根據自然語言提示生成音樂。這不僅確保了創作過程的隱私和控制,也促進了以社群驅動的發展,其中改進和變化可以由全球用戶共享和實施。

參考資料:

MusicGPT官網:https://www.music-gpt.xyz

原始碼連結:https://github.com/gabotechs/MusicGPT

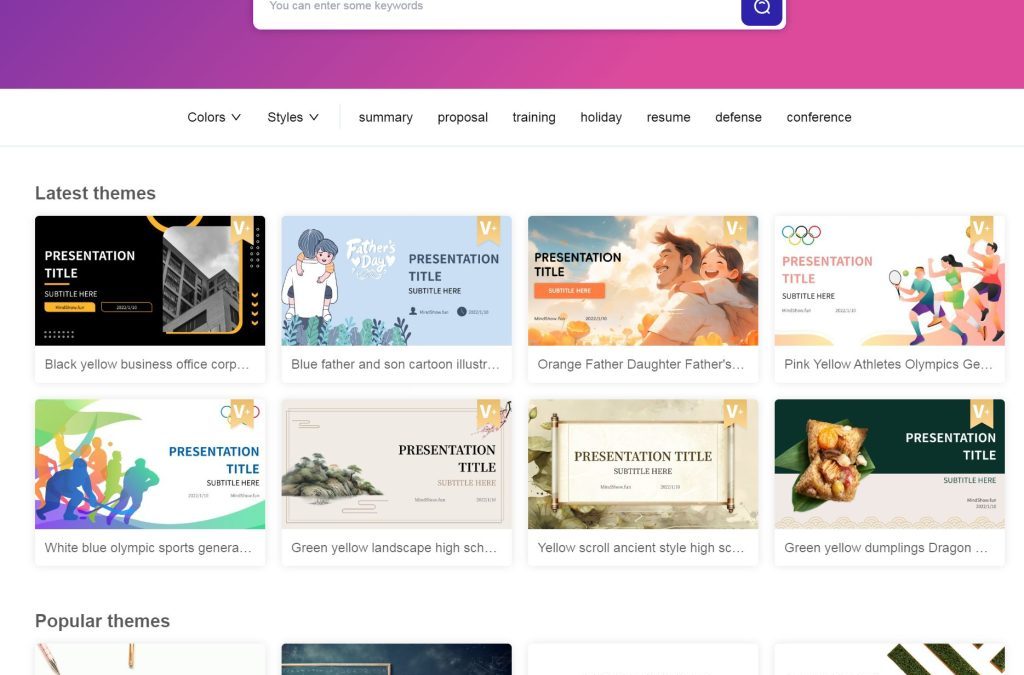

by Rain Chu | 5 月 23, 2024 | AI, PPT

在現代數位時代,製作引人注目的PPT演示文稿是許多專業和教育場合中的必要技能。Mindshow 作為一個創新的工具,為使用者提供了多樣化的功能,使得PPT製作變得更加簡單高效。以下是一些 Mindshow 的主要特色:

1. 超多模板選擇

Mindshow 提供了豐富的模板庫,也支援多國語言,無論是商業報告、學術展示還是創意演講,都可以在 Mindshow 中找到合適的模板,這些模板設計精美,大多數是歐美的簡潔風格,我個人很喜歡,並且結構合理,可以節省使用者大量的設計時間和精力。

2. 歐美 Style

Mindshow 的模板以歐美風格為主,設計簡約大方,適合各種各樣的正式場合,模板融合了現代設計理念,使得PPT看起來專業且時尚,能夠有效吸引觀眾的注意力。

3. 長文生成PPT

Mindshow 的另一大亮點是其自動生成PPT的功能。使用者只需給你寫好的一篇長文,系統就能自動分析並生成相應的PPT頁面,節省了手動編輯的時間,這對於已經有文章要轉換成教學文件的使用者來說,是一個非常實用的功能。

4. APP可以下載

為了方便使用者隨時隨地進行PPT製作,Mindshow 提供了手機應用程式。使用者可以在手機上直接編輯和查看PPT,非常適合需要經常出差或在移動中工作的專業人士。

5. 免費使用

儘管 Mindshow 提供了豐富的功能,其免費版本已經足夠滿足大部分使用者的需求。這意味著即使是預算有限的學生或初創企業,也能夠享受到高品質的PPT製作服務。

參考資料

by Rain Chu | 5 月 23, 2024 | AI, PPT

美圖最近推出新產品,一句話,10秒鐘,生成PPT,並且還可以直接在網站上修改,要快速製作一個PPT專業且吸引人的PPT變得越來越重要。但卻常常面臨創意枯竭、內容組織困難以及設計不當的問題。幸運的是,美團最新開發的 AI PPT 工具可以解決這些難題。只需一句話,AI 就能根據您的需求自動生成符合專業水準的 PPT。

同時解決你的思路、文章、設計上的難題

這款 AI PPT 工具不僅能幫助您迅速整理思路,生成內容,還能提供精美的設計模板。無論是商業演示、學術報告,還是個人展示,AI 都能根據您的指示自動調整格式和風格,確保您的每一頁PPT都能給人留下深刻印象。

美團最新開發的 AI PPT – 什麼樣的PPT,AI都能做

美團的 AI PPT 工具具備強大的自動化能力,能夠分析您的文字輸入,理解您的需求,並快速生成符合您預期的PPT。無論是數據圖表、文字內容還是圖像排版,AI 都能靈活處理,幫助您輕鬆完成高質量的演示文稿

多種下載格式與高彈性編修

這款 AI PPT 工具支持多種下載格式,包括 PPT、PNG、PDF 等,方便您根據需求選擇最適合的文件格式。此外,您還可以在線直接編修,提供了極大的彈性和便利性。透過這款工具,製作 PPT 將變得前所未有的簡單且高效。無需再為思路混亂、文章結構以及設計風格煩惱,只需簡單幾步,AI 就能幫您搞定一切,讓您輕鬆應對各種演示需求

了解更多請訪問 美圖設計室。

參考資料

近期留言