by rainchu | 12 月 18, 2025 | AI, 影片製作

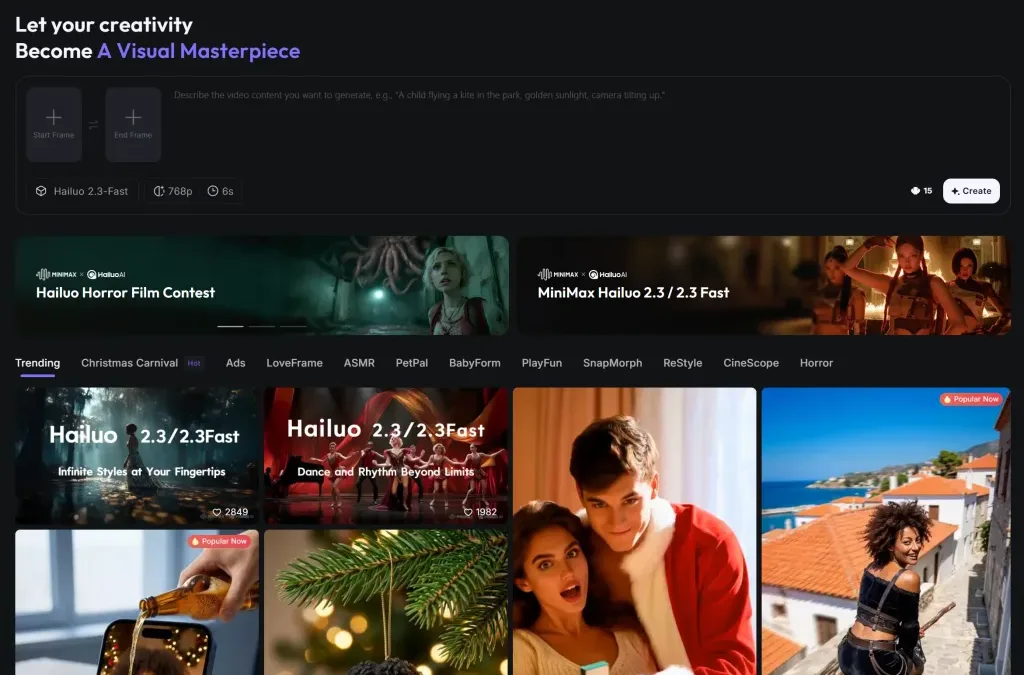

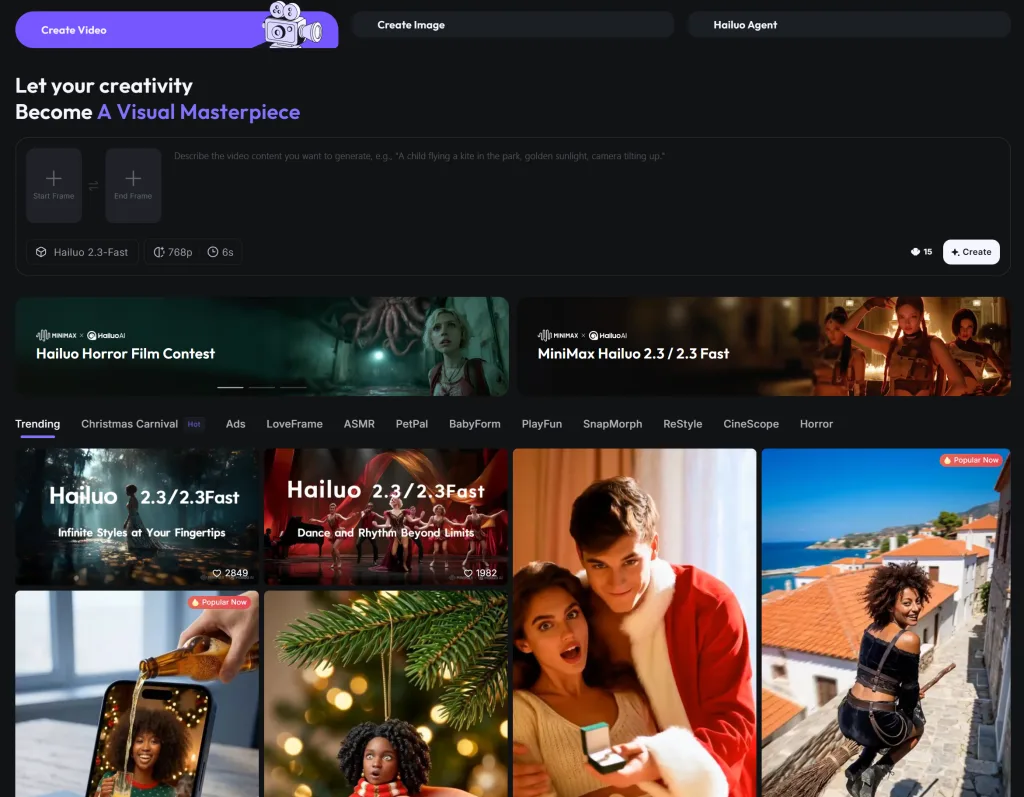

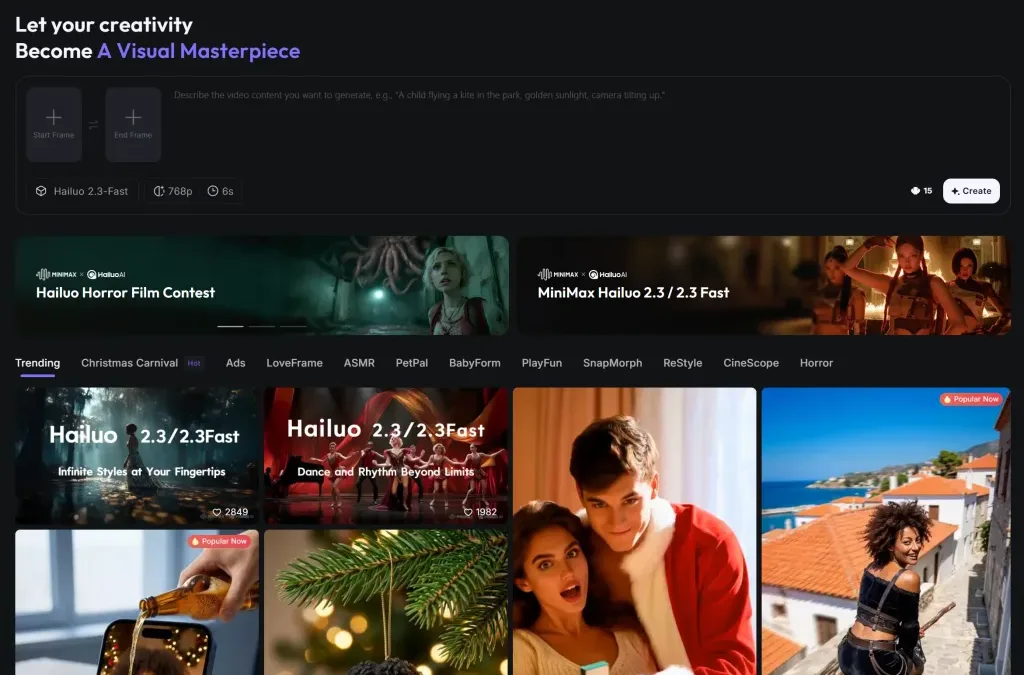

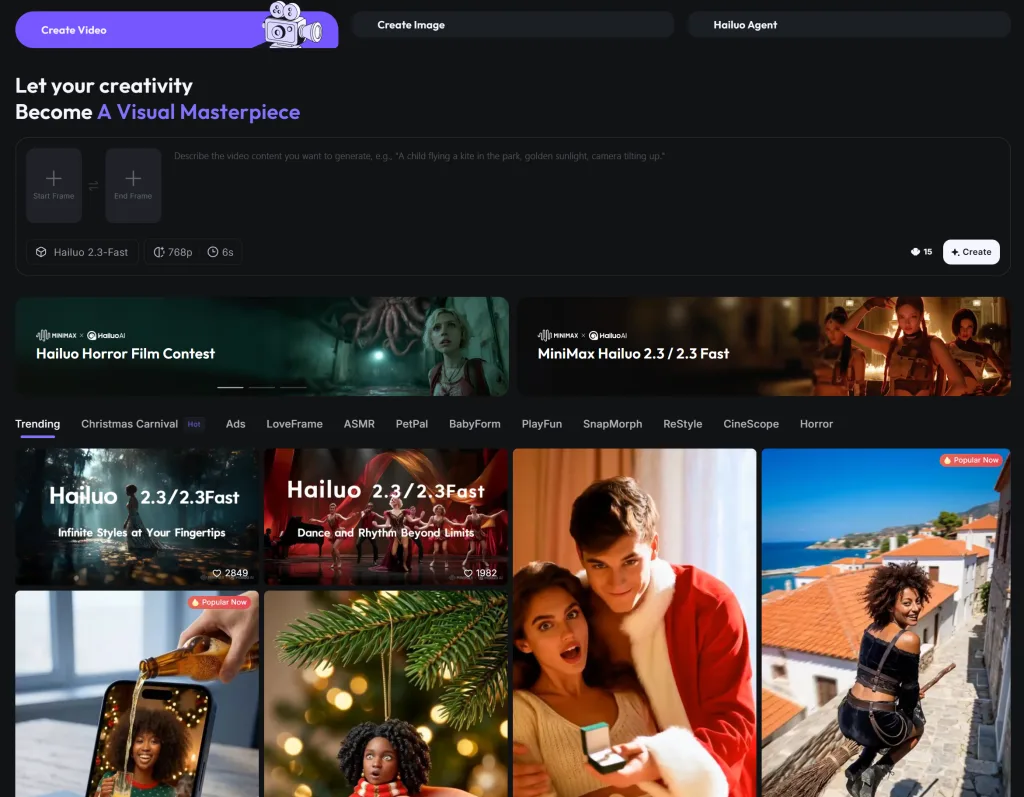

HailuoAI 海螺 AI 成為影片製作領域的一匹黑馬。它是一款由中國團隊開發的先進 AI 影片生成工具,擁有強大的「文字轉影片」與「圖像轉影片」能力,讓使用者無需任何剪輯技巧,就能快速生成令人驚豔的影片作品。

🎬 一句話:每個想法都是一部大片

海螺 AI 的核心宗旨就是——「每個想法都是一部大片」。無論你是內容創作者、社群經營者還是行銷人員,只要透過簡單的文字敘述或靜態圖片,就能讓 AI 將你的想像變為動態影片。其操作流程極為簡單直覺,支援中文提示詞,因此特別適合華語內容創作者使用。

✨ 核心特色與功能

🧠 1. 文字轉影片(Text-to-Video)

使用者只需輸入一段文字描述,海螺 AI 就能根據提示詞生成一段影片。這個過程中,AI 會自動理解場景、動作與情緒,快速渲染出高品質短片,無需剪輯工具或專業技巧。

🖼️ 2. 圖像轉影片(Image-to-Video)

不只文字,海螺 AI 也能將靜態圖像「活化」。只要上傳一張照片,它就能為圖片添加動態效果、鏡頭運動與動畫動作,使靜態內容變成引人注目的影片。

🌍 3. 多語言與中文支援

相較於某些只支援英語操作的工具,海螺 AI 不僅支援多語言輸入,更對中文提示詞有良好理解能力,讓華語使用者能直接用母語敘述想法,就能有效生成影片內容。

🚀 為什麼它值得關注?

HailuoAI 海螺 AI 的優勢在於其“先進 AI 影片製作”的地位:它不只是一個簡單的素材素材生成器,而是具備 電影級視覺效果生成能力 的 AI 平台。使用者可以在短時間內快速從文字或圖像生成高品質影片,節省大量剪輯時間,並擴大創作可能性。

此外,它也提供免費體驗方案,讓新手能零成本嘗試創作。雖然生成影片的長度目前傾向於短片(如約 5~6 秒影片為主),但對於社群貼文、短影音內容來說,已相當實用。

🛠️ 使用小技巧

- 提示詞描述越詳盡 → 輸出影片越精準

- 結合圖像與文字 → 可創造更具故事感的影片

- 善用主體參考功能 → 讓同一角色在不同場景中保持一致性

官方網站

https://hailuoai.video

by rainchu | 12 月 18, 2025 | AI, 圖型處理, 影片製作

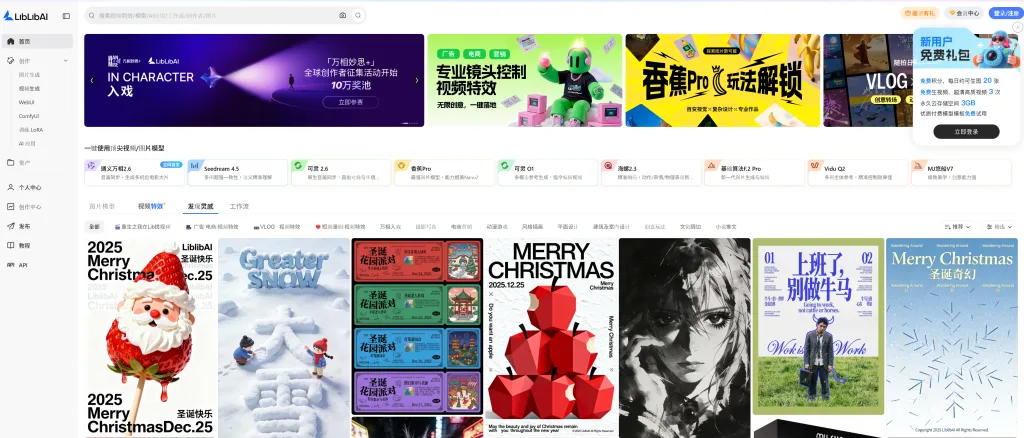

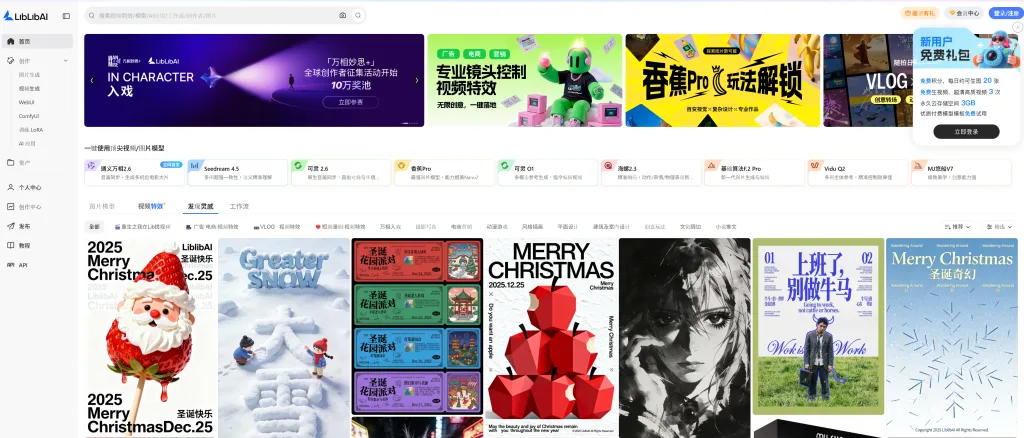

眾多 AI 創作平台之中,Liblib 憑藉其高度整合的功能、生態完整度以及對中文使用者的極致友善設計,迅速成為中國最領先的 AI 創作平台之一。

一站式 AI 影像與視頻創作平台

Liblib 不僅僅是一個圖片生成網站,而是一個超級齊全的 AI 創作平台,涵蓋:

- AI 圖片生成

- AI 視頻特效與動畫

- 模型管理與分享

- 視覺化工作流(Workflow)

- LoRA 訓練與應用

透過雲端化的設計,使用者無需自行架設環境,即可直接在瀏覽器中使用高階 AI 生成能力。

深度整合 WebUI 與 ComfyUI

對於熟悉 Stable Diffusion 生態的使用者而言,Liblib 最大的優勢之一,在於它同時支援:

- WebUI:操作直覺、上手快速,適合大多數創作者

- ComfyUI:節點式工作流,適合進階用戶進行複雜控制與自動化生成

這種雙軌並行的設計,讓初學者與專業用戶都能在同一平台中找到最適合自己的創作方式。

強大的 LoRA 訓練能力

Liblib 在 LoRA 訓練方面表現尤為突出,提供完整且視覺化的訓練流程:

- 上傳資料集即可開始訓練

- 支援多種風格與角色 LoRA

- 訓練完成後可直接套用於生成

- 社群分享與模型市集機制

這讓創作者能快速打造專屬風格模型,大幅降低 AI 模型訓練的門檻。

中文使用者極度友善

相較於許多國外 AI 平台對中文支援不足,Liblib 在以下方面明顯優於同類產品:

- 完整繁體與簡體中文介面

- 中文 Prompt 理解度高

- 中文模型與 LoRA 資源豐富

- 適合華語創作者的社群內容

對中文內容創作者來說,這是一個真正「為中文而生」的 AI 創作平台。

工作流與創作效率全面升級

Liblib 內建的 工作流系統(Workflow),讓使用者可以:

- 將複雜生成流程模組化

- 重複使用高品質生成邏輯

- 快速套用他人分享的創作流程

- 大幅提升商業與批量創作效率

這對於需要大量產出視覺內容的團隊與個人創作者而言,是極具價值的功能。

為什麼 Liblib 是中國最領先的 AI 創作平台?

綜合來看,Liblib 的核心優勢包括:

- ✅ 視頻特效 + 圖片模型完整整合

- ✅ WebUI 與 ComfyUI 同時支援

- ✅ 強大且易用的 LoRA 訓練

- ✅ 中文高度友善,資源豐富

- ✅ 從新手到專業用戶皆適用

這不僅是一個工具,更是一個完整的 AI 創作生態系。

官方網站

👉 Liblib 官方平台

https://www.liblib.art/

by rainchu | 12 月 15, 2025 | AI, 影片製作

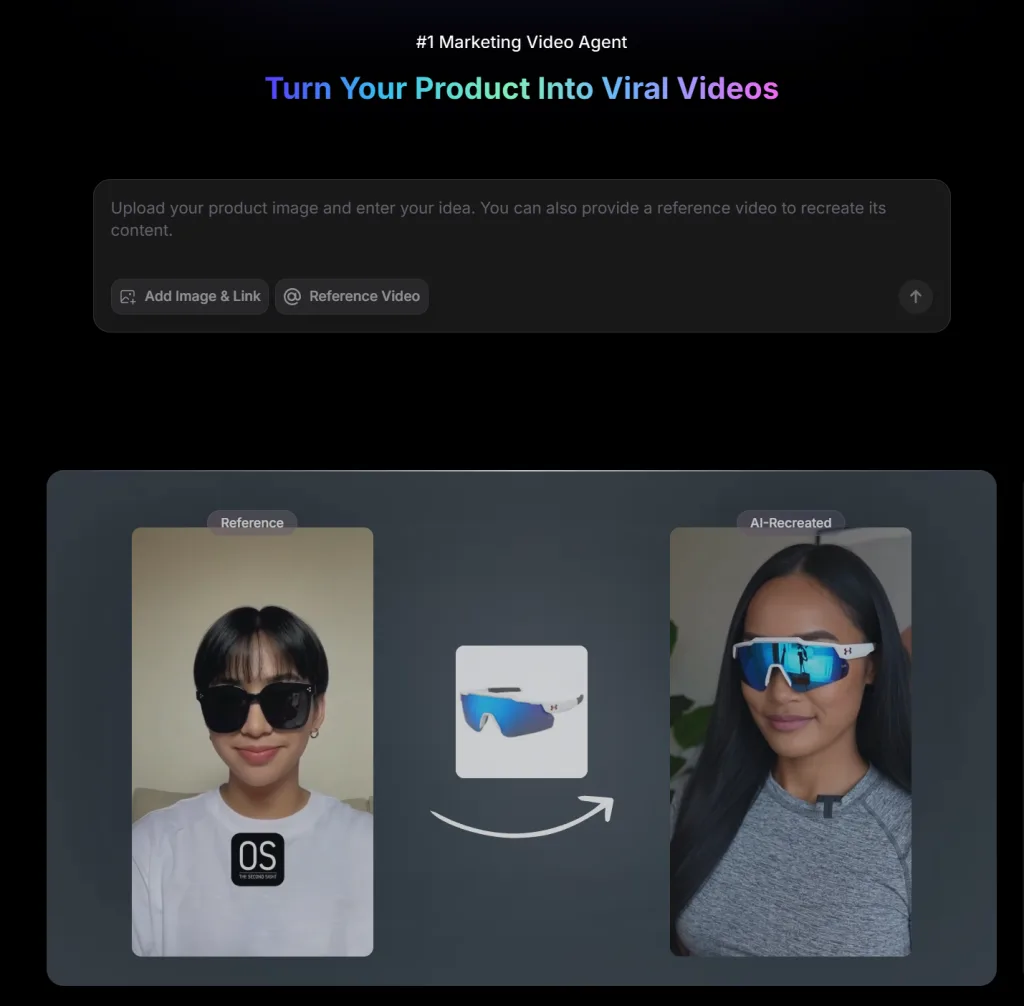

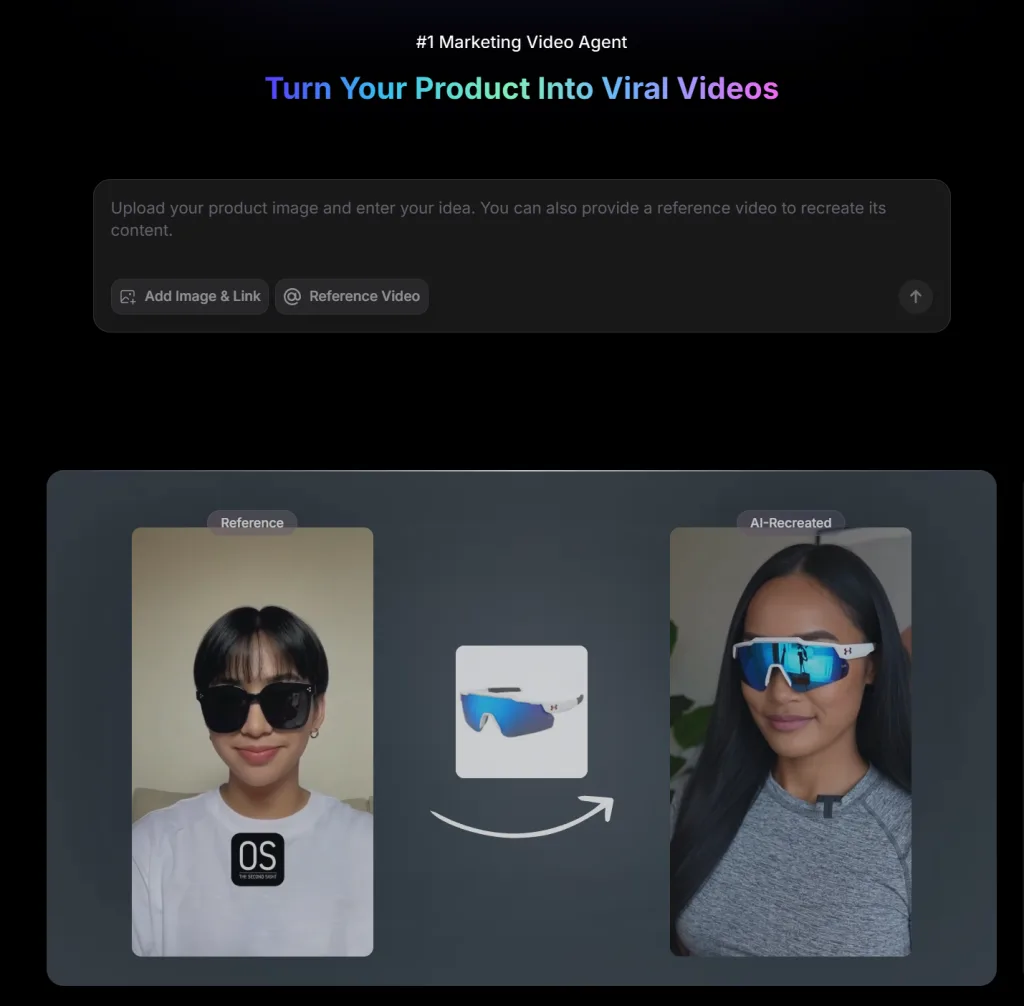

只要一張產品圖,AI 就能直接拍片帶貨!

你還在為了拍產品影片煩惱嗎?

要找模特、租場地、剪影片,成本高又耗時?現在,只要一張產品圖,AI 就能直接幫你拍好完整的帶貨影片!

這次要介紹的,就是近期在電商圈與自媒體圈爆紅的 Topview AI,全新升級的 Topview Avatar 2 與 Avatar 4,已經把「AI 虛擬人帶貨」推進到全新等級。

不用真人出鏡、不用攝影棚、不用學剪輯,AI 直接生成 會說中文、唇形同步、動作自然的虛擬帶貨主播,真的非常誇張。

Topview AI 是什麼?為什麼這麼多人在用?

Topview AI 是一款專為行銷與電商打造的 AI 行銷影片生成工具,最大特色就是:

- 只需要 產品圖片 + 文字腳本

- AI 就能自動生成完整的 產品介紹、開箱、廣告影片

- 適用於 電商賣家、接業配、自媒體、品牌行銷、個人 IP

現在很多賣家,已經直接用 Topview 來 批量產出短影音、廣告素材、Reels、Shorts、TikTok 帶貨影片。

🔥 Topview Avatar 2 / Avatar 4 核心特色整理

✅ 能控制角色的手勢、動作(重點)

你不再只能站樁式講話,而是可以用文字指令控制虛擬人:

- 指向產品

- 拿起商品展示

- 換姿勢、換站位

- 走動、比手勢、互動式介紹

讓影片看起來 更像真人業配,而不是呆板 AI。

✅ 支援穿戴展示,大小型商品都 OK

不論你是賣:

- 衣服、褲子、鞋子、包包

- 配件、飾品

- 3C、保養品、小家電

Topview 都可以讓角色 直接穿上你的商品,或是 手持展示大型或小型商品,不再只是把圖片貼在旁邊。

✅ AI 直接生成虛擬帶貨主播(還會說中文)

Topview 的虛擬主播:

- 支援 中文語音

- 唇形高度同步

- 語氣自然,適合業配、銷售、介紹影片

- 可選寫實風、卡通風、寵物風、創意風

甚至你可以讓 卡通角色、虛擬人、寵物角色 幫你帶貨,內容更有記憶點。

✅ 任何產品 × 任何場景,自由搭配

現在你可以做到:

- 把產品放進 任何背景場景

- 讓角色穿上你指定的衣服

- 拿著產品介紹特色

- 搭配創意背景,拍出超有梗的廣告

不用再受限於現實拍攝條件,想像力就是你的攝影棚。

🚀 Topview Avatar 4:直接把 AI 虛擬人拉到下一個等級

最新的 Topview Avatar 4,真的可以說是進化版中的進化版:

- 上傳照片,生成你的 專屬虛擬分身

- 可換身體、換服裝、換動作

- 支援更長的影片(最長可到 2 分鐘)

- 多種模板風格自由選擇

- 更自然的口型同步與肢體動作

不論你是要經營 品牌虛擬人、個人 IP、或長期帶貨角色,這一版真的非常值得研究。

誰最適合用 Topview AI?

如果你是以下族群,Topview 幾乎是必備工具:

- 電商賣家(蝦皮、Shopify、官網)

- 接業配的自媒體創作者

- 想經營虛擬人、個人 IP 的創作者

- 行銷公司、品牌方

- 不想出鏡,但又想拍影片的人

很多用戶已經靠 Topview 穩定產出內容+持續帶貨變現。

💰 Topview 收費與方案說明

👉 Topview AI 註冊連結

https://www.topview.ai/?via=ecomplus

Topview 提供免費與付費會員方案:

免費會員

付費會員(建議)

- 每月 29 美元

- 每月 80 積分

- 可製作高畫質 Avatar 2 / Avatar 4 影片

- 平均每支影片成本不到台幣 50 元

- 年繳方案價格更優惠

與傳統真人拍攝相比,Topview 能用 極低成本批量產出高品質行銷影片,對需要大量素材的賣家來說,CP 值非常高。

實際價格與方案請以 Topview 官網最新公告為主

官方網站

by rainchu | 12 月 15, 2025 | AI, 影片製作

✨ 評測機構最佳影片剪輯軟體:Filmora AI 賦能,你也是剪輯大師

現代影片創作者越來越仰賴智能剪輯工具來提升效率與作品品質, Wondershare 旗下的 Filmora 便是一款兼具 易用性與 AI 能力 的影片剪輯軟體,無論你是新手、行銷人員、還是專業剪輯者,都能輕鬆上手並創作出具有專業感的作品。

🎬 一、直覺操作 + AI 加速創意流程

Filmora 提供清晰易懂的操作介面,搭配智能化的 AI 功能,讓剪輯流程不再繁瑣。無論你是初次剪片或進階創作者,都能有效縮短學習曲線並加速製作流程。Filmora 不只提供基本剪輯工具,更加入 AI 驅動的智能剪輯、自動字幕與語音處理等功能,大幅提升效率。

✏️ 二、鋼筆工具與動態路徑控制:精準掌握每一格畫面

其中 鋼筆工具(Pen Tool) 是 Filmora 一大亮點,可讓你:

- 自由繪製動態路徑

- 控制動態軌跡的曲線與速度

- 套用到文字、圖像與圖層上

- 透過 關鍵影格(Keyframes) 微調動作,使畫面過渡自然流暢

這項工具不需外部插件就能在時間軸上直接繪製動畫路徑,讓你打造更具故事性與視覺張力的動態畫面。

📊 三、動態圖表套用:讓資訊表現更具說服力

除了影片剪輯,Filmora 也支援將資料套用至 動態圖表,透過動畫與視覺效果強化資訊表現,不論是:

- 行銷影片中的 KPI 呈現

- 簡報影片中的數據分析

- 產品報告或企劃影片

這功能超好用,可以做出很多超專業的YT他們的專業影片,可以讓抽象數據具體化、呈現更專業的視覺吸引力。

這種結合多媒體與資訊可視化的能力,是傳統剪輯工具較難一次做到的。整體來說,它非常適合 行銷影片與專業簡報內容製作。

🤖 四、AI 擴增場景:智慧剪輯、字幕與生成效率提升

Filmora 不僅提供基礎剪輯功能,還整合了多項 AI 擴增工具:

- 智慧剪輯與自動選段:快速抽取影片精華片段,剪出短片或精簡版內容,大幅提高編輯效率。

- AI 影片翻譯與動態字幕:支援多語字幕生成,甚至連人物唇型都可同步調整。

- AI 去背與人像偵測:精準移除背景,讓場景創作更加靈活。

- Copilot 2.0 智能助理:高效協助批次處理與素材搜尋。

這些 AI 加速工具使得剪輯過程不再只是 手動剪接,而是變成具策略性、智能化的創作流程。

📈 五、適合所有創作者的剪輯方案

Filmora 提供跨平台支援(Windows、macOS、iOS、Android),不論你是在電腦、平板或手機,都能隨時製作影片。內建豐富的 模板、特效、音樂與轉場效果,大幅提升作品的可看性與質感。

此外,官方也提供試用版讓你先體驗功能,再決定是否購買完整版。整體評價指出它非常適合社群短片、YouTube 影片與教學影片等多種創作場景。

🎬 Filmora 與 剪映 CapCut 的主要差異比較

🆚 1. 功能定位與使用者族群

- Filmora:設計上結合 直覺操作界面 + 專業剪輯能力,非常適合從入門到進階剪輯者。Filmora 支援豐富的 AI 工具與精細控制功能,例如鋼筆路徑、關鍵影格等進階細節表現,適合製作行銷影片、專業簡報或內容品牌影片等。

- 剪映(CapCut):由 TikTok / ByteDance 支援,主打 簡單、快速、免費 的剪輯體驗,對於製作短影片、社群內容非常友好,尤其適合初學者或需要大量快速輸出短影片的工作者。

🛠️ 2. 操作介面與學習曲線

- Filmora:介面直覺但功能更全面,適合中階創作者深入調整每個細節。時間軸控制精準,支援雙時間軸、動態路徑與微調功能,提升影片細節掌控感。

- 剪映:主打 極簡操作,拖放式編輯非常容易上手,對於不想投入太多剪輯學習時間的使用者尤其友善。

🤖 3. AI 自動化剪輯與進階功能

- Filmora:提供包括 AI 智能蒙版、AI 去背、人像分離、動態字幕、AI 影片延長 等多種 AI 功能,可以用來提升影片品質與創意表現。

- 剪映(CapCut):同樣具備 AI 自動字幕、AI 去背、熱門模板、一鍵成片 等工具,對於快速產出影片與社群導向內容非常有效。

🌐 4. 平台與成本

- Filmora:提供 Windows、macOS 與行動裝置版本,功能完整但某些進階素材與模板可能需要額外付費或訂閱。

- 剪映(CapCut):本身以免費使用為主(含大部分功能),無浮水印且可跨平台使用(例如手機、桌面與網頁版),對預算有限的創作者非常友好。奇寶網路 –

📈 5. 適用場景總結比較

| 對比項目 | Filmora | 剪映 CapCut |

|---|

| 初學者上手難易 | ⭐⭐⭐ | ⭐⭐⭐⭐⭐ |

| 多軌與精細控制 | ⭐⭐⭐⭐⭐ | ⭐⭐⭐ |

| AI 進階功能 | ⭐⭐⭐⭐ | ⭐⭐⭐ |

| 社群短影片效率 | ⭐⭐⭐⭐ | ⭐⭐⭐⭐⭐ |

| 專業影片剪輯 | ⭐⭐⭐⭐ | ⭐⭐ |

| 成本 | 中等/付費方案 | 免費為主 |

參考資料

官方網站

https://filmora.wondershare.tw/

延伸閱讀

by rainchu | 12 月 14, 2025 | AI, 影片製作, 音樂

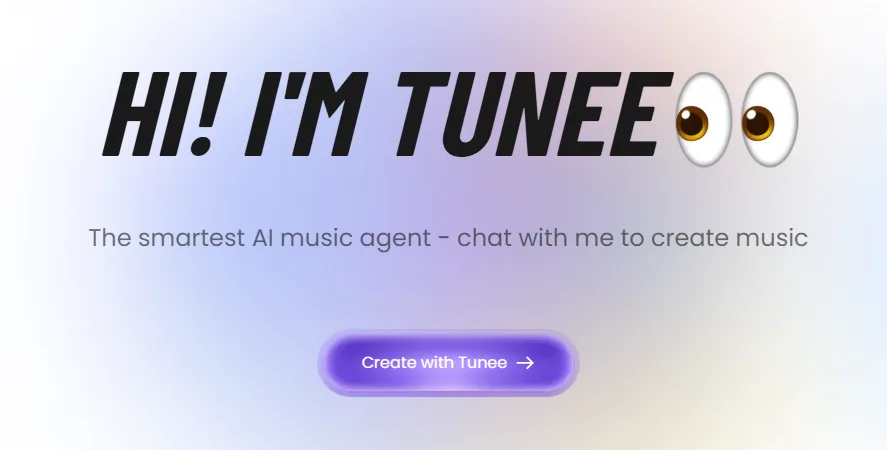

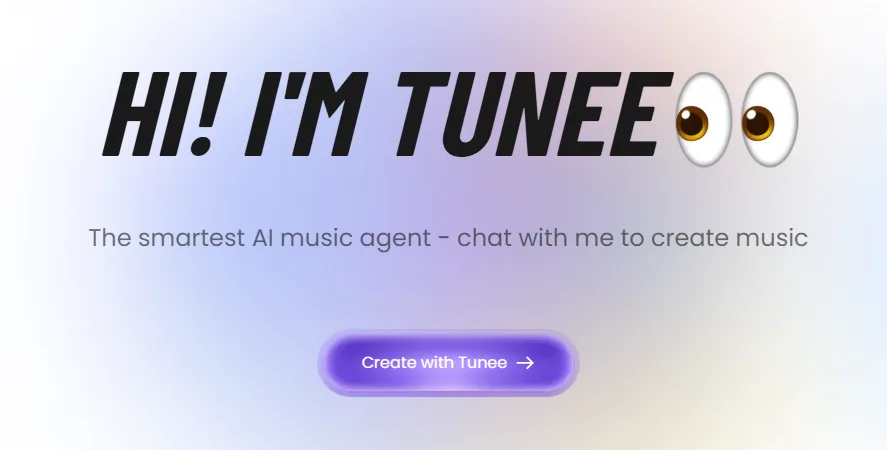

Tunee.AI 不只是能「生音樂」,它更厲害的是真正理解畫面、情緒與旋律邏輯,甚至可以把你生成的音樂直接自動拍成一支完整 MV。

不是套模板、不是隨便剪,而是從音樂情緒出發,重新定義 AI 音樂創作流程。

這篇文章將完整帶你體驗 Tunee AI 的實際玩法,並解析為什麼它被稱為「Suno 殺手」。

👉 官方網站:

https://www.tunee.ai/

🎵 圖片轉音樂|對話式圖片生音樂

Tunee AI 最讓人驚豔的功能之一,就是 「圖片 → 音樂」。

你只需要上傳一張圖片,例如:

Tunee AI 會解析畫面情緒、色調與構圖,並透過對話方式詢問你想要的:

- 曲風(流行、抒情、電子、Lo-fi…)

- 情緒(憂鬱、溫暖、熱血、浪漫)

- 語言與人聲設定

這不是單向指令,而是真正的「對話式 AI 作曲體驗」,成品自然度遠超傳統 AI 音樂模板。

🎥 影片轉歌曲|影片解析生成完整歌曲

接下來這個功能,直接顛覆創作者的想像。

Tunee AI 可以:

👉 上傳影片 → 自動生成一首完整歌曲

系統會分析:

然後生成:

這對於:

幾乎是 一鍵完成專屬主題曲,效率直接拉滿。

🎼 風格化音樂生成

很多人用 AI 音樂最怕的就是:「學不像」。

Tunee AI 在「風格化生成」這一塊,表現非常成熟。

你可以指定參考曲目(例如:周杰倫《晴天》),但 不會抄旋律、不侵權。

AI 只會學習:

生成的作品:

✔ 有熟悉感

✔ 但旋律完全原創

✔ 非常適合商用與創作發表

🌍 二創外文歌曲|AI 多語音樂製作

Tunee AI 在「語言與人聲」方面,也明顯優於許多 AI 音樂平台。

支援:

你可以進行:

- 外文歌曲二次創作

- 中文歌改英文版

- 不同語言同旋律版本

而且咬字自然、情緒到位,已經接近真人歌手水準。

🎬 AI 自動拍 MV|生成音樂 MV 長片

這一段,就是 Tunee AI 封神的關鍵。

Tunee AI 可以:

👉 把你生成的音樂,自動轉成一支完整 MV

不是簡單素材拼接,而是:

- 根據音樂段落切換畫面

- 副歌自動放大情緒張力

- 視覺節奏完全貼合旋律

生成的是「可直接上架 YouTube 的 MV 長片」,

對創作者來說,等於 音樂 + 影像一次完成。

🔥 Tunee AI 為什麼被說是「Suno 殺手」?

| 功能 | Tunee AI | Suno |

|---|

| 圖片轉音樂 | ✅ | ❌ |

| 影片轉歌曲 | ✅ | ❌ |

| 對話式作曲 | ✅ | ❌ |

| 風格理解深度 | 高 | 中 |

| AI 自動拍 MV | ✅ | ❌ |

結論只有一句話:

Tunee AI 是一套「完整的 AI 音樂 + 影像創作系統」,不是只有生歌。

✅ 適合哪些人使用?

- YouTuber / 短影音創作者

- 音樂創作新手

- 廣告、品牌行銷

- 想快速產出原創歌曲與 AI MV 的創作者

👉 官方入口:

https://www.tunee.ai/

by Rain Chu | 9 月 3, 2025 | AI, 影片製作

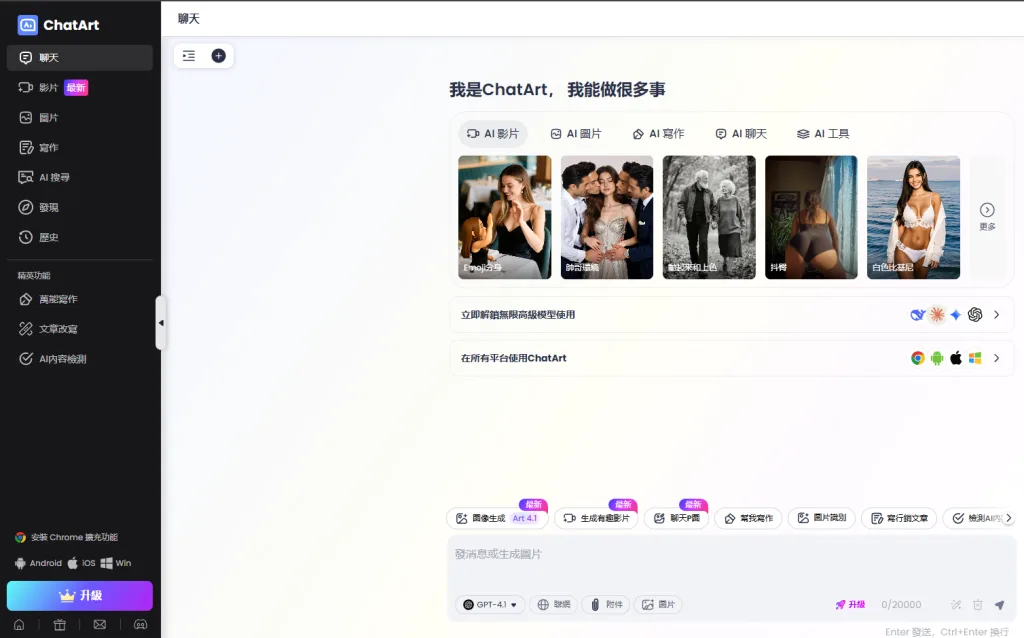

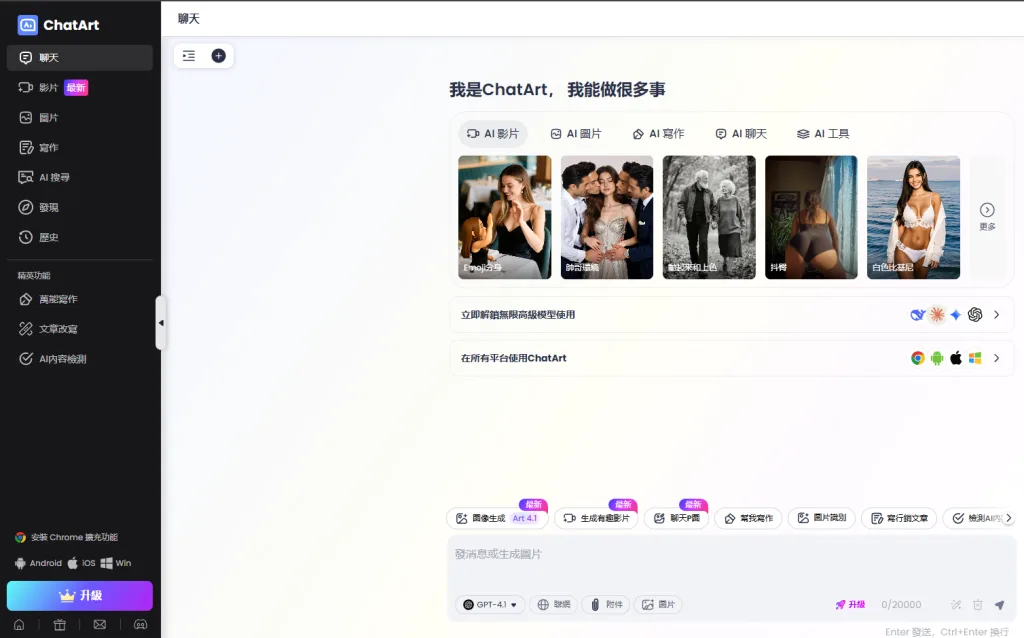

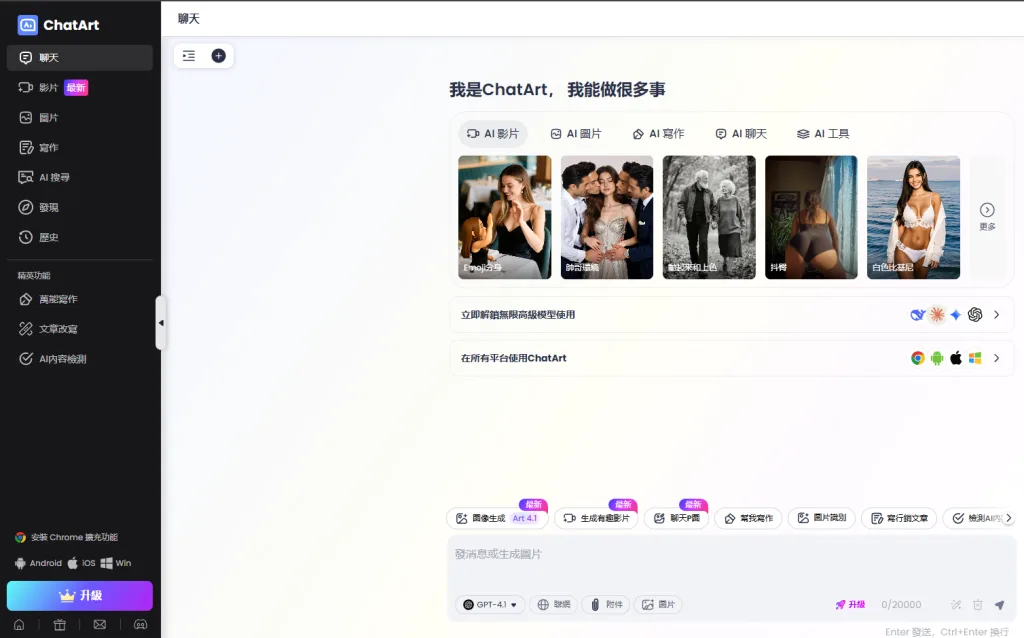

你還在用 ChatGPT 當小說幫手嗎?那你一定得看看這款全網最狂的 AI 創作工具 —— ChatArt Pro。它擁有隱藏版「成人模式(NSFW Mode)」,可寫言情/成人小說,搭配特色影片生成,創意創作完全無限制!

功能亮點一覽

- NSFW 成人模式:啟動「Romance Interaction Mode」或「大人模式」後,創作範圍無內容限制,可書寫成人言情小說與影片腳本,突破 ChatGPT 等 AI 工具的門檻限制。

- 小說/短片生成:除了小說文本(言情、成人情節),還可將故事情節轉成短片腳本,結合影像模板快速生成影片內容。

- 完全免費、無次數限制:提供無限制創作,讓創作者自由產出長篇小說或影片,不受用量限制。

- 流程直覺易操作:無需技術門檻,文字敘述輸入後即生成完整小說章節或影片片段,適合一鍵創作。

使用教學步驟(以小說生成功能為例)

- 訪問 ChatArt Pro 網站(

app.chatartpro.com)。

- 開啟「Global Settings」進入設定頁面,填寫小說標題、背景設定、角色資訊、風格偏好等。

- 啟用「Romance Interaction Mode」(大人模式),解鎖成人創作功能。

- 點擊「Go to Story Generation」進入小說生成工具。

- 按「Generate」開始生成小說,AI 會即時輸出完整章節。

- 若想整理段落內容,可按「Apply」或「Copy」,進行編輯與保存。

實測心得與注意事項

- 創作自由度高:能透過簡短文字提示生成完整成人小說,創作氛圍更加自由與大膽。

- 生成速度快、連貫性佳:整體體驗流暢、情節銜接自然,挺適合構想故事骨架。

- 浮水印與進階功能:若要無浮水印匯出影片或小說建議,可考慮升級 Pro 版本。

- 使用需注意道德與法律界線:請務遵循本地法律與使用條款,禁止未滿 18 歲使用及違法內容生成。

參考資料

https://app.chatartpro.com

近期留言