by rainchu 12 月 16, 2025 | AI , 人臉辨識

前言:為什麼需要專門的人臉辨識 YOLO?

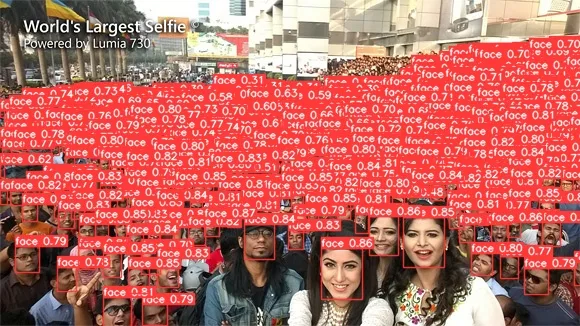

在電腦視覺領域中,YOLO(You Only Look Once) 以「即時、快速、準確」聞名。然而,通用的物件偵測模型在面對「人臉」這種尺寸小、變化大、環境複雜 的目標時,仍然存在效能瓶頸。

這正是 YOLO Face 誕生的原因——它是 YOLO 家族中,專為臉部辨識打造的專家級模型 。

什麼是 YOLO Face?

YOLO Face 是基於 YOLO 模型架構延伸而來的人臉偵測模型,由 YapaLab 開發並開源於 GitHub。

📌 官方專案https://github.com/YapaLab/yolo-face

YOLO Face 的三大核心特色

🚀 1. 搭配 YOLO 模型框架,快速且準確地找出人臉

YOLO Face 繼承 YOLO 單階段(One-stage)偵測的優勢:

單次前向推論即可完成偵測

高 FPS,適合即時影像串流

可部署於 GPU、Edge 裝置、嵌入式系統

這讓 YOLO Face 非常適合應用於:

🌙 2. 在黑暗或極度複雜環境中依然能偵測人臉

相較於傳統臉部偵測方法,YOLO Face 在訓練時納入多種困難場景:

低光源、夜間畫面

背光或強烈光影

遮擋、多人重疊

複雜背景干擾

即使在幾乎「看不清楚」的影像條件下,仍能穩定框出人臉位置,這對安防與戶外應用尤其重要。

⚽ 3. 準確且快速地追蹤足球比賽中的足球員

你可能會好奇:臉部辨識為何能應用在足球比賽?

答案是:

YOLO Face 能夠:

在快速移動的畫面中鎖定球員臉部

協助後續的球員追蹤(Tracking)

結合 Re-ID、戰術分析、轉播輔助系統

這讓 YOLO Face 不只是一個臉部辨識模型,更是運動分析與智慧影像的重要基石 。

YOLO Face 適合哪些應用場景?

智慧監控與安防系統

夜間人臉偵測

體育賽事影像分析

智慧城市

邊緣運算(Edge AI)

即時串流分析系統

by Rain Chu 8 月 29, 2025 | AI , 圖型處理 , 影片製作

如何輕鬆地運用 AI 技術,讓影片或直播畫面擁有透明背景 ,無需繁鎖編輯與圖層操作!今天分享的工具是使用 InSPyReNet 提供的開源套件

工具簡介:什麼是 transparent-background[webcam]?

核心技術 :基於 InSPyReNet(ACCV 2022)所提出的 AI 去背演算法,支援圖片、影片甚至 webcam 的背景移除功能 。Python 套件 :名稱為 transparent-background,採 MIT 授權,可自由商業使用。強大特色 :

支援多種輸出模式:如 RGBA(透明背景)、saliency map、綠幕、背景模糊、overlay 等。

支援 webcam 輸入,但 Linux 上需安裝 v4l2loopback 才能建立虛擬攝影機

安裝與依賴設定(含 webcam 支援)

安裝套件 :

pip install transparent-background[webcam] 若使用 Linux,請安裝 webcam relay :

git clone https://github.com/umlaeute/v4l2loopback.git && cd v4l2loopback

make && sudo make install

sudo depmod -a

sudo modprobe v4l2loopback devices=1

CLI 快速範例

transparent-background --source 0 --dest output_folder --type rgba 參數說明:

--source 0 表示 webcam 輸入(一般第一支 webcam 為 0)。--type rgba 代表輸出為帶 alpha 通道的透明背景影像。map、green、blur、overlay 或指定背景圖

用於單一影片檔案

Python API 範例:

讀取 webcam 並顯示去背畫面

import cv2

from transparent_background import Remover

remover = Remover()

cap = cv2.VideoCapture(0) # 開啟預設 webcam

while True:

ret, frame = cap.read()

if not ret:

break

# 處理去背結果(RGBA)

out = remover.process(frame, type="rgba")

cv2.imshow("Transparent Webcam", out)

if cv2.waitKey(1) & 0xFF == ord('q'):

break

cap.release()

cv2.destroyAllWindows()

📖 transparent-background 參數說明

--source [SOURCE](必填)指定輸入的資料來源,可以是:

單張圖片 :例如 image.png圖片資料夾 :例如 path/to/img/folder單個影片檔 :例如 video.mp4影片資料夾 :例如 path/to/vid/folder整數 :用於指定 webcam 地址,例如 0(對應 /dev/video0 的攝影機)

--dest [DEST](可選)輸出結果存放的資料夾,若未指定,則預設為當前工作目錄 。

--threshold [THRESHOLD](可選)設定硬性去背的閾值,範圍為 0.0 ~ 1.0 。

不建議與 soft prediction 同時使用 ,若未設定,系統會使用「軟性預測」來生成更自然的透明效果。

--type [TYPE](可選)選擇輸出的背景類型,預設為 rgba:

rgba :輸出帶透明通道的影像(alpha map),若未設定 threshold,會自動透過 pymatting 進行前景提取。⚠️ 此模式不適用於影片或 webcam 。map :輸出純粹的 saliency map(灰階遮罩)。green :將背景換成綠幕。white :將背景換成純白色(由 [carpedm20] 貢獻)。‘[255, 0, 0]’ :使用指定的 RGB 顏色作為背景(需加單引號)。blur :將背景模糊處理。overlay :以半透明綠色覆蓋前景並突顯邊緣。另一張圖片 :可指定圖片路徑(例如 samples/background.png),前景會直接疊加在該背景上。

--ckpt [CKPT](可選)使用其他模型檔(checkpoint)。

--mode [MODE](可選)指定運行模式:

base :標準模式。base-nightly :使用 nightly release 版本的 checkpoint。fast :快速模式,速度快但可能在細節上略有損失。

其他選項

--resize [RESIZE]

static(預設):輸出尺寸固定。dynamic:生成更清晰的邊緣,但可能不穩定。

--format [FORMAT]--reverse前景移除 、保留背景(官方玩笑稱為「transparent-foreground」模式 😆)。--jit

範例

單張圖片去背 (輸出透明 PNG):

transparent-background --source input.png --dest output --type rgba 處理整個資料夾的圖片,並輸出模糊背景效果 :

transparent-background --source ./images --dest ./results --type blur 即時 webcam 去背 (Linux 需安裝 v4l2loopback):

transparent-background --source 0 --dest ./webcam_output --type green 更換背景為自訂圖片 :

transparent-background --source video.mp4 --dest ./output --type 'backgrounds/bg.png' GUI 模式

安裝 GUI 支援

pip install --extra-index-url https://download.pytorch.org/whl/cu118 transparent-background[gui] # with gui dependency (flet) 開啟 GUI

transparent-background-gui 官方教學

VIDEO

官方網頁

https://github.com/plemeri/transparent-background

採用的演算法

https://github.com/plemeri/InSPyReNet

開源的後製影片軟體

https://kdenlive.org

參考資料

by rainchu 12 月 19, 2024 | AI , 影片製作 , 語音合成 , 音樂

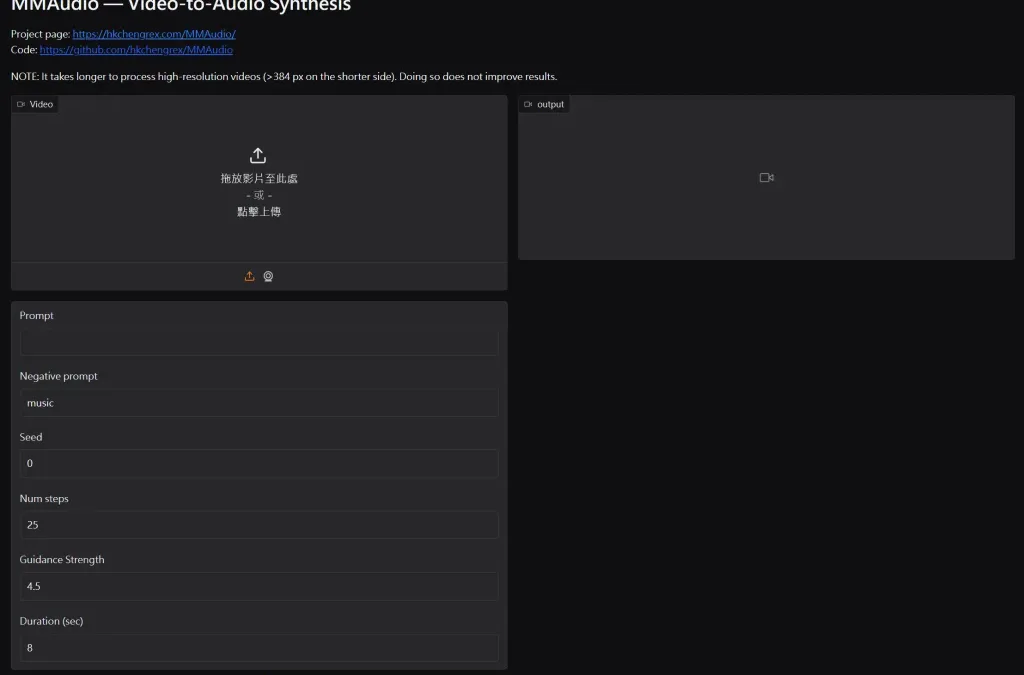

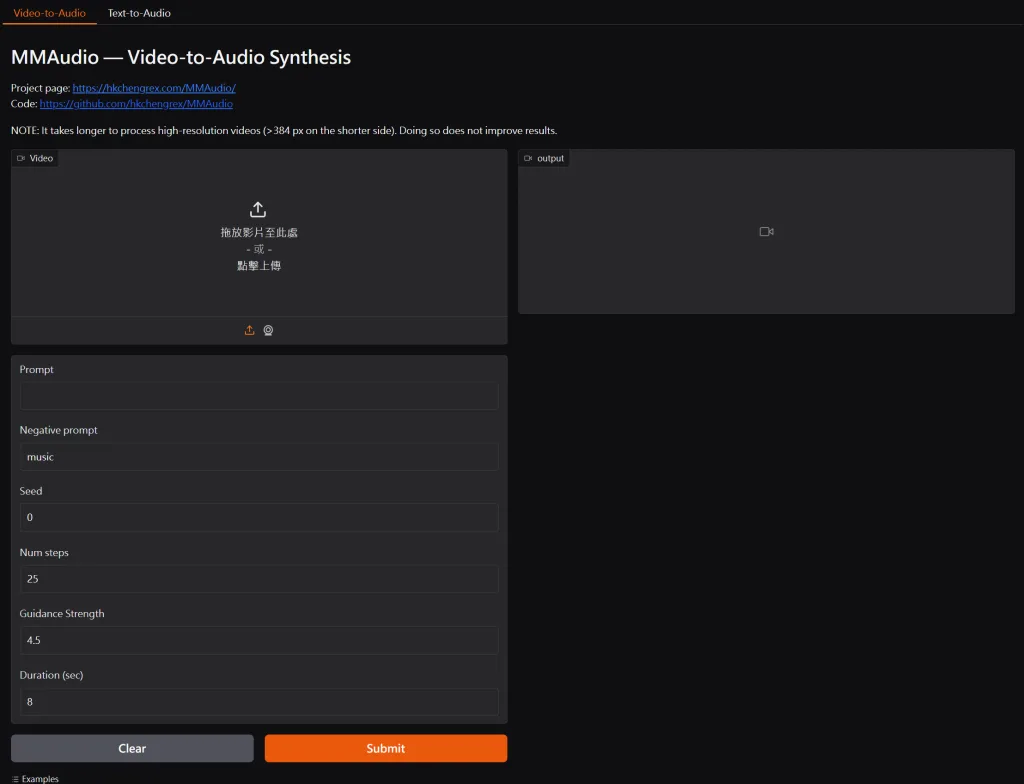

MMAudio 是一款開源的多模態影片轉音訊工具,透過多模態聯合訓練技術,可以將高品質的影片與音訊合成。該專案由伊利諾大學厄巴納-香檳分校、Sony AI 及 Sony 集團公司合作開發,適用於影片配音、虛擬角色語音等多媒體創作場景。

主要特色:

多模態聯合訓練: MMAudio 採用多模態聯合訓練方法,能夠同時處理影片和文字輸入,生成與內容同步的音訊。高品質音訊合成: 透過先進的模型架構,MMAudio 能夠生成高品質且自然的音訊,適用於各類應用場景。同步模組: MMAudio 的同步模組確保生成的音訊與影片畫面精確匹配,實現高度同步。

適用場景:

影片配音: 自動為無聲 影片生成對應的音訊,提升影片的可觀賞性。虛擬角色語音生成: 為虛擬角色生成符合其動作和表情的語音,增強互動性。多媒體內容創作: 協助創作者快速為視覺內容添加音訊,豐富作品表現力。

技術原理: MMAudio 基於深度學習技術,特別是神經網路,理解和生成音訊資料。模型能夠處理影片和文字輸入,透過深度學習網路提取特徵,進行音訊合成。在訓練時,模型考慮音訊、影片和文字資料,使生成的音訊能夠與影片和文字內容相匹配。透過同步模組,確保音訊輸出與影片畫面或文字描述的時間軸完全對應,實現同步。

使用方法: MMAudio 提供命令列介面和 Gradio 介面,使用者可以根據需求選擇使用。在命令列中,使用者可以透過指定影片路徑和文字提示,生成對應的音訊。Gradio 介面則提供了更友善的使用者介面,支援影片到音訊和文字到音訊的合成。

已知限制: 目前,MMAudio 存在以下限制:

有時會生成不清晰的語音或背景音樂。

對某些陌生概念的處理不夠理想。

相關資源:

by Rain Chu 3 月 24, 2024 | AI , 語音辨識

Whisper 是一種由 OpenAI 開發的先進語音識別系統,Whisper 的獨特之處在於其能夠處理多種語言和方言,以及在各種噪音環境下保持高水準的準確率。這一技術的開發代表了語音識別領域的一個重要進步,為多種應用場景提供了強大的支持,從自動字幕生成到語音指令的處理,再到多語言溝通的促進。

2025年更新

在 ubuntu 中直接安裝 Whisper

pip install -U openai-whisper 然後輸入 OpenAI KEY

export OPENAI_API_KEY='sk-XXXX' 接下來就可以直接辨識了,不用特別在寫程式

whisper /test.mp3 --model large-v3 --language zh --task transcribe --output_format txt Large 3 更新

2023年末的更新版本,Large 3 ,來到了3.1GB,測試後,中文的理解能力已經來到了大學生等級,相當的實用,但也相當吃硬體資源

Whisper JAX

https://huggingface.co/spaces/sanchit-gandhi/whisper-jax

如果不想安裝,只想立即使用的話,可以先點選線上版本的,直接可以測試他的效果如何,再來想應用或是考慮是否要在本地端架設一套起來

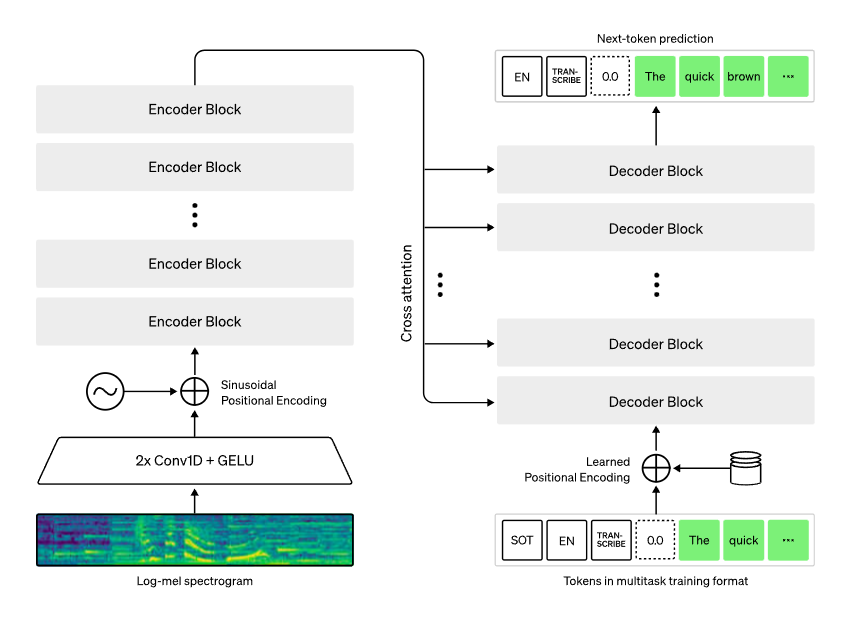

技術背景

Whisper 基於深度學習模型,特別是利用了大規模語音數據集來訓練其識別算法。這使得 Whisper 不僅能夠識別標準發音的話語,還能識別口音、方言以及非正式或口語化的表達。OpenAI 通過分析大量的語音數據,使 Whisper 能夠理解和處理語速變化、背景噪音干擾以及講話者間的交談。

功能與應用

Whisper 的應用範圍廣泛,從提高輔助聽力設備的性能到增強虛擬助理的理解能力,再到改善自動翻譯系統的質量。在教育領域,它可以幫助創建更加無障礙的學習材料,為聽障學生提供即時字幕。在媒體行業,Whisper 可以用於自動生成新聞報導或視頻內容的字幕,大大提高生產效率並擴大觀眾範圍。

性能與準確性

OpenAI 對 Whisper 的測試表明,其在多種語言和口音的識別上達到了極高的準確性。此外,Whisper 能夠辨識並適當處理專有名詞、術語以及其他複雜的語言結構。這種高水平的準確性不僅對於提供質量高的轉錄服務至關重要,也是使語音交互系統更加可靠和實用的關鍵。

下載資源

OpenAI Whisper

編譯好可以直接使用的程式

CPU版本Whisper ,Buzz 適合沒有GPU的情景使用

文章內整理了編譯版本,可以離線下載使用

by Rain Chu 3 月 3, 2024 | AI , 繪圖

LeiaPix 是一款創新的科技產品,它利用先進的人工智能技術將平面圖片轉換成3D動畫,為用戶提供了全新的視覺體驗。這項技術尤其擅長處理人物照片,能夠將靜態的2D影像轉化成仿佛跳躍出畫面的3D動態畫面,讓照片中的人物顯得更加生動、立體。

LeiaPix的工作原理是通過深度學習算法分析2D圖像中的視覺信息,如顏色、形狀、紋理等元素,並推測出圖像背後的3D結構。這包括對圖像中人物的姿態、面部表情以及與背景的相對位置進行精確解析。接著,AI利用這些信息構建出一個3D模型,並將其動畫化,使圖像中的人物仿佛被賦予了生命。

一個重要的特點是LeiaPix的用戶界面非常友好,不需要專業的3D建模技能,用戶只需上傳一張平面照片,剩下的工作就交給AI來完成。這使得任何人都能輕鬆地將自己的照片轉換成3D動畫,無論是用於社交媒體分享、個人收藏,還是作為創意項目的一部分。

此外,LeiaPix的應用範圍非常廣泛,它不僅可以用於人物照片的轉換,也適用於風景、物品等其他類型的圖片。這意味著用戶可以將任何記憶中的瞬間轉換成3D動畫,增加了與照片互動的趣味性和沉浸感。

在商業應用方面,LeiaPix也展現出巨大的潛力。例如,它可以用於廣告創意的製作,通過3D動畫吸引更多的目光;或者在電子商務中,將商品照片轉化成3D動畫,提供給消費者更直观的商品展示。

近期留言