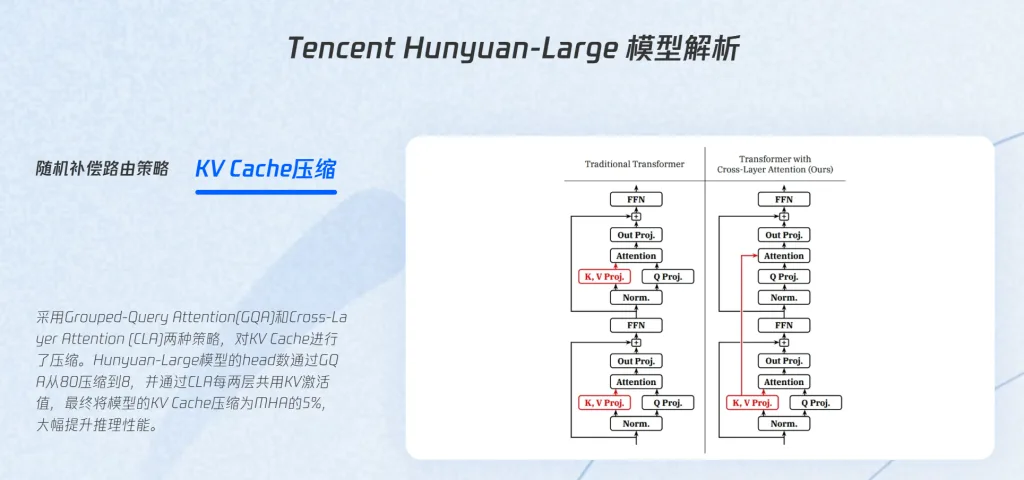

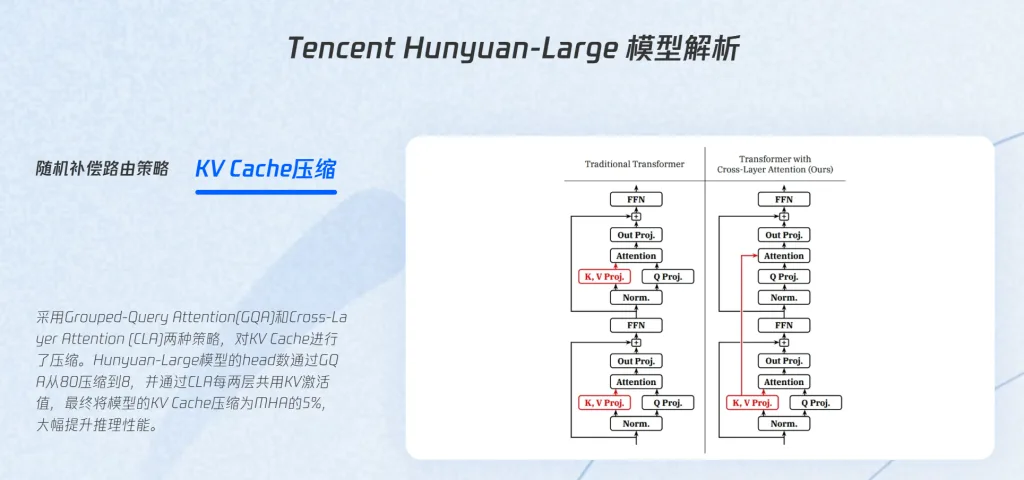

Tencent Hunyuan-Large 騰訊混元模型

Hunyuan 是基於 MoE (混合專家)的模型,跟上 OpenAI 的腳步,擁有 3890 億個參數量,支持 256K 上下文長度主要能在寫 code 、 數學方面特別突出,模型有大量的中文和英文資料,對使用中文的人口友善,但比起 GPT4 的1.8萬億參數還是差了一個數量等級

MOE

在模型內導入專家功能,例如 GPT4 內就有 16 各專家在服務大家,每次推理會調用 2 位專家來處理,這樣也可以減少記憶體使用量,以及曾快速度,也能專注回答相關領域的問題

近期留言