by Rain Chu 2 月 23, 2025 | AI , 程式開發

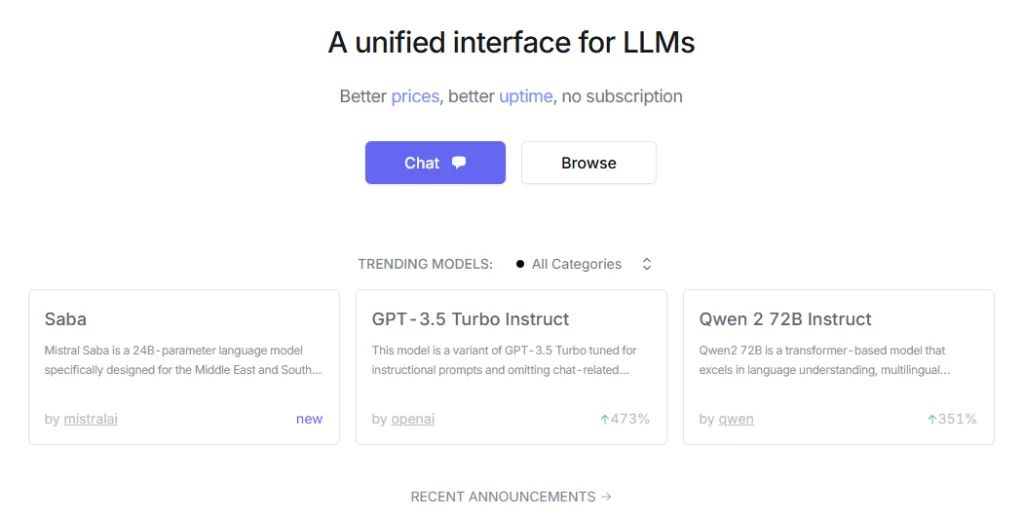

OpenRouter 是一個統一的大型語言模型(LLM)API 服務平台,可以讓使用者透過單一介面訪問多種大型語言模型。

主要特點:

多模型支援: OpenRouter 集成了多種預訓練模型,如 GPT-4、Gemini、Claude、DALL-E 等,按需求選擇適合的模型。易於集成: 提供統一的 API 介面,方便與現有系統整合,無需自行部署和維護模型。成本效益: 透過 API 調用,使用者無需購買昂貴的 GPU 伺服器,降低了硬體成本。

使用方法:

註冊帳號: 使用 Google 帳號即可快速註冊 OpenRouter。選擇模型: 在平台上瀏覽並選擇適合的模型,部分模型提供免費使用。調用 API: 使用統一的 API 介面,將選定的模型整合到您的應用中。

Cline 整合

OpenRouter 與 Cline 的整合為開發者提供了強大的 AI 編程體驗,Cline 是一款集成於 VSCode 的 AI 編程助手,支援多種大型語言模型(LLM),如 OpenAI、Anthropic、Mistral 等,透過 OpenRouter,Cline 能夠統一調用這些模型,簡化了不同模型之間的切換和管理,使用者只需在 Cline 的設定中選擇 OpenRouter 作為 API 提供者,並輸入相應的 API 金鑰,即可開始使用多種模型進行開發。這種整合不僅提升了開發效率,還降低了使用多模型的技術門檻。

DeepSeek R1

OpenRouter 現在也支援 DeepSeek R1 模型,DeepSeek R1 是一款高性能的開源 AI 推理模型,具有強大的數學、編程和自然語言推理能力。透過 OpenRouter,開發者可以在 Cline 中輕鬆調用 DeepSeek R1 模型,享受其強大的推理能力。這進一步豐富了開發者的工具選擇,讓他們能夠根據項目需求選擇最適合的模型。

by rainchu 11 月 28, 2024 | Agent , AI

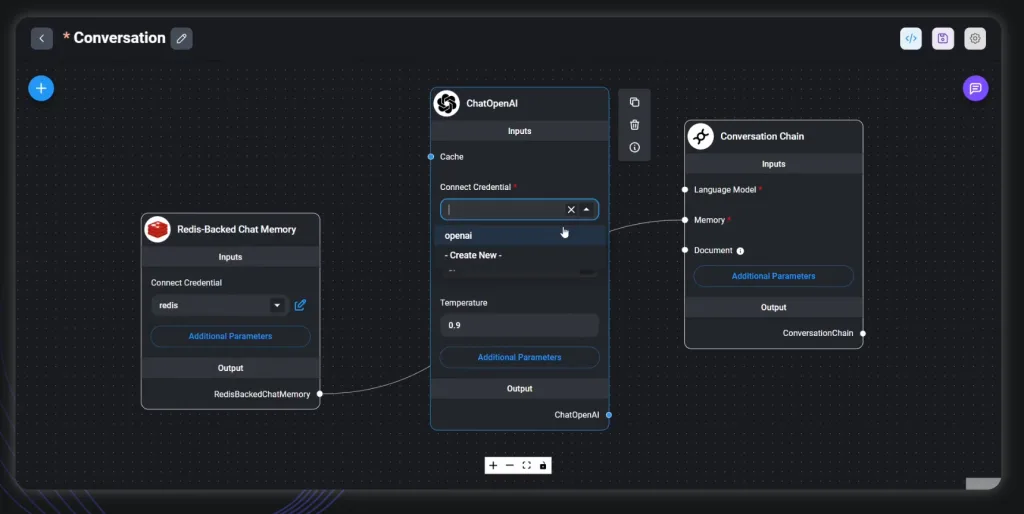

Flowise 是一款開源的低代碼工具,一般人也可以輕易地使用,用於構建自定義的大語言模型(LLM)編排流程和 AI 代理。透過直觀的拖放介面,使用者可以輕鬆設計複雜的 AI 工作流程,無需深入的程式設計知識。

Flowise 的主要特點:

開源且免費 :Flowise 完全開源,使用者可自由使用並進行二次開發,無需擔心授權問題。 GitHub 低代碼開發 :透過簡單的拖放介面,使用者可以快速構建 LLM 應用,縮短開發週期。 Flowise AI Docs 多代理支援 :Flowise 提供多代理系統,允許使用者設計可與外部工具和資料來源互動的代理,實現更高效的任務處理。 Flowise AI Docs 靈活的工作流程設計 :使用者可以根據需求,自定義工作流程的邏輯和順序,滿足不同場景的應用需求。

Flowise 與其他 AI 代理工具的差異:

與 Langflow 的比較 :Langflow 專注於自然語言處理,提供可視化介面來構建和調試語言處理流程。相比之下,Flowise 更強調 LLM 的編排和代理的靈活性,適用範圍更廣。 與 Dify 的比較 :Dify 致力於簡化 AI 應用的部署,提供一站式解決方案。而 Flowise 更專注於工作流程的設計和代理的構建,提供更大的自定義空間。 與其他工具的比較 :Flowise 的開源性和低代碼特性,使其在靈活性和可擴展性方面具有優勢,適合需要快速迭代和自定義需求的開發者。

參考資料

VIDEO

by rainchu 11 月 22, 2024 | AI , 程式 , 程式開發

LLMs Server 還是需要放在 Linux 環境中比較好,但開發階段常常用 Windows 在開發,多數人使用的 Shell export 就沒法使用

export OPENAI_API_KEY="sk-...". Windows中設置LLM環境變數的幾種方法解決方法

使用命令列 CMD

set OPENAI_API_KEY=sk-... 使用 PowerShell

[Environment]::SetEnvironmentVariable("OPENAI_API_KEY", "sk-...", "User") 放在 Python 程式中

import os

# 設置環境變數

os.environ['OPENAI_API_KEY'] = 'sk-你的API密鑰'

# 之後就可以使用這個環境變數了

# 例如,當使用OpenAI的API時,就可以從環境變數中獲取API密鑰

api_key = os.environ['OPENAI_API_KEY']

print("API Key:", api_key) 檢查是否有正確設置

相關資料

by Rain Chu 10 月 20, 2024 | AI , Chat , 語音合成

by rainchu 8 月 27, 2024 | Agent , AI

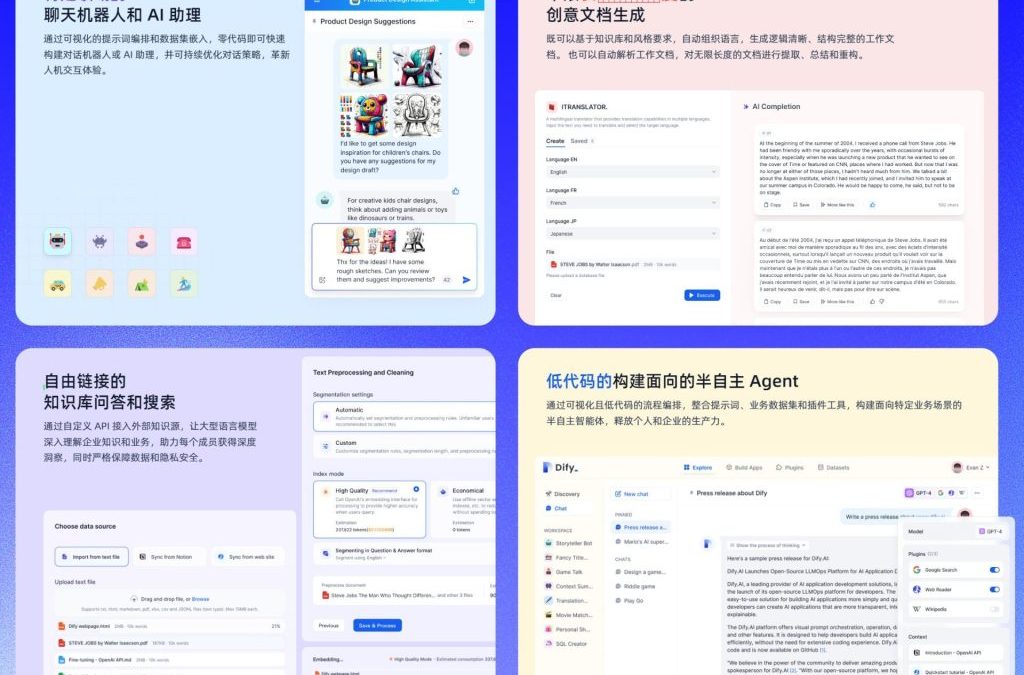

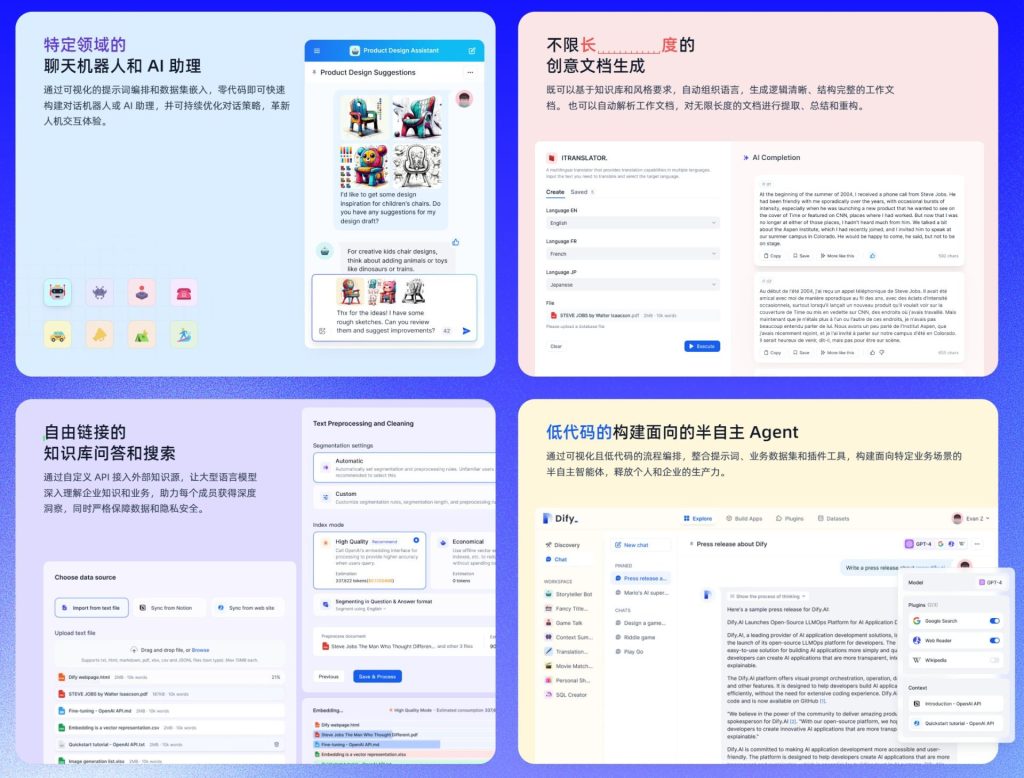

Dify AI 是一個開放靈活的生成式 AI 應用開發框架,提供了一個全方面的解決方案,讓開發者能夠輕鬆構建和運營生成式 AI的 原生應用。平台的核心技術包括 AI 工作流程編排、RAG 檢索、模型管理等功能。Dify AI 支持從 Agent 建立到工作流程編排的完整開發過程,讓使用者可以專注於創造應用的核心價值,此外,它提供的工具包括 Prompt IDE、Enterprise LLMOps 和 BaaS 等解決方案,可以大幅度的提升開發效率並優化應用性能,可以先去Dify的GitHUB 看看。

特色介紹

公司內部私有化的知識庫和AI助理 :Dify AI 允許企業將內部知識庫整合到平台中,並創建專屬的AI助理,來高效地管理和利用企業知識。

公司內部可以控管的紀錄 :企業可以通過Dify AI平台對所有操作和數據進行詳細記錄和管控,確保數據安全和合規性。

AI工作流自動化 :Dify AI 提供連結公司內部資訊系統的能力,幫助企業自動化處理各種業務流程,提升運營效率。

零代碼創建 AI Agent :平台支持用戶在無需編寫代碼的情況下,創建和部署個性化的 AI Agent,滿足各類業務需求。

支持多種大語言模型 :Dify AI 支持全球各種主流的大語言模型(LLM),為企業提供靈活的選擇,以滿足不同場景的應用需求。

開發以及運營的支持

利用 Docker 安裝

先把專案抓下來

git clone https://github.com/langgenius/dify.git 然後可以用下面的指令安裝

cd docker

cp .env.example .env

docker compose up -d 安裝完成後,利用瀏覽器看 http://localhost/install ,按照步驟設定即可

使用線上服務

https://cloud.dify.ai/apps

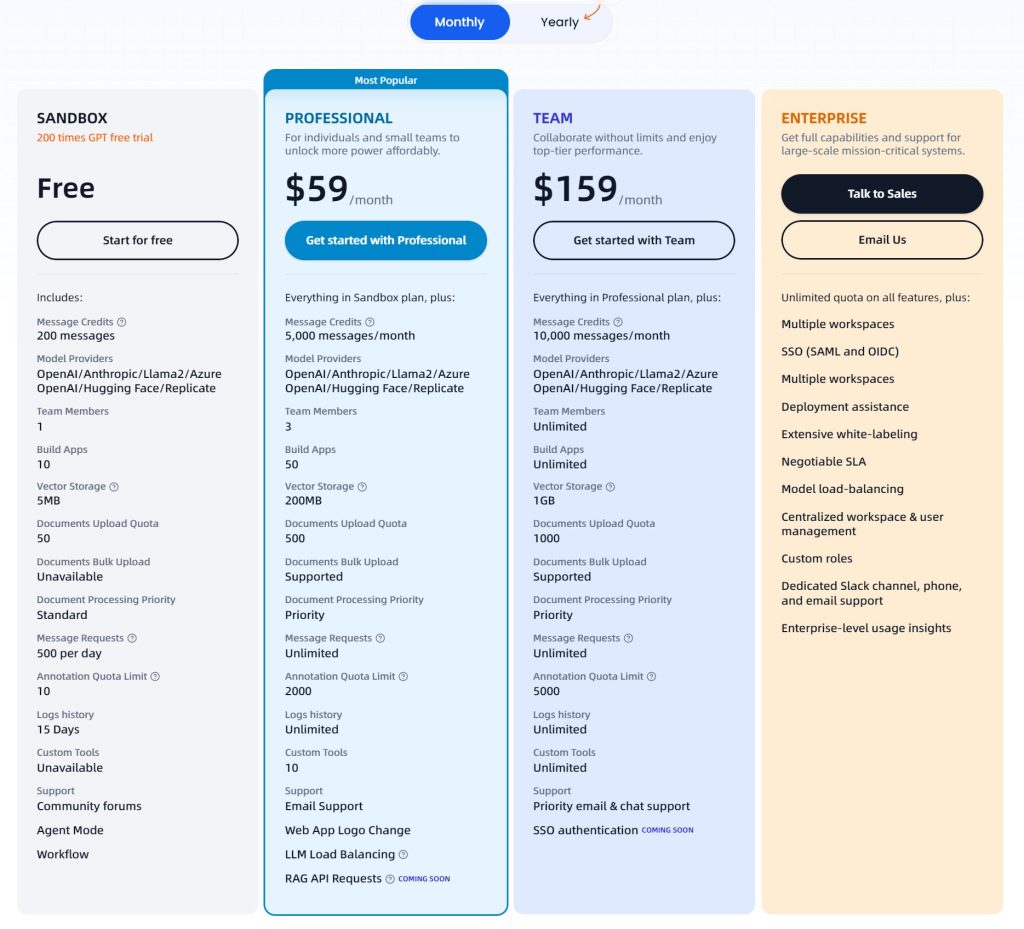

價格表

您可以在 Dify AI 官網 上了解更多詳情。

參考資料:

近期留言