DeepBrian AI – 養一個你自己的虛擬網紅

一家很有趣的南韓AI公司,秉持著南韓娛樂產業的基底,在北京、加州以及東京都設有分公司,專注再利用AI解決虛擬真人溝通的解決方案,我想有別於日本的二次元文化,南韓更專注於解決真實偶像翅膀硬了就會飛的問題,我想這會是公司的一個大痛點,常常董事會中的討論是為何我要花大錢捧一個人?我想這會是解方。

DeepBrian AI 官網

官網有三個主要的解決方案

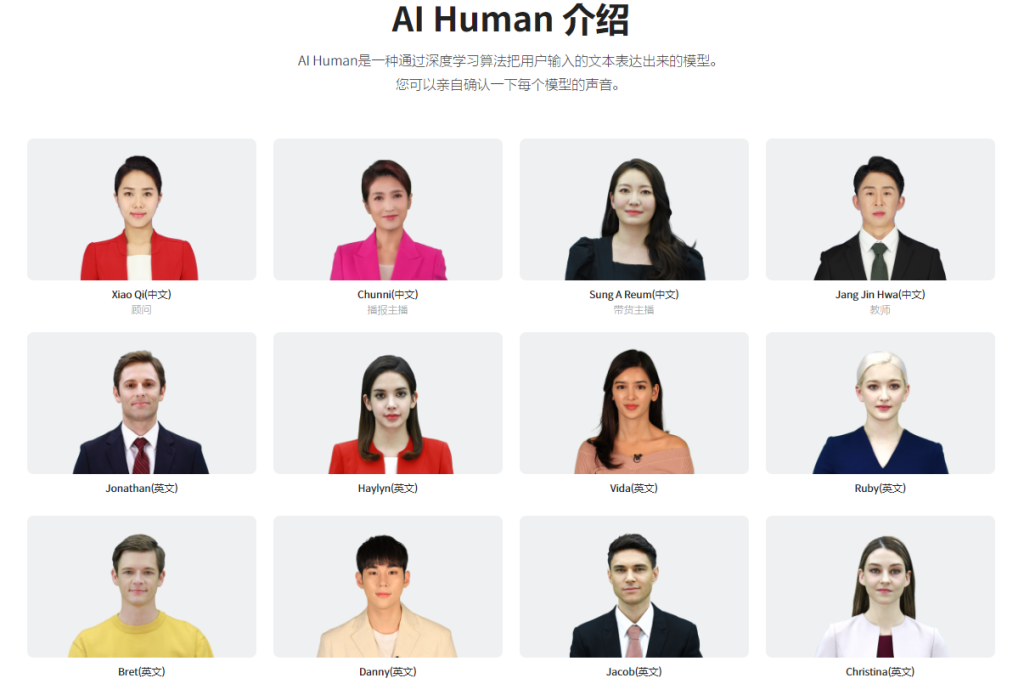

- AI Human

- AI Studios

- AI Kiosk

AI Human – 從建立自己的偶像開始

https://www.deepbrainai.io/product/ai-human

可以把多個虛擬人放於你的教育、Youtube、FB上,自由使用

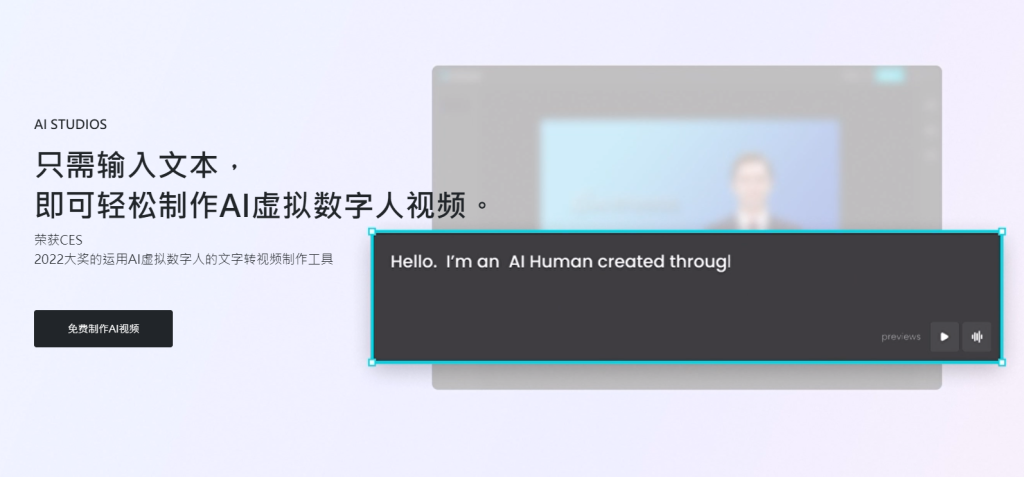

AI Studio – 輸入文字就可以讓虛擬主播替你代言

https://www.deepbrainai.io/product/ai-studios

可以試用看看,https://aistudios.com/demo,目前預設都是南韓人的臉

AI Studio 的收費方式

AI Kiosk – 把虛擬人放到自助機器中

https://www.deepbrainai.io/product/ai-kiosk

近期留言