終於補足AI簡報的缺口,Napkin AI,幫你畫流程圖

Napkin AI,直到今天都還不知道怎麼跟你收費的AI,可以幫你完成簡報的最後一哩路,把文字和項目給他,可以產生流程圖、比較圖、各式各樣的LOGO、圖示等,大幅度的美化你的簡報

Napkin 特色

1.多達40多種不同的模板

2.AI一鍵從文字生成圖表

3.漂亮且實用的手繪圖表

Napkin AI,直到今天都還不知道怎麼跟你收費的AI,可以幫你完成簡報的最後一哩路,把文字和項目給他,可以產生流程圖、比較圖、各式各樣的LOGO、圖示等,大幅度的美化你的簡報

1.多達40多種不同的模板

2.AI一鍵從文字生成圖表

3.漂亮且實用的手繪圖表

如果你也是 wordpress 愛用 WP Rocket 的使用者,並且WEB SERVER是用 NGINX 架設的,那肯定要參考這個 GitHub 項目,來作為你 Nginx 以及伺服器上面的最佳設定

先從 github 中下載下來

cd /etc/nginx git clone https://github.com/satellitewp/rocket-nginx.git

並且利用 PHP 產生預設的配置檔

cd rocket-nginx cp rocket-nginx.ini.disabled rocket-nginx.ini php rocket-parser.php

找到 nginx 的設定檔,通常在 /etc/nginx/sites-available ,並且加入設定

server {

...

# Rocket-Nginx configuration

include rocket-nginx/conf.d/default.conf;

...

}

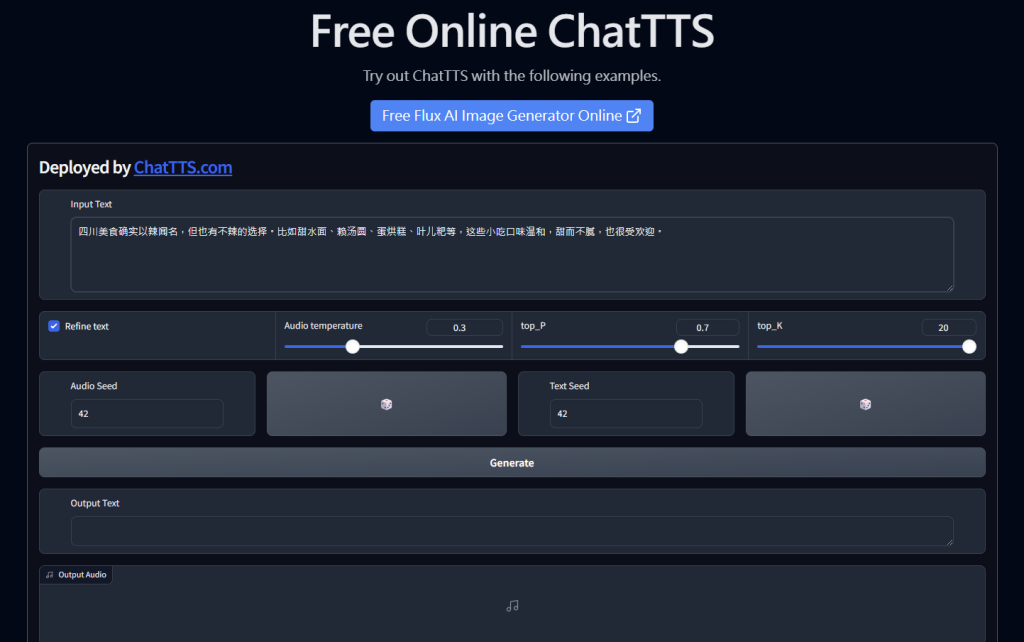

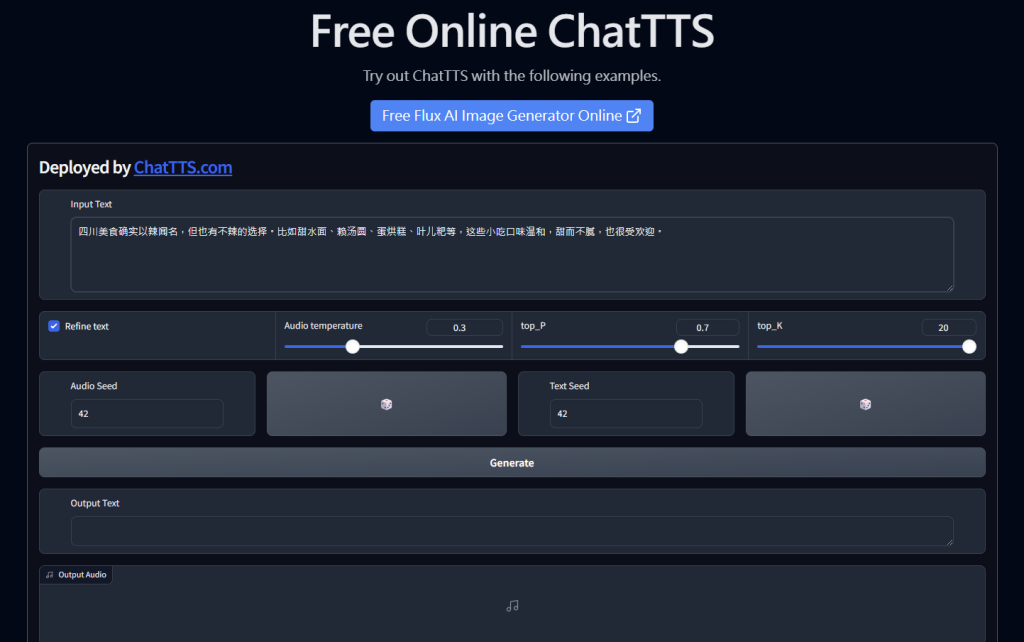

免費且超強大的 AI TTS,文字轉語音模型+工具,有許多語氣的控制,也可以很精準的寫程式控制效果,是RD眼中好用的Local端開源的TTS

1.大規模的數據:10萬小時的訓練資料,現在開源的是4小時的版本

2.專用設計:專門對於對話情境、視頻介紹的情境所設計的模型

3.開源特性:可以很簡單的整合到你的WEB中

4.支持語氣:oral, laugh, break

python 3.10

CUDA

GIT

gradio

github 複製

git clone https://github.com/2noise/ChatTTS cd ChatTTS

安裝依賴

pip install --upgrade -r requirements.txt

執行 webui

python examples/web/webui.py

利用 CLI

python examples/cmd/run.py "Your text 1." "Your text 2."

要整合在 python 程式碼中,可以安裝 PyPI

pip install ChatTTS pip install git+https://github.com/2noise/ChatTTS pip install -e .

整合程式碼

###################################

# Sample a speaker from Gaussian.

rand_spk = chat.sample_random_speaker()

print(rand_spk) # save it for later timbre recovery

params_infer_code = ChatTTS.Chat.InferCodeParams(

spk_emb = rand_spk, # add sampled speaker

temperature = .3, # using custom temperature

top_P = 0.7, # top P decode

top_K = 20, # top K decode

)

###################################

# For sentence level manual control.

# use oral_(0-9), laugh_(0-2), break_(0-7)

# to generate special token in text to synthesize.

params_refine_text = ChatTTS.Chat.RefineTextParams(

prompt='[oral_2][laugh_0][break_6]',

)

wavs = chat.infer(

texts,

params_refine_text=params_refine_text,

params_infer_code=params_infer_code,

)

###################################

# For word level manual control.

text = 'What is [uv_break]your favorite english food?[laugh][lbreak]'

wavs = chat.infer(text, skip_refine_text=True, params_refine_text=params_refine_text, params_infer_code=params_infer_code)

"""

In some versions of torchaudio, the first line works but in other versions, so does the second line.

"""

try:

torchaudio.save("word_level_output.wav", torch.from_numpy(wavs[0]).unsqueeze(0), 24000)

except:

torchaudio.save("word_level_output.wav", torch.from_numpy(wavs[0]), 24000)https://www.modelscope.cn/studios/ttwwwaa/chattts_speaker

1.是否要使用CUDA,需要的話,記得安裝依賴

2.要用CUDA,怎選擇 Linux 平台,相容性比較好

3.Python最好用3.10版本,並且用conda

Lobe Chat UI-有plugin,多模態的AI CHAT UI – 雨 (rain.tips)

AI Tools – AI工具大全(總整理) – 雨 (rain.tips)

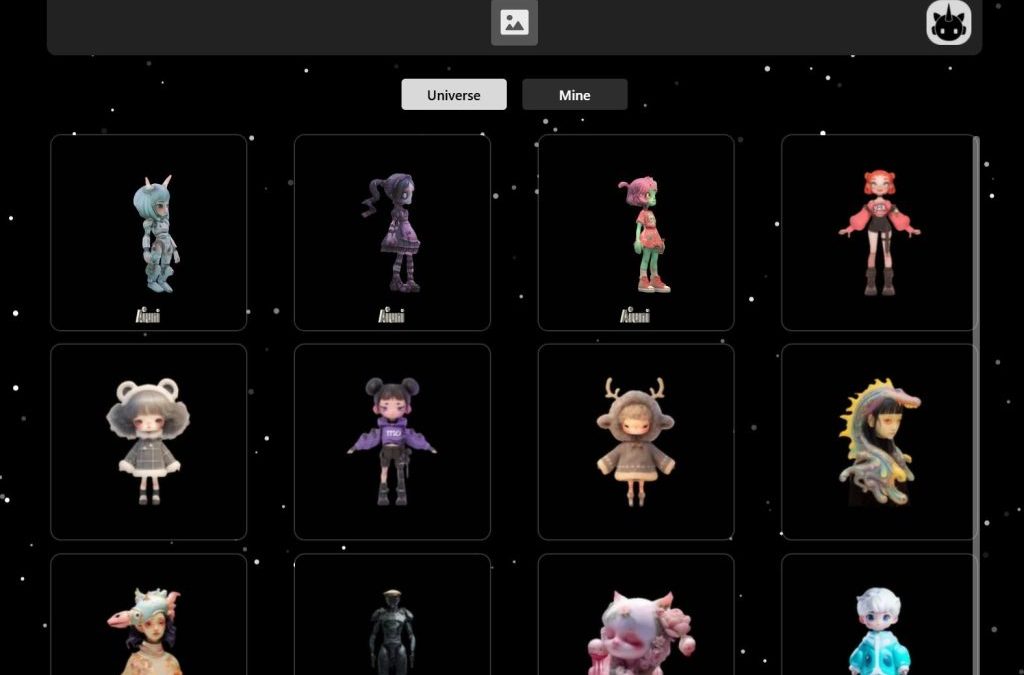

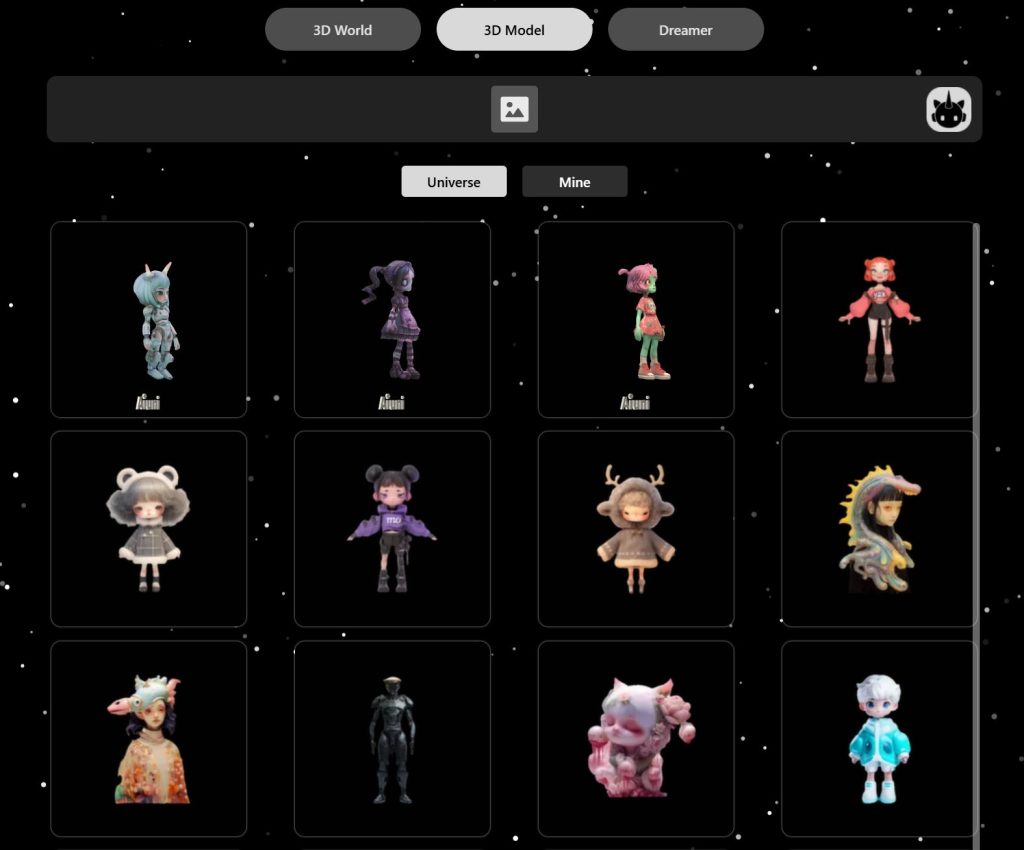

想要一鍵生成自己人頭的3D模型,已經有很多好用的工具,但這次所提供的 Unique3D 還是讓人驚艷,能夠從單一視角圖像高效地生成高品質的 3D 網格。這個框架使用了最新的生成保真度技術和強大的泛化能力。傳統的基於 Score Distillation Sampling(SDS)的方法能夠從大型 2D 擴散模型中提取 3D 知識來生成多樣化的 3D 結果,但這些方法通常需要長時間的個案優化,且結果常有不一致的問題。

最近的研究通過微調多視角擴散模型或訓練快速的前向模型來解決這一問題,生成了更好的 3D 結果。然而,這些方法在紋理和複雜幾何形狀的生成上仍存在不一致性和解析度限制。為了同時實現高保真度、一致性和效率,Unique3D 提出了一個包括多視角擴散模型和對應的標準擴散模型的框架,用於生成多視角圖像及其法線圖,並通過多級放大過程逐步提高生成的正交多視角圖像的解析度。

此外,Unique3D 還引入了一個稱為 ISOMER 的即時且一致的網格重建算法,該算法充分整合了顏色和幾何先驗知識到網格結果中,讓Unique3D 在幾何和紋理細節方面顯著優於其他圖像到 3D 的基線方法。

利用 Blender 合成3D模型 – 雨 (rain.tips)

教學影片:AI能在2分钟就建成人像浮雕3D模型,简直太快了!赶快学起来 (youtube.com)

直接上傳圖片到 Unique3D – a Hugging Face Space by Wuvin 取得對應的3D模型

可以上傳網址的官網Aiuni

論文[2405.20343] Unique3D: High-Quality and Efficient 3D Mesh Generation from a Single Image (arxiv.org)

加入Aiuni的 Discord 取的認證碼

在做產品的時候,常常會有需要將現在的3D模型融合在一個實際照片中,通常這張照片是一個實際的場景,當然現在多數人用AI的方法合成,但AI需要嘗試多次,並且不可控,真的要實現完美的場景還是需要3D繪圖軟體,如Blender的介入才行

近期留言