by Rain Chu 9 月 30, 2025 | AI , Prompt

你常常只給 AI 九個字,卻期望它做出奇蹟嗎?根據 Google 官方統計資訊,只有當提示詞達到 21 個字以上,AI 才有機會輸出高品質答案。Google 在提示工程白皮書中也強調,好的提示詞結構比簡單請求更能引導大模型解出我們要的內容。

在這篇文章,我要分享給你一個 Google 推薦的「萬用公式」提示架構:角色 + 任務 + 背景 + 格式 ,輔以動詞導向的敘述方式,讓你的 AI 提示更加有力、精準。

✅ Google 萬用提示公式:角色、任務、背景、格式

組成部分 目的 範例 角色 設定 AI 扮演的身份或專業領域 「請你扮演一位專業的旅遊部落客…」 任務 定義主要目標與行動 「…撰寫一份為期三天的行程…」 背景 加入情境、限制條件、目標對象 「…針對要去東京的小資旅行。」 格式 指定輸出的結構與型式 「…請用簡單的條列式清單呈現。」

用這樣的架構引導 AI,能讓提示詞具體、有結構,減少 AI 的猜測空間。

🛠 用詞與語法技巧 TIPS(提升提示效能的小技巧)

盡量用動詞開頭 :給 AI「做什麼」比「什麼是」更有力。例如用「撰寫」「列出」「翻譯」「審校」等動詞開頭。避免模糊語詞 :少用「很棒」「不錯」這類曖昧形容詞,改用具體指標(如「300 字」「三段落」「條列式」)。提供範例或模板 :在提示中給一個輸出範例讓 AI 參考,降低偏差。讓 AI 回問你需要什麼 :可以讓 AI 主動反問「你要什麼風格/語氣/受眾?」來細化需求。

🧩 實例演練:讓 AI 幫妳寫提示詞

下面示範一個互動流程:

你對 AI 說:

AI 回覆後你可以加一句:

「請問你要什麼風格?正式、活潑、針對女性或男性?」

AI 反問後,你回答語氣與受眾,它就能生成更貼合你需求的文案。

這樣的對話式提示設計也比一次寫好全部提示更靈活有彈性。

💡 為什麼 21 字以上比 9 字好?

模型理解上下文有門檻:過短提示缺乏足夠上下文,AI 容易「自由發揮」,未必對應你真正需求。

更精準引導模型工作:加入角色、任務、背景與格式,能讓 AI 經過「角色思考」後才動手回答。

提示後段不易被截斷:雖然 AI 提示有長度限制,在合理長度內放些條件比過短更能保留關鍵訊息。

小結與建議

使用 角色 + 任務 + 背景 + 格式 為提示骨架

用動詞為主語,引導 AI 行動

鼓勵 AI 反問細節,加強精準度

避免過於簡短的提示詞,適度增加字數與條件

只要掌握這套公式與技巧,你的 AI 提示力可能真的能提升 80% 或以上。試著用它設計你的下個提示詞吧!

https://gemini.google.com

by Rain Chu 9 月 21, 2025 | AI , Prompt , 程式開發 , 繪圖

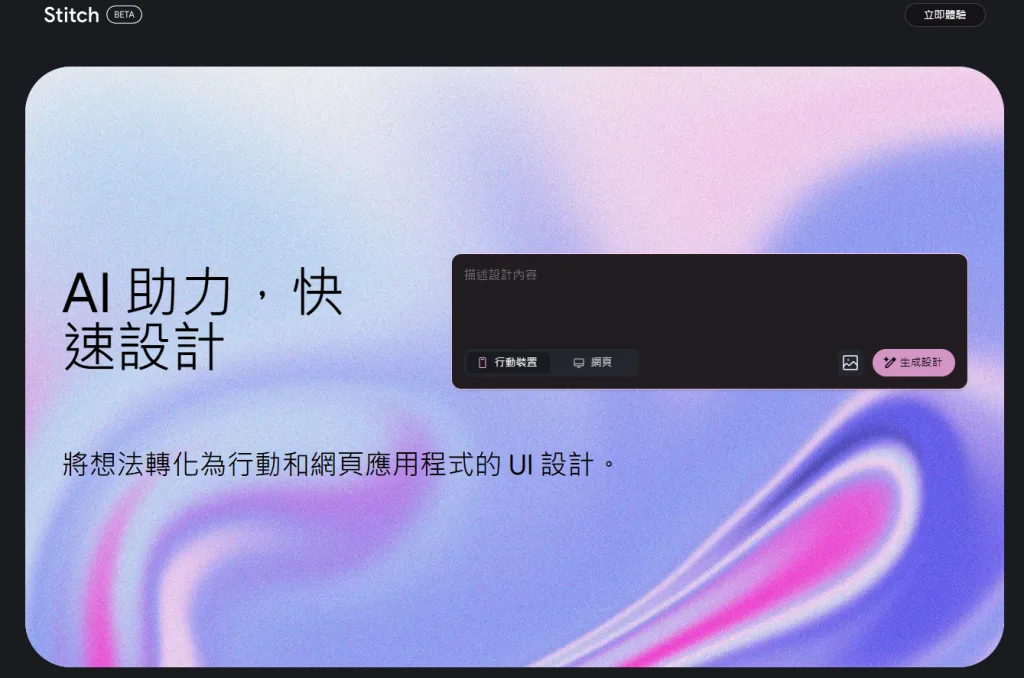

Google I/O 2025 上,Google 推出了名為 Stitch 的全新 AI 工具,目標是用文字或圖片提示(prompt / image prompt)快速生成網頁與 App 的 UI 設計與前端程式碼。Stitch 結合 Gemini 2.5 Pro 與 Flash 模型,並支持 Figma 匯出與 IDE 編輯,雖不是要取代專業設計工具如 Figma,但它能大幅簡化設計初期流程,是設計師與前端開發者的新利器。以下詳細介紹功能、優勢與使用心得。

功能特色與技術細節

從文字或圖片提示產生 UI + 前端程式碼

用戶可以用簡單的中英文描述(這真的是google模型的好處),例如「建立一個深色主題的行動 app 登入頁面,有按鈕和表單欄位」來生成設計。

或者上傳草圖、線框圖(wireframe)或其他 UI 的範例圖片來作為參考。Stitch 會根據這些提示產生對應設計。

整合 Gemini 2.5 Pro/Flash 模型 + 主題與設計流程工具

Stitch 是由 Google Labs 實驗性專案(experimental tool)之一,背後運行的是 Gemini 2.5 Pro 模型,這使得生成的 UI 設計在色彩、佈局與細節上更乾淨與現代感。

提供主題(theme)選擇、樣式(style)調整等交互功能;可視化設計流程內建 Canvas,可以看到完整頁面流程與介面切換模式。

輸出與匯出支持:HTML/CSS/Figma 等

Stitch 可以匯出為 HTML / CSS 程式碼,讓開發者能夠「拿來就用」於前端專案當中。

同時有「Paste to Figma」或「Copy to Figma」功能,可將設計匯入 Figma 進行進一步編輯。

Stitch 的定位與比較優勢

輔助工具,而非全面取代設計平台 :Stitch 的設計是為了縮短「從構思到原型 UI +程式碼」之間的落差,而不是完全取代專業設計師在 Figma、Sketch、Adobe XD 等工具中的工作。設計師仍可用這些工具做精細調整。速度與效率 :使用 Stitch 生成 UI 設計/前端程式碼所需時間比從零開始設計加寫碼快很多,對於初期原型與快速驗證需求特別有用。可訪問性 :Stitch 在 Google Labs 平台上可用,用戶界面相對友好,降低新手與非設計背景者的進入門檻。

限制與要注意的地方

雖然 Stitch 支持匯出至 Figma,但某些情況(如從上傳圖片/草圖的模式)之下,Figma 匯出功能尚未全功能完善。

設計細節(例如文字對齊、某些複雜元件組件化)有時候不完美,需要人工修正。

現階段仍為實驗性/預覽模式(experimental / Labs),可能在某些瀏覽器支援或功能穩定性上有差異。

使用流程簡易指南

前往 Stitch 官方網站 (stitch.withgoogle.com)並登入 Google 帳號。

選擇撰寫 prompt 或上傳參考圖片/草圖/線框圖。描述顏色、風格、佈局等細節。

等待 Stitch 生成 UI 設計與初步程式碼(HTML/CSS)。

若要匯出至 Figma,可使用「Copy to Figma / Paste to Figma」功能以便進一步編輯。

若為開發者,可直接取出 HTML/CSS 並嵌入 IDE 或網頁專案中。

Google Stitch 的收費/使用限額情況

從目前公開資訊來看,Google Stitch 屬於 Google Labs 的實驗性工具(beta 或公測階段),目前是免費使用 ,但有一些使用次數與模式上的限額/差異。下面是具體情況:

模式 免費與否 每月生成次數限額 Standard Mode(Flash 模式) 免費 每帳號每月約 350 次生成 │ 適合一般快速原型與草圖生成,可匯出 Figma 或 Code。 Experimental Mode(實驗/Pro 模式) 免費 每帳號每月約 50 次生成 │ 使用更強的 Gemini 2.5 Pro 模型;目前部分功能(如匯出 Figma)或效能有些限制。

參考資料

VIDEO

by Rain Chu 9 月 21, 2025 | 投資

什麼是 Ants 指標?

Ants 指標(MVP,Momentum, Volume, and Price)由大衛·瑞安(David Ryan)所研發,他是三屆美國投資錦標賽冠軍。當時他在 William O’Neil 公司管理 New USA Growth Fund 的經驗中,注意到一些股票在從其最近的基礎價(base)上漲後能持續上升,而其他則僅短暫上漲。因而構思這個指標以識別哪些股票具備更強勢的動能與機構買盤背景。

MVP 的三大核心條件

Ants 指標在最近 15 個交易日內觀察以下三個條件,若都滿足,則該股票被標記為具有 Ants 信號:

Momentum(動能) Volume(成交量) Price(價格上漲幅度)

當這三者都滿足時,就意味著該股票可能有機構持續買入(institutional accumulation),有潛力繼續上漲。

顏色與視覺標示

在 TradingView 或其他圖表工具上,通常會把滿足不同條件的股票用不同顏色標示:

灰色(Gray Ants) :僅 Momentum 條件滿足藍色/藍綠色 :Momentum + Price 條件滿足黃色 :Momentum + Volume 條件滿足綠色 :三個條件都滿足,即完全 MVP 信號。

使用方式與應用建議

把 Ants 指標加到你的圖表(TradingView 常見有這個腳本)以便觀察是否出現 Ants 信號。

可把 Ants 信號與其他技術指標(如相對強弱指標、基礎面篩選、支撐阻力等)搭配使用,以降低假訊號風險。

監控這些出現 Ants 信號的股票,等待回調或整理基礎形態再進場,能較好控制風險。

優勢與限制

優勢 :

能幫助投資者早期發現機構在悄悄佈局的股票

指標簡單明確,Momentum + Volume + Price 這三條件容易理解與觀察

適合中期交易與趨勢跟蹤

限制 :

工具不是預言者:滿足條件不保證一定大漲

有可能出現重疊 Ants 信號(例如兩段 15 天序列重疊),需判斷哪一段更可靠。

在極端行情或波動性很大時(例如暴跌反彈後),Volume 與動能條件可能容易滿足但後續跟不上上漲動力

附上 XQ 用的程式碼

input:day(15);

input:m1(12);

input:v1(1.2); // 量能要上漲超過20%

input:p1(1.2); // 價格要大於20%

setinputname(1,"計算天期");

setinputname(2,"連續上漲天數");

variable:x(0),count(0);

// 過去 N 天,要有 8 成的天數是上漲的

count=0;

for x=0 to day-1

begin

if close[x]>open[x]

then count=count+1;

end;

condition1 = count >= (m1-1);

// 量能要上漲超過20%

condition2 = volume > (average(volume,day) * v1);

// 量能要上漲超過20%

condition3 = close > (average(close,day) * p1);

ret=condition1 and condition2 and condition3;

參考資訊

https://tw.tradingview.com/script/uEaFv7tm-Ants-Momentum-Volume-and-Price-MVP

by Rain Chu 9 月 21, 2025 | AI , Chat , Game

「哄哄模擬器」是一款基於 AI 的情景模擬工具,讓你在不同對話場景裡練習溝通與情商,用語言技巧「哄」對方原諒你。無論是女友生氣、應酬場合、家庭矛盾,或朋友之間的摩擦,用「模擬對話」的方式體驗各種情境,提升對話能力與情感同理。本文會帶你了解功能、怎麼遊玩、優缺點與心得。

試著哄哄

選好一個主題,就可以開始試著挑戰如何烘好女友,並且獲取高分

https://hong.greatdk.com

開啟網站或下載 App

Web 版本:例如 hong.greatdk.com 可進入「哄哄模擬器 Web 版」。

選擇角色與情境

開始對話

分數或原諒值機制

若你的回覆合乎情境、誠懇、有同理心,就會提升「原諒值」。

若不佳或冷漠,原諒值可能下降。達標即成功哄好對方。若掉到某個底線可能「失敗」。

練習與重來

功能特色

以下是哄哄模擬器的幾個主要特色,讓你知道這款工具能做什麼:

情境模擬對話 有限次數制挑戰 無需註冊或簡易入口 開源/免費版 HongHongAI 情感與語氣模擬

優點與限制(實測與考慮)

優點

提升情商與溝通技巧 :在安全環境中練習如何哄人,比真實中犯錯成本低。場景豐富有趣 :多場景設計讓使用者可以多樣練習,不會單調。門檻低 :很多版本不用註冊或提供簡單資訊即可開始。適合想「試試看」的人。

參考資訊

https://top.aibase.com/tool/honghongmoniqi

https://weibo.com/1727858283/ND9pOzB0K?refer_flag=1001030103_

https://hong.greatdk.com

https://github.com/johanazhu/honghongai

by Rain Chu 9 月 14, 2025 | AI , Robot , 數據分析 , 模型

建立自己的 HopeJR 機器人!

你有想要一隻能做精密手部操作的人形機器人?

HopeJR 正是這樣一款開源專案:具備人手與機械手臂,搭配外骨骼(exoskeleton)與手套控制,能實現靈巧、精確的手部動作,非常適合高階操作任務。

以下帶大家從硬體到軟體,完整建立 HopeJR 的流程教學與心得。

HopeJR 是什麼?

HopeJR 是舉債於 LeRobot 專案下的一款開放源碼人型機械手臂與手的系統。使用者可以以手套與外骨骼裝置控制 HopeJR 的手與手臂動作。

它包含幾個模組化的部分:機械手、機械臂、手套(glove)、外骨骼(exoskeleton)控制器。硬體、軟體皆為開源。

建置 HopeJR 教學

以下是步驟示範,讓你從零開始組裝與操作 HopeJR。

一、環境與先決條件

有外骨骼與手套控制器(homunculus_glove/homunculus_arm 等)

有機械手與機械手臂硬體模組

一台能連接這些裝置的電腦,USB 接口、驅動支援

安裝 Python 3.10+,PyTorch 等軟體環境,以及 LeRobot 套件

二、安裝 LeRobot 套件

git clone https://github.com/huggingface/lerobot.git

cd lerobot

pip install -e ".[hopejr]" 三、設備端與通訊埠設定(Device Configuration)

使用 lerobot-find-port 指令來找出每個 HopeJR 組件(手臂、手、手套、外骨骼控制器)的 USB 埠。

記錄每個模組對應的 port,例如 /dev/tty.usbmodemXXXX 或 Windows 上的類似 COM 埠,用於後續校正和遙控。

四、校正(Calibration)

為了讓控制更加精確,你必須為每個組件做校正:

手(Hand)校正 :把手指關節全部移動至可動範圍,設定最小/最大角度。手套(Glove)校正 :同樣地,移動手套中每根手指的所有關節,記錄該裝置讀值的最小與最大。手臂(Arm)校正 :肩膀、手肘、手腕的 pitch/yaw/roll 等關節都要校正動作範圍。外骨骼(Exoskeleton)校正 :這部分讓人手動作透過外骨骼映射到 HopeJR 的機械手臂,在校正時要移動所有關節達到最大與最小。

校正結果會保存在本地,例如 ~/.cache/huggingface/lerobot/calibration/... 的路徑內。

五、遠端操作(Teleoperation)

校正完成後,就能使用遙控命令讓你手與手臂控制 HopeJR 機械手部分動作:

lerobot-teleoperate \

--robot.type=hope_jr_hand \

--robot.port=<手的 USB 埠> \

--robot.id=blue \

--robot.side=right \

--teleop.type=homunculus_glove \

--teleop.port=<手套 USB 埠> \

--teleop.id=red \

--teleop.side=right \

--display_data=true \

--fps=30 對手臂同樣使用遠端操作命令,只是 robot.type 填 hope_jr_arm,teleop.type 用 homunculus_arm。

六、錄製、重放與訓練(Record/Replay/Train)

Record :錄製你用手套/外骨骼控制手部或手臂的操作數據,配合影像或鏡頭視訊。這些資料可以用來訓練模型。Replay :重放之前錄製的數據,測試操作是否準確。Train :若你想讓你的 HopeJR 有自主行為或能在某些動作上優化,可以用 LeRobot 的訓練指令,搭配錄製的資料或模擬環境進行強化學習或 imitation learning。

HopeJR 的優勢與適用場景

優勢項目 說明 精準控制 外骨骼 + 手套 + 校正過程能實現手指、手腕、肩肘等關節的細緻動作。 模組開源 HopeJR 所有硬體與軟體部分為開源,可以自行組裝或改裝。 適合高階任務 適用於需要精細手部操作的任務,例如物件操作、握持/擺動、復健機器人等。 社群與生態支持 LeRobot 有模型、範例、文檔與活躍社群可協助新手入門。

延伸閱讀

官網:

https://github.com/huggingface/lerobot

說明:

https://huggingface.co/docs/lerobot/hope_jr

硬體教學:

https://huggingface.co/docs/lerobot/so101

近期留言