by rainchu 12 月 15, 2025 | AI , 圖型處理 , 模型 , 繪圖

Nano Banana Pro 剛出,就馬上成為「圖像生成與視覺應用」領域的新標準,它不只是畫圖工具,而是一個高度可控、支援中文、能維持一致性的 AI 視覺引擎 。

以下整理 Google Nano Banana Pro 的 15 種超強應用場景 ,無論你是設計師、行銷企劃、教育工作者或產品經理,都能立即上手。

1️⃣ 簡報/企劃海報快速生成

只要輸入企劃主題與風格,Nano Banana 就能產出投影片主視覺、封面海報、提案插圖 ,大幅減少找素材與修圖時間。

2️⃣ 草圖秒變產品實景圖

手繪線稿、低擬真草圖,可直接轉為擬真產品照 ,特別適合工業設計、UI / UX、新創產品驗證。

3️⃣ 設計材質紋理

可精準生成木頭、金屬、皮革、布料、玻璃等高解析材質貼圖 ,支援不同光源與粗糙度設定。

4️⃣ 角色一致性

透過角色描述與參考設定,即使多次生成,也能維持臉型、服裝、風格高度一致 ,非常適合漫畫、品牌代言角色。

5️⃣ 品牌指南手冊

一次生成品牌色彩、字體風格、視覺範例 ,快速完成 Brand Book 視覺示意。

6️⃣ 生成各種尺寸

同一視覺可自動輸出 社群貼文、橫幅廣告、直式限動、網站 Banner 等多尺寸版本。

7️⃣ 食譜圖超清晰

針對食物細節表現極佳,油光、層次、質地自然,特別適合餐飲菜單、食譜部落格、外送平台 。

8️⃣ 多國語言菜單 Menu

結合 Gemini 的語言能力,可直接生成多國語言版本菜單圖片 ,且排版自然、不違和。

9️⃣ 景點/教材圖卡

可用於旅遊介紹、歷史教材、地理圖卡、兒童學習素材 ,風格可愛或寫實皆可。

🔟 風格轉換更精細

支援攝影風、插畫風、3D 風、日系、美式、復古等,且保留原圖構圖與細節 。

1️⃣1️⃣ 教學假桌面生成

快速生成「假作業系統畫面」、「教學用後台介面」,適合製作教學簡報與線上課程 。

1️⃣2️⃣ 腳本 → 連續劇照

輸入分鏡或劇本段落,即可生成連續一致的劇照畫面 ,對影視提案與動畫前期極有幫助。

1️⃣3️⃣ 中文超強

對繁體中文理解精準,無論是菜單、教材、標語、情境文字,都能自然呈現,不再需要英文轉譯 。

1️⃣4️⃣ 畫 3D 圖也可以

可生成擬 3D、等角視圖、產品爆炸圖概念,適合簡報與技術說明使用。

1️⃣5️⃣ 任意切換焦距

同一場景可切換廣角、標準、特寫、微距 ,視覺敘事能力大幅提升。

參考與官方資源

by rainchu 11 月 23, 2025 | AI , 繪圖

什麼是 AIX Studio?

AIX Studio 提供了一系列 AI 繪圖與視覺特效功能,讓使用者從文字提示、圖片輸入,甚至批量處理模式,快速生成具質感、具光影效果的視覺作品,並結合類似服務模式,它不僅針對創作者介面,也支援 API 整合,適合企業/開發者接入。

此外,從應用場景來看:

支援「電商場景圖片」:例如產品在光影下的立體感、背景反射、陰影鮮明。

室內設計視覺:場景光源處理、物件材質質感、自然光或人造光的投射。

人像後期與自媒體內容:人臉光影、高光處理、背景模糊與光線設計。

API 整合:可將生成流程嵌入自家 APP、網站或後台服務,自動產出多版本視覺素材。

多種光影特效與後期應用

這裡列出 AIX Studio 在光影與後期特效方面值得關注的功能:

光源模擬 :例如自然光、側光、背光、點光源等,讓畫面具備立體感與深度。陰影與反射處理 :物體在場景中的陰影投射、反光面板、水面反射或鏡面效果。材質質感增強 :金屬、玻璃、布料、木材等不同材質在光影下的變化。後期風格化特效 :如「電影膠片風格」、「電商清晰專業風」、「室內柔光」等。批量生成與版本控制 :可設定不同光影/風格參數,一鍵生成多版本,方便 A/B 測試或素材庫建立。API 調用 :對於開發者而言,可透過 API 傳送文字提示、圖片資料、光影參數,回收到生成圖像,便於整合至 APP/網站。

為什麼選擇 AIX Studio?

多場景適用 :從電商商品照、室內設計視覺、到人像後期、自媒體封面,一應俱全。光影特效為核心亮點 :不少 AI 繪圖工具偏重「風格化」或「插畫感」,但 AIX Studio 將光影處理、材質質感視為重點。開發者友善 API :如果你已有 APP 或網站需要圖片生產流程自動化或大量生成,API 支援是重要優勢。節省製作成本與時間 :過去可能需要專業攝影或後製師處理光線與材質,現在藉助 AI,可快速生成可用素材。

快速上手指南:三步驟生成質感圖像

步驟 1:明確構思場景與用途 步驟 2:在 AIX Studio 輸入提示/上傳圖片+調整光影參數

可選文字提示:如「luxury product on glass table, strong side light, velvet fabric backdrop, high contrast shadow」。

若已有素材,可上傳圖片並選擇「材質+光源模擬」參數。

點選生成後,系統處理後回傳圖像。

步驟 3:後製/整合與輸出

注意事項與實用 Tips

提示越具體,光影效果越精準 :描述中加入「光源類型、陰影強度、反射面材質、色溫」等詞彙。材質設定影響大 :例如「玻璃反射」與「布料柔光」處理方式不同,提示中應明確指出。確認 API 授權與用途 :若將生成圖像用於商用或整合至 APP 中,需確認 API 條款與版權可否。儲存提示與參數記錄 :若你生成多版本圖像,建議記錄提示詞、模型版本、光影參數,以便後續重現或修改。後製仍能提升質感 :雖然 AI 生成已具備光影特效,但你仍可手動微調色彩、加文字、疊圖效果以符合品牌風格。

參考資料

https://draw.aix.studio

by rainchu 11 月 23, 2025 | AI , 繪圖

什麼是 Pollo AI?

Pollo AI 是一款「一站式 AI 圖片+影片生成平台」,它整合了領先業界的文字-影像、影像-影片模型,甚至支援圖片轉影片、影片編輯、動畫生成等功能。根據官方介紹,它允許你從文字或圖像輸入,透過多款模型,產出高品質的視覺作品。

特色亮點:十個 AI 工具全合體

以下為 Pollo AI 的主要特色與亮點,讓你了解它為什麼值得一看:

整合多款頂尖模型 :平台支援多款影像與影片生成模型,如 Sora 2、Veo 3.1、Kling、Runway 等。 圖片到影片 :上傳靜態圖片、輸入提示文字,即可轉換為動態影片,並配備音效與背景音樂。 文字到影像/影片 :從文字提示產出圖片、或轉為影片,涵蓋從構思到視覺成品的流程。 特效與轉場豐富 :支援圖片‐影片風格化、動畫角色轉換、社群短影片格式等。 適用不同創作者 :無論你是社群內容創作者、品牌營銷人員、插畫師還是動畫愛好者,都能找到適合的功能。 省時高效 :相比傳統拍攝、後製流程,透過 AI 可大幅提升產出效率,縮短內容製作時間。

實測:影片生成流程解析

下面是一個簡化的實測流程,讓你看到 Pollo AI 從構思到生成影片的操作步驟:

構思影片主題 選擇模型與輸入提示 上傳素材或僅用文字 生成並下載 後製優化(視需求)

適用場景/創作建議

社群貼文影片 :想製作 Instagram 或 TikTok 用的短影音,可以用「圖片轉影片」模式快速生成。品牌影片/產品宣傳 :品牌想快速製作 Banner、預告片,使用文字+影片模型即可實踐。個人創作/插畫動畫 :插畫師可從靜態畫轉為動畫片段,或者從文字提示做視覺故事化。內容行銷/教育影片 :搭配影片編輯、文字提示功能,可快速製作教學、說明影片或簡報動畫。

注意事項與 Tips

提示越具體,效果越佳 :指明鏡頭類型、光線、構圖、角度、風格等可提高成品質量。選擇模型合適任務 :不同模型風格不同,比如 Veo 3.1 深於場景轉換、長片敘事;其他模型或更適合動態風格。檢查授權/商用條款 :若使用於商業用途,確認平台是否支援商用及是否需付費升級。儲存素材與提示文字 :建議紀錄使用哪個模型、提示內容,以便未來重複或修改。後製仍有價值 :雖然 AI 工具功能強大,但如需品牌風格統一、字幕、配音仍可由後製進一步加工。

參考資料

https://pollo.ai

by rainchu 11 月 23, 2025 | AI , 圖型處理 , 繪圖

所謂 AI 圖像生成,是指利用人工智慧模型(如「文本轉圖片」或「圖片轉圖片」)從文字提示、或現有影像作為輸入,產出全新視覺作品。這類工具背後常用「擴散模型」(diffusion models)或其他生成式架構。

快速上手指南:三步驟產出視覺作品

步驟 1:明確構思內容 步驟 2:輸入提示(Prompt)並生成 步驟 3:後製與整合

模型推薦:哪個最穩定、最強?

經檢視多項資料後,我們推薦使用 Analog Madness 模型。這裡說明為什麼選它:

Analog Madness 是一款靠近真實攝影質感的影像生成模型,据社群評論和模型頁面資料指出,其在「真實風格」、「類比攝影風格」方面表現優異。

它常被描述為「非常多用途(versatile)」、「提示越強效果越好」的模型。

在專門探討 AI 模型的討論中,有使用者提問:「Is Analog Madness the best 1.5 photorealistic model?」可見其在社群中名字較為常見。

使用建議 :

若你想要達成「真實感+類比攝影風格」的圖片,可選擇 Analog Madness 並搭配精細提示。

提示範例可加入「ultra realistic close up portrait, film grain, analog style, 4K」等描述。

注意:即便是最強模型,也仍需你提供具體而精準的提示詞;模型本身不是完全自動完美,仍須人為設計輔助。

LoRA 濾鏡玩法:讓 AI 直接「化妝」你的圖

除了選擇強模型之外,另一個提升圖片風格自由度與創意控制的關鍵是 LoRA(Low-Rank Adaptation)濾鏡 。以下為其玩法介紹:

什麼是 LoRA? 怎麼使用?

選擇一個支持 LoRA 的 UI 或工具(如 Stable Diffusion 前端)。

將你想加入的 LoRA 模組載入(如「beauty-makeup LoRA」、「film-grain LoRA」等)。

在提示(prompt)中明確加入你想的濾鏡風格,例如: prompt: 「A glamorous portrait of a woman, heavy makeup, glossy lips, dramatic eyeshadow, analog film style, beauty light」

效果與建議 :

利用 LoRA,你能讓 AI 圖像加上「化妝效果」、「風格化妝感」、「光影膠片質感」等,使圖片更具商業或時尚感。

建議提示中加入「makeup, dramatic eyeshadow, high-gloss skin, studio lighting」等描述詞,再搭配 LoRA,效果更佳。

若你生成系列圖片(例如插畫系列或社群貼文系列),可固定同一個 LoRA 濾鏡,以維持風格一致性。

注意事項 :

某些 LoRA 模組可能只用於私人、非商業用途,使用前請確認授權。

濾鏡效果強度過高可能導致圖片不自然,建議生成後進一步微調。

快速上手指南:三步驟產出視覺作品

步驟 1:明確構思內容 步驟 2:選模型+載入 LoRA +輸入提示 步驟 3:後製與整合

注意事項與實用 Tips

提示越具體,效果越好 :描述中加入「情緒、光線、構圖、色調」等詞彙。檢查版權與用途限制 :若將圖片用於商業用途,請確認工具條款。視覺風格一致性 :若產出系列圖像,建議統一提示中指定風格,以維持一致性。避免過度依賴 AI :AI 是輔助工具,創作者仍可加入人性化元素、構思與個人風格。輸出檔案備份 :建議保存原始生成圖片與提示文字,以便未來回溯或修改。

參考資料

https://aigallery.app

by rainchu 11 月 23, 2025 | Chat , 繪圖

ChatArt 是一款整合 AI 聊天、寫作、繪圖的工具平台。它支援用戶用對話方式輸入想法、選擇創作場景,平台便會協助產出文章、小說,甚至圖片。根據官網介紹,它提供小說產生器、圖生圖、文生圖功能,並且多平台支援(網頁/手機/平板)

為什麼用 AI 來寫小說、畫圖?

激發創意、打破瓶頸 節省時間、提高效率 視覺與文字一體化 免費/低成本起步

如何用 ChatArt 來寫小說+畫圖 — 步驟指南

以下為建議流程,協助您快速上手:

1. 明確構思主題

2. 開啟小說產生器

3. 產出畫圖

4. 潤飾與整合

5. 發佈與迭代

創意應用案例

短篇小說+插圖集 :用 ChatArt 快速創作一篇短篇(如 1000 字內)+ 3~5 張配圖,製作成自己的電子書。社群圖文貼文 :每日/每週用 AI 畫圖+配一段創意文字,在 Instagram 、 X 或 Facebook 刊出,快速累積風格與粉絲。故事連載+視覺系列 :將創作拆成「章節」+「每章畫圖」,展開系列連載,讓讀者期盼下一篇。寫作訓練工具 :若您是作家或插畫師,可用 AI 生成靈感,再由您精修,作為養成創意能力的練習。

注意事項/實用 Tips

雖然名稱說「免費」,但部分高階功能可能需付費或限制次數,建議先以「免費試用」為起點。

文字提示越具體,畫圖效果越精準。建議描述「色調、光影、角度、背景元素」等。

雖為 AI 產出,仍需您加入「人性化」元素:角色內心、轉折、情感描寫,畫圖也可修圖再發佈。

若將創作商業化,請確認平台的使用條款/商業授權情況。

創作完成後,建議備份作品(文字+圖片),確保資料安全。

參考資訊

https://www.chatartpro.com

by Rain Chu 9 月 21, 2025 | AI , Prompt , 程式開發 , 繪圖

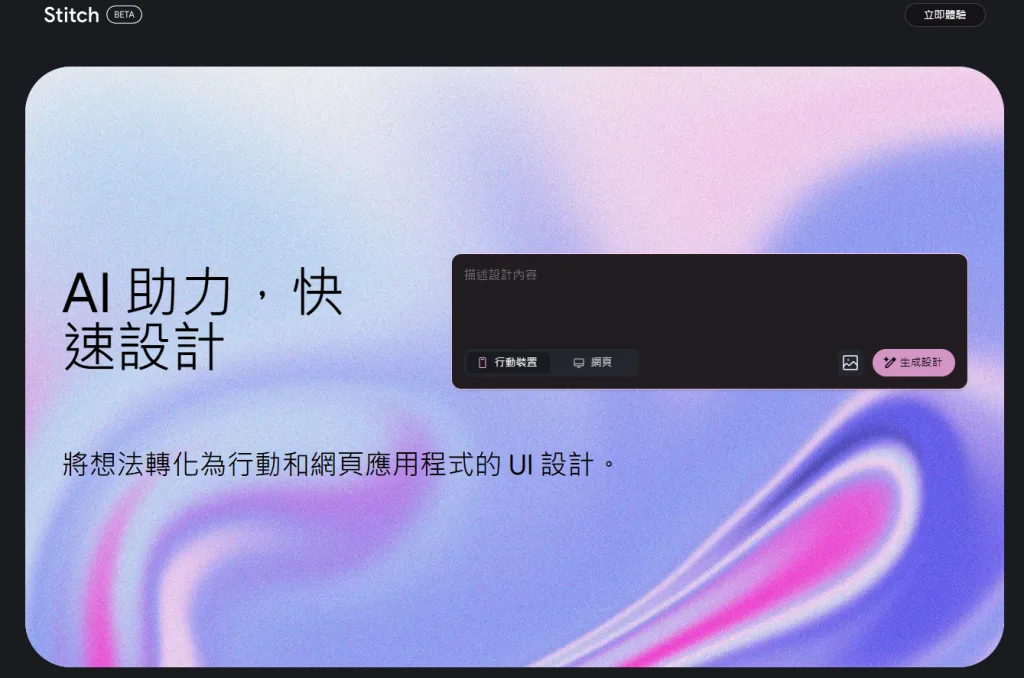

Google I/O 2025 上,Google 推出了名為 Stitch 的全新 AI 工具,目標是用文字或圖片提示(prompt / image prompt)快速生成網頁與 App 的 UI 設計與前端程式碼。Stitch 結合 Gemini 2.5 Pro 與 Flash 模型,並支持 Figma 匯出與 IDE 編輯,雖不是要取代專業設計工具如 Figma,但它能大幅簡化設計初期流程,是設計師與前端開發者的新利器。以下詳細介紹功能、優勢與使用心得。

功能特色與技術細節

從文字或圖片提示產生 UI + 前端程式碼

用戶可以用簡單的中英文描述(這真的是google模型的好處),例如「建立一個深色主題的行動 app 登入頁面,有按鈕和表單欄位」來生成設計。

或者上傳草圖、線框圖(wireframe)或其他 UI 的範例圖片來作為參考。Stitch 會根據這些提示產生對應設計。

整合 Gemini 2.5 Pro/Flash 模型 + 主題與設計流程工具

Stitch 是由 Google Labs 實驗性專案(experimental tool)之一,背後運行的是 Gemini 2.5 Pro 模型,這使得生成的 UI 設計在色彩、佈局與細節上更乾淨與現代感。

提供主題(theme)選擇、樣式(style)調整等交互功能;可視化設計流程內建 Canvas,可以看到完整頁面流程與介面切換模式。

輸出與匯出支持:HTML/CSS/Figma 等

Stitch 可以匯出為 HTML / CSS 程式碼,讓開發者能夠「拿來就用」於前端專案當中。

同時有「Paste to Figma」或「Copy to Figma」功能,可將設計匯入 Figma 進行進一步編輯。

Stitch 的定位與比較優勢

輔助工具,而非全面取代設計平台 :Stitch 的設計是為了縮短「從構思到原型 UI +程式碼」之間的落差,而不是完全取代專業設計師在 Figma、Sketch、Adobe XD 等工具中的工作。設計師仍可用這些工具做精細調整。速度與效率 :使用 Stitch 生成 UI 設計/前端程式碼所需時間比從零開始設計加寫碼快很多,對於初期原型與快速驗證需求特別有用。可訪問性 :Stitch 在 Google Labs 平台上可用,用戶界面相對友好,降低新手與非設計背景者的進入門檻。

限制與要注意的地方

雖然 Stitch 支持匯出至 Figma,但某些情況(如從上傳圖片/草圖的模式)之下,Figma 匯出功能尚未全功能完善。

設計細節(例如文字對齊、某些複雜元件組件化)有時候不完美,需要人工修正。

現階段仍為實驗性/預覽模式(experimental / Labs),可能在某些瀏覽器支援或功能穩定性上有差異。

使用流程簡易指南

前往 Stitch 官方網站 (stitch.withgoogle.com)並登入 Google 帳號。

選擇撰寫 prompt 或上傳參考圖片/草圖/線框圖。描述顏色、風格、佈局等細節。

等待 Stitch 生成 UI 設計與初步程式碼(HTML/CSS)。

若要匯出至 Figma,可使用「Copy to Figma / Paste to Figma」功能以便進一步編輯。

若為開發者,可直接取出 HTML/CSS 並嵌入 IDE 或網頁專案中。

Google Stitch 的收費/使用限額情況

從目前公開資訊來看,Google Stitch 屬於 Google Labs 的實驗性工具(beta 或公測階段),目前是免費使用 ,但有一些使用次數與模式上的限額/差異。下面是具體情況:

模式 免費與否 每月生成次數限額 Standard Mode(Flash 模式) 免費 每帳號每月約 350 次生成 │ 適合一般快速原型與草圖生成,可匯出 Figma 或 Code。 Experimental Mode(實驗/Pro 模式) 免費 每帳號每月約 50 次生成 │ 使用更強的 Gemini 2.5 Pro 模型;目前部分功能(如匯出 Figma)或效能有些限制。

參考資料

VIDEO

近期留言