by rainchu | 7 月 31, 2024 | AI, Tool, 圖型處理

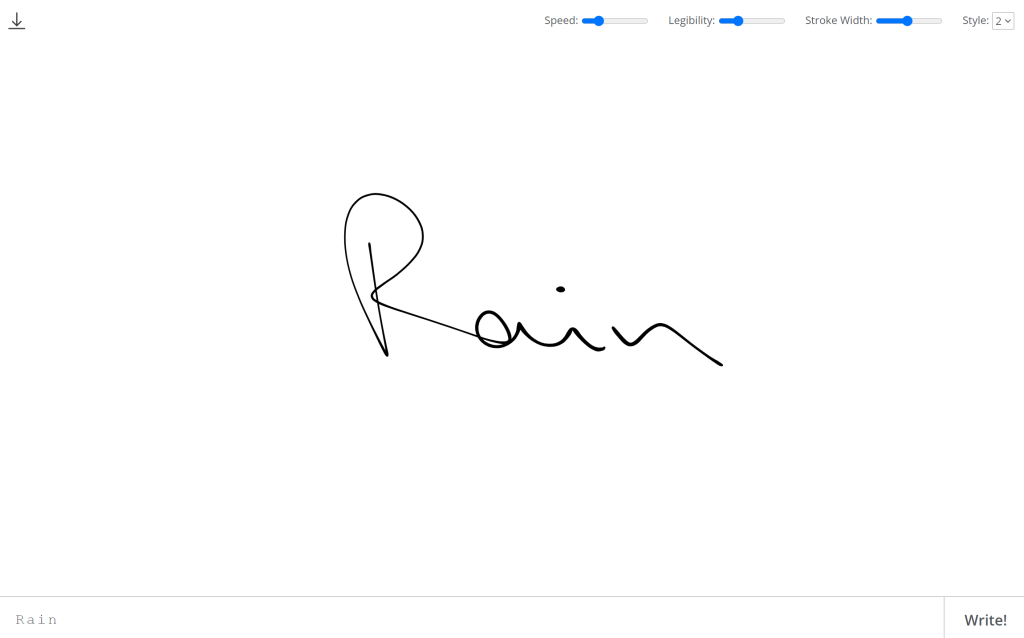

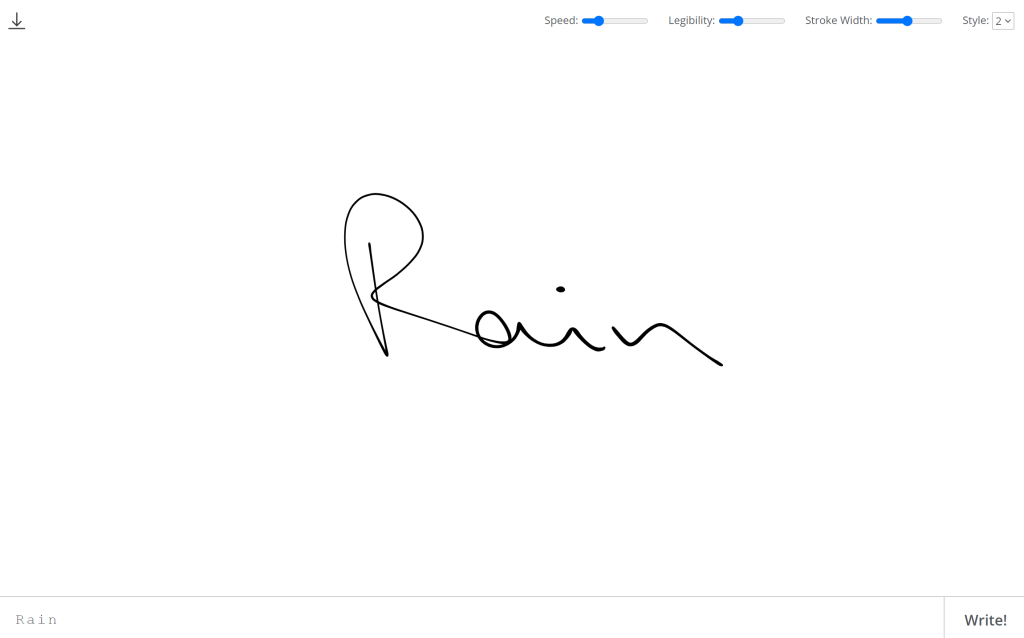

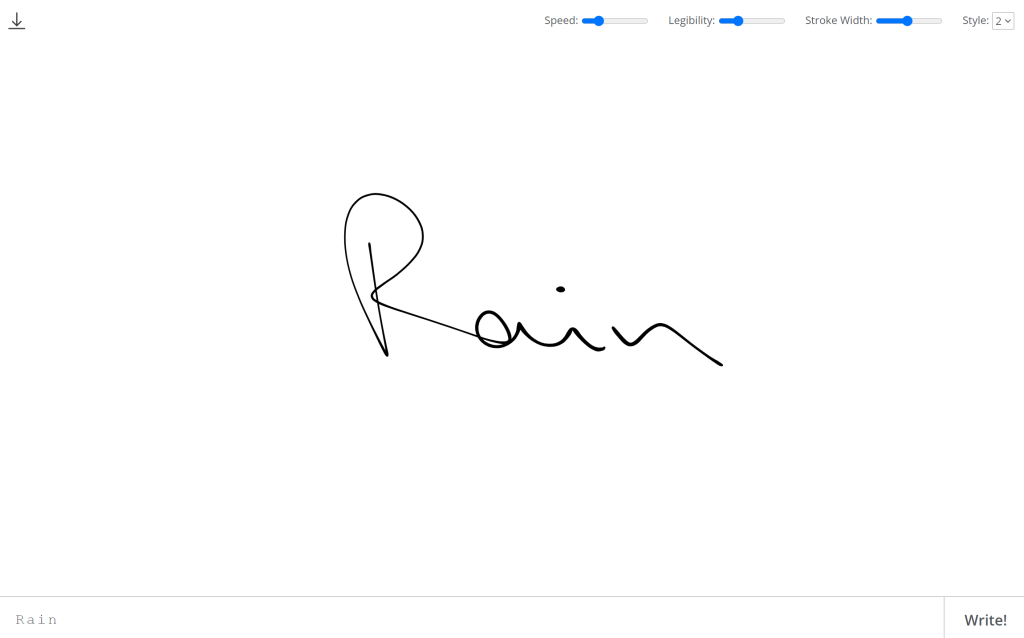

沒想到AI也可以替你簽名吧?人工智能(AI)已經滲透到我們日常生活的各個方面,其中一項創新應用就是AI手寫文字服務。這類服務提供一個獨特的平台,讓用戶能夠將標準的打字文字轉換成具有個人風格的手寫文字,每一次生成的結果都是獨一無二的。

以下是這類網站的主要功能特色:

1. 個性化手寫生成

用戶只需提供需要轉換的文字,AI系統便能根據預設的或是自訂的手寫樣式,生成具有個人特色的手寫文字圖檔。這種服務特別適合需要在數位媒體上展現個人風格的使用者,例如藝術家、設計師或是市場行銷人員。

2. 多樣化的風格選擇

用戶可以選擇不同的手寫風格,從而使生成的文字展現出多樣的視覺效果。這些風格可能包括但不限於古典書法、現代潦草筆跡或是具有特定情感表達的筆觸。

3. 高解析度圖檔下載

一旦文字被AI轉換成手寫風格,用戶便可以以多種格式下載這些圖檔,例如PNG、JPG或SVG等。這些高解析度的圖檔適合用於各種印刷和數位出版需求。

4. 獨特性與創造性的表現

每次生成的手寫文字都是唯一的,這不僅讓每一份文件都帶有獨特的個人觸感,也增添了文件的創造性和藝術價值。

5. 簡便的使用流程

大多數AI手寫文字網站都設計有用戶友好的界面,使得從文字輸入到圖檔下載的整個過程既快速又簡便。用戶無需擁有專業的設計技能,就可以輕鬆操作並獲得高質量的結果。

https://www.calligrapher.ai

延伸閱讀

by rainchu | 7 月 22, 2024 | AI, Chat

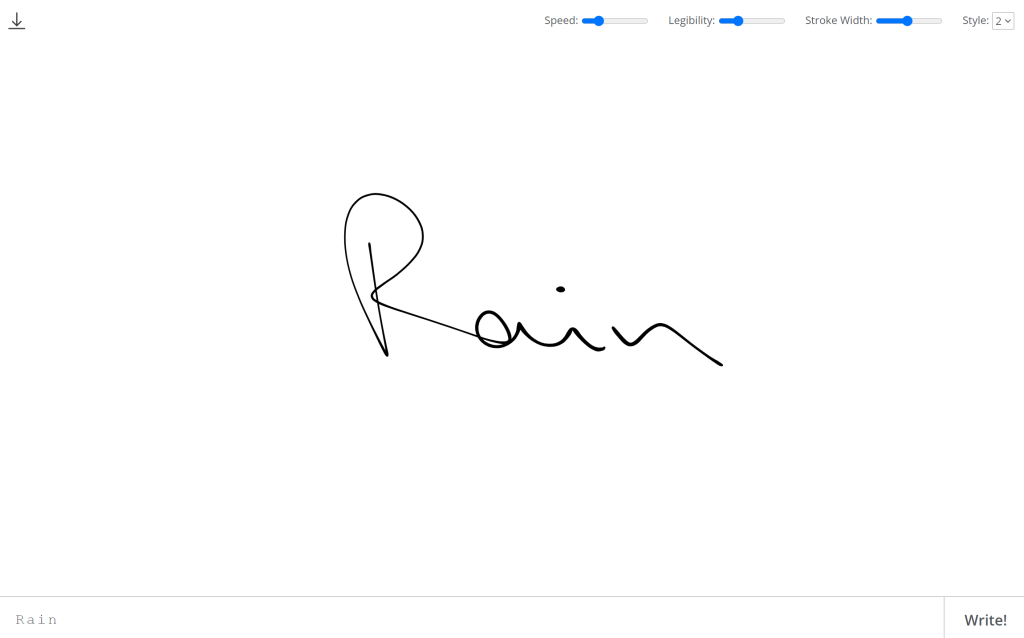

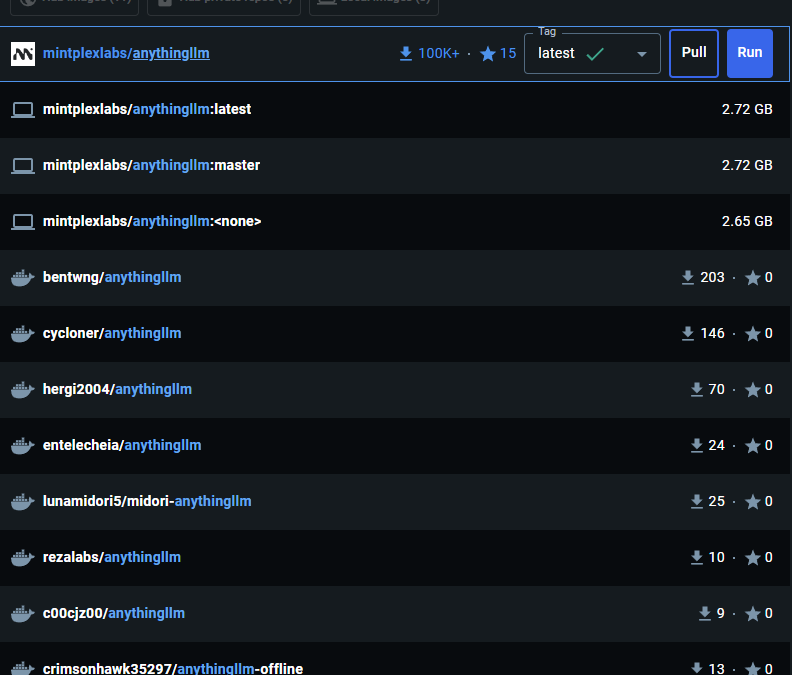

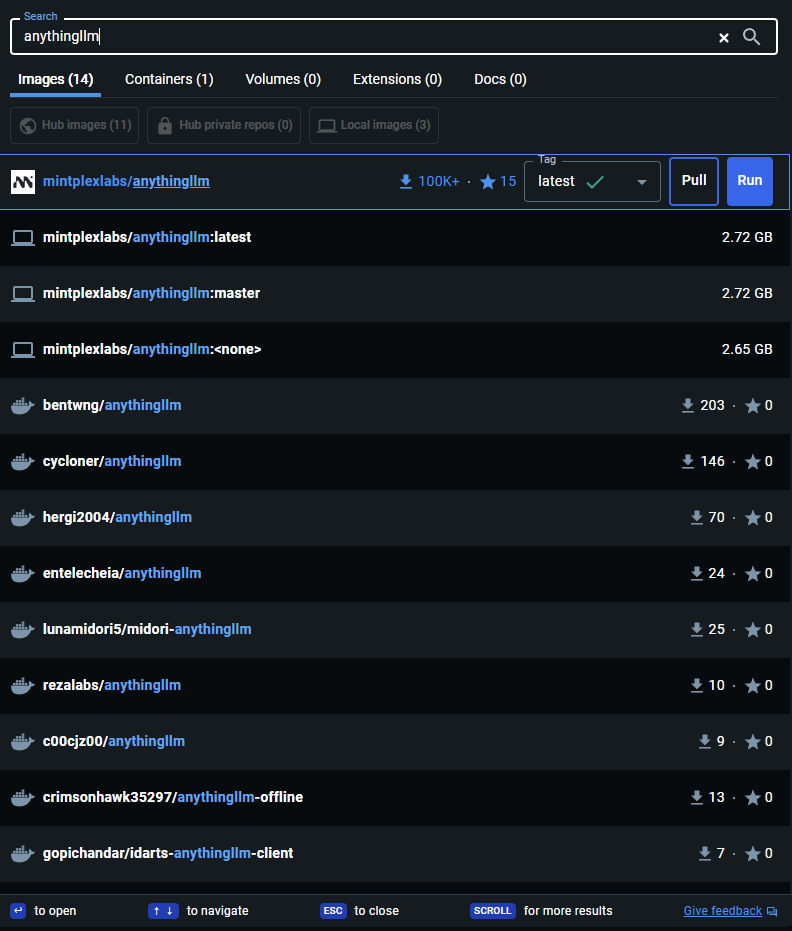

AnythingLLm 官方最推薦的安裝方法是採用 docker,可以最快速的體驗 anything llm web ui 以及驗證想法,雖然說用docker安裝已經超簡單了,但還是有些小細節值得記錄一下,並且告訴大家避免採坑。

最低要求

最低需要 Docker v18.03+ 版本在 Win/Mac 上和 20.10+ 版本在 Linux/Ubuntu 上才能解析 host.docker.internal

Linux:在 docker run 命令中添加 –add-host=host.docker.internal參數以使其能夠解析。例如:在主機上 localhost:8000 上運行的 Chroma 主機 URL 在 AnythingLLM 中使用時需改為 http://host.docker.internal:8000。

安裝指令

docker pull mintplexlabs/anythingllm

Windows 的設定指令,定義好你要存放 llm 的位址

$env:STORAGE_LOCATION="$HOMEDocumentsanythingllm"; `

If(!(Test-Path $env:STORAGE_LOCATION)) {New-Item $env:STORAGE_LOCATION -ItemType Directory}; `

If(!(Test-Path "$env:STORAGE_LOCATION.env")) {New-Item "$env:STORAGE_LOCATION.env" -ItemType File}; `

docker run -d -p 3001:3001 `

--cap-add SYS_ADMIN `

-v "$env:STORAGE_LOCATION`:/app/server/storage" `

-v "$env:STORAGE_LOCATION.env:/app/server/.env" `

-e STORAGE_DIR="/app/server/storage" `

mintplexlabs/anythingllm;多個 Anything llm containers

如果你需要安裝多個anything llm,那記得要改兩個位置

- $env:STORAGE_LOCATION=”$HOMEDocumentsanythingllm-yourid”; `

- docker run -d -p 8001(改成你自己的port):3001 `

修改玩會像是下面的樣子

$env:STORAGE_LOCATION="$HOMEDocumentsanythingllm-yourid"; `

If(!(Test-Path $env:STORAGE_LOCATION)) {New-Item $env:STORAGE_LOCATION -ItemType Directory}; `

If(!(Test-Path "$env:STORAGE_LOCATION.env")) {New-Item "$env:STORAGE_LOCATION.env" -ItemType File}; `

docker run -d -p 8001:3001 `

--cap-add SYS_ADMIN `

-v "$env:STORAGE_LOCATION`:/app/server/storage" `

-v "$env:STORAGE_LOCATION.env:/app/server/.env" `

-e STORAGE_DIR="/app/server/storage" `

--name yourid `

mintplexlabs/anythingllm;之後可以執行 Docker run

docker run -d -p 8001:3001 --cap-add SYS_ADMIN --user root -v "$env:STORAGE_LOCATION:/app/server/storage" -v "$env:STORAGE_LOCATION.env:/app/server/.env" -e STORAGE_DIR="/app/server/storage" mintplexlabs/anythingllm

利用 Docker Compose 安裝

先寫一段 docker-compose.yml ,再用 docker-compose up -d 執行即可

version: '3.8'

services:

anythingllm:

image: mintplexlabs/anythingllm

container_name: anythingllm

ports:

- "3001:3001"

volumes:

- ./storage:/app/server/storage

- ./env.txt:/app/server/.env

environment:

- STORAGE_DIR=/app/server/storage

cap_add:

- SYS_ADMIN

extra_hosts:

- "host.docker.internal:host-gateway"

restart: unless-stopped利用介面安裝

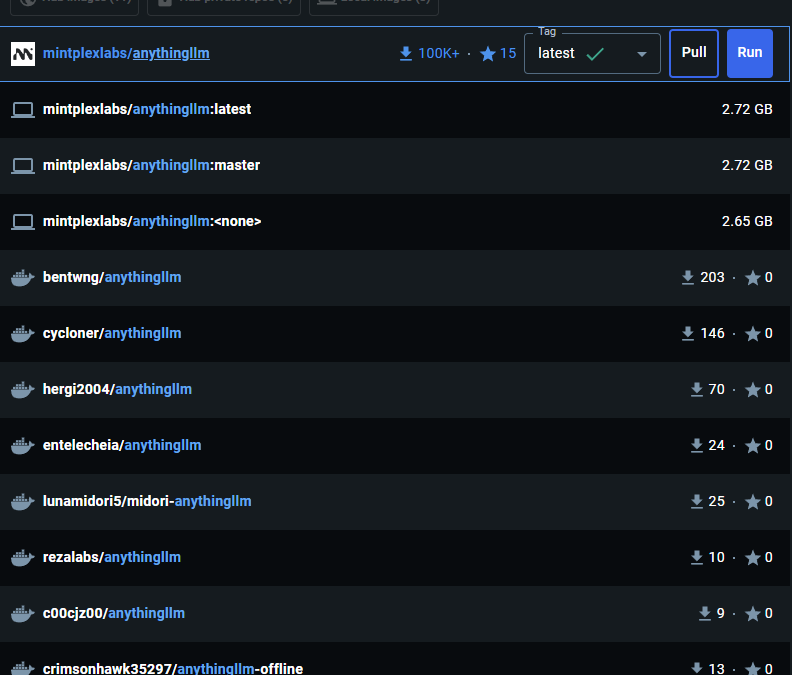

在 docker desktop 的搜尋框內輸入 anythingllm ,找到 mintpolexlabs/anythingllm,並且按下 Run

下載完畢後記得要做第一次的初始化設定喔

TIPS

記得你現在運行的服務是在 docker 中,如果您在 localhost 上運行其他服務,如 Chroma、LocalAi 或 LMStudio,您將需要使用 http://host.docker.internal:xxxx 從 Docker 容器內訪問該服務,因為 localhost對主機系統來說無法解析。

參考資料

https://docs.useanything.com/installation/self-hosted/local-docker

錯誤解決

如果遇到Error : ‘Invalid file upload. EACCES: permission denied, open ‘/app/collector/hotdir/xxxx.txt’,可以用以下的方法解決

docker run -d -p 8001:3001 --cap-add SYS_ADMIN --user root -v "$env:STORAGE_LOCATION:/app/server/storage" -v "$env:STORAGE_LOCATION.env:/app/server/.env" -e STORAGE_DIR="/app/server/storage" mintplexlabs/anythingllm

by rainchu | 7 月 16, 2024 | 3D, AI

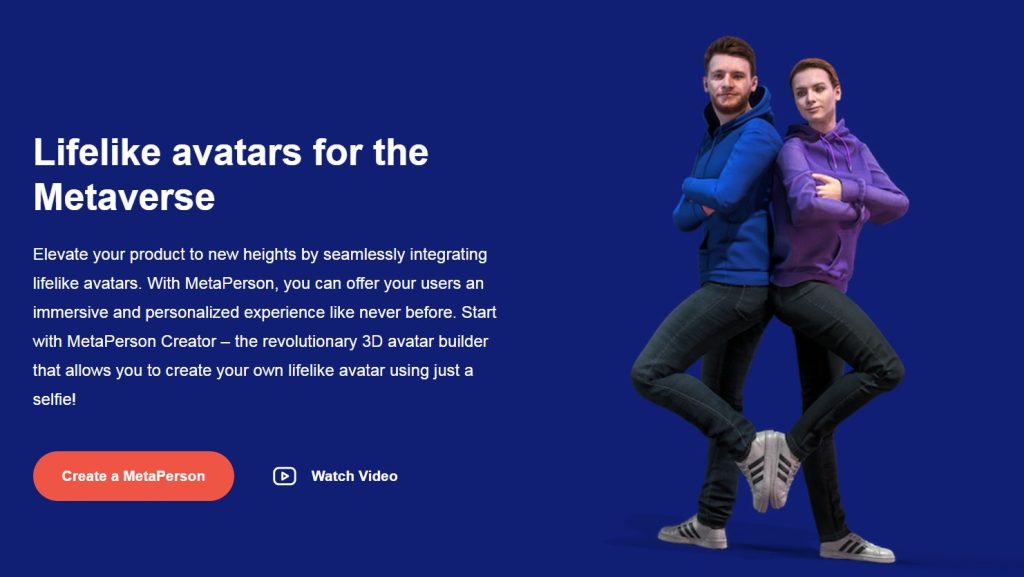

有了像Avatar SDK這樣的工具,即使是初學者也能輕鬆創建精細的3D人物模型,Avatar SDK是一個強大的3D人物創建平台,用戶只需上傳一張人物照片,就能迅速生成包括全身、半身以及人頭模型在內的3D模型。

重點特色:

- 中文介面支持:為了方便中文使用者,Avatar SDK提供完整的中文版本,使得操作介面、說明文件及客戶支持都親切易懂。

- 快速模型建立:在Avatar SDK中,3D模型的生成速度非常快,通常只需大約1分鐘。這意味著用戶可以節省大量時間,專注於創意和設計過程。

- 高度自定義選項:用戶不僅可以生成基本模型,還可以根據需要自定義頭髮、膚色等屬性。這種靈活性使得每一個模型都能夠真實反映原照片的特徵,同時也能按用戶的創意進行調整。

- 導出為OBJ檔案:生成的模型可以下載為OBJ格式,這是一種廣泛支持的3D檔案格式,允許用戶輕鬆地將模型導入到其他3D編輯軟件中,如Autodesk Maya、Blender等,進行進一步的編輯和應用。

定價策略

參考資料

https://avatarsdk.com

by Rain Chu | 6 月 27, 2024 | AI, 人臉辨識, 影片製作, 語音合成

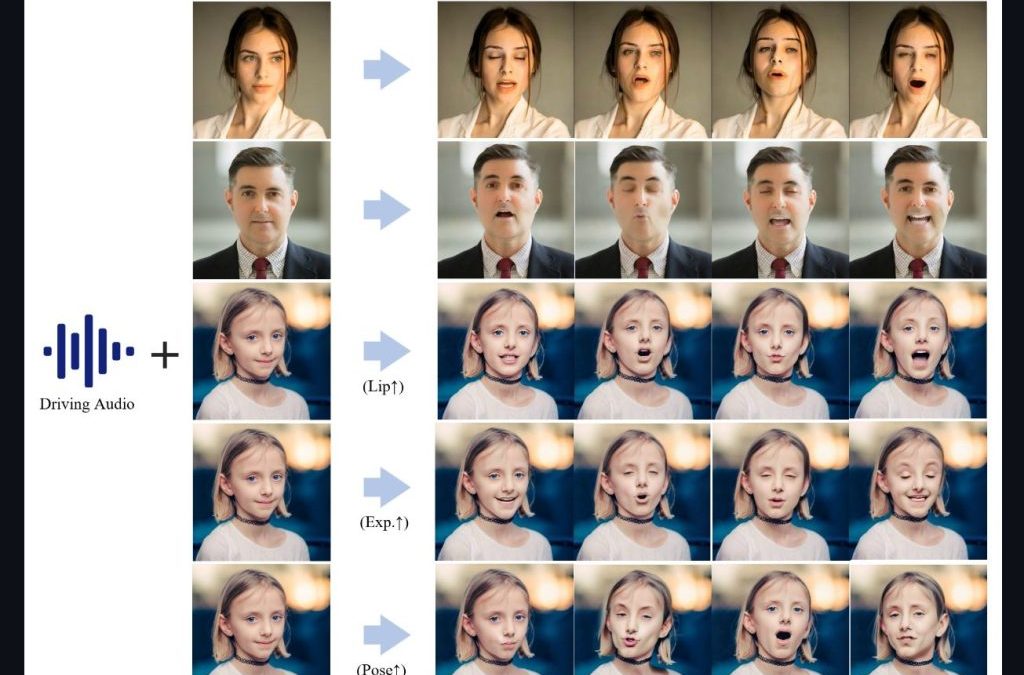

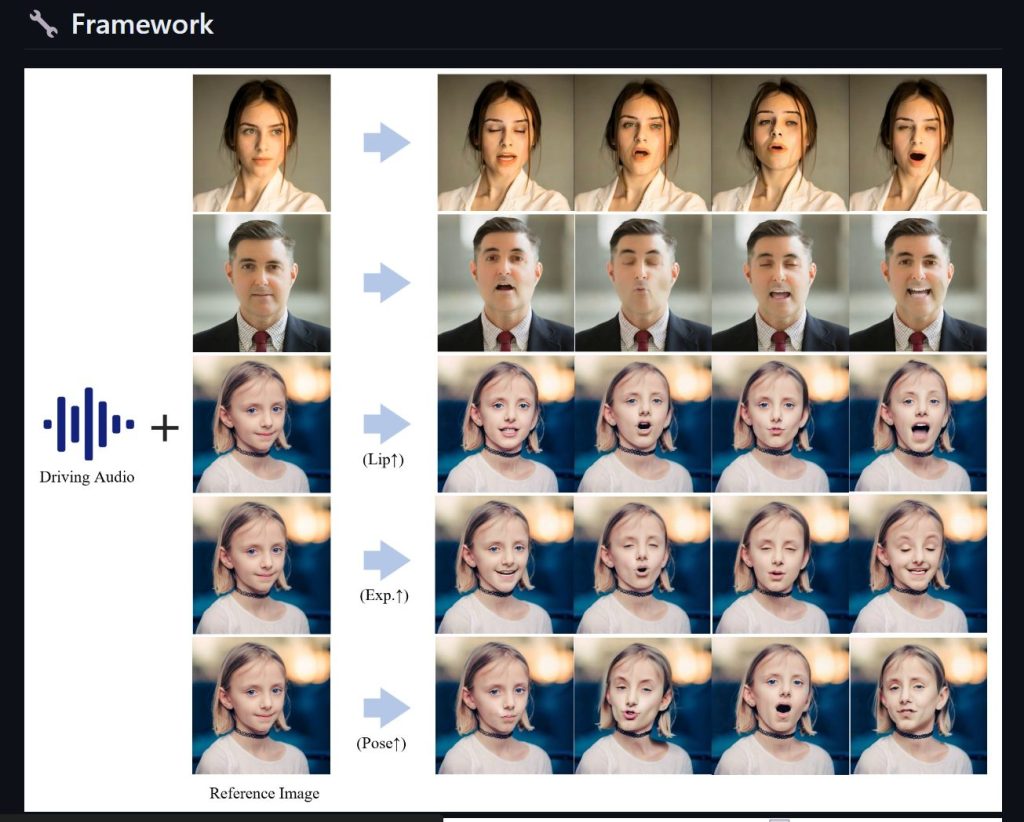

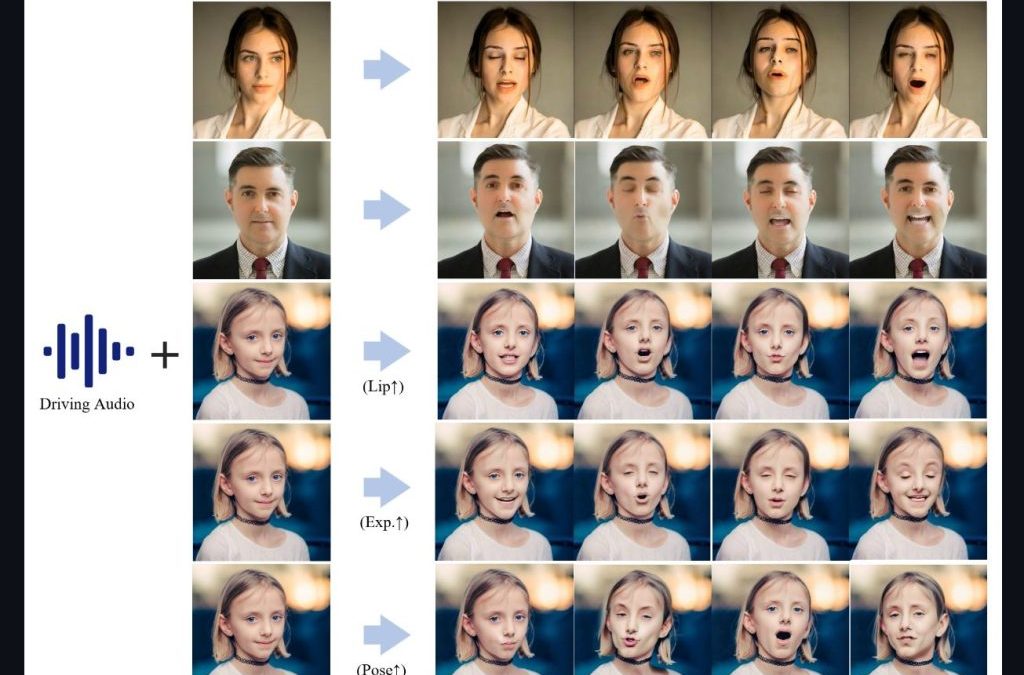

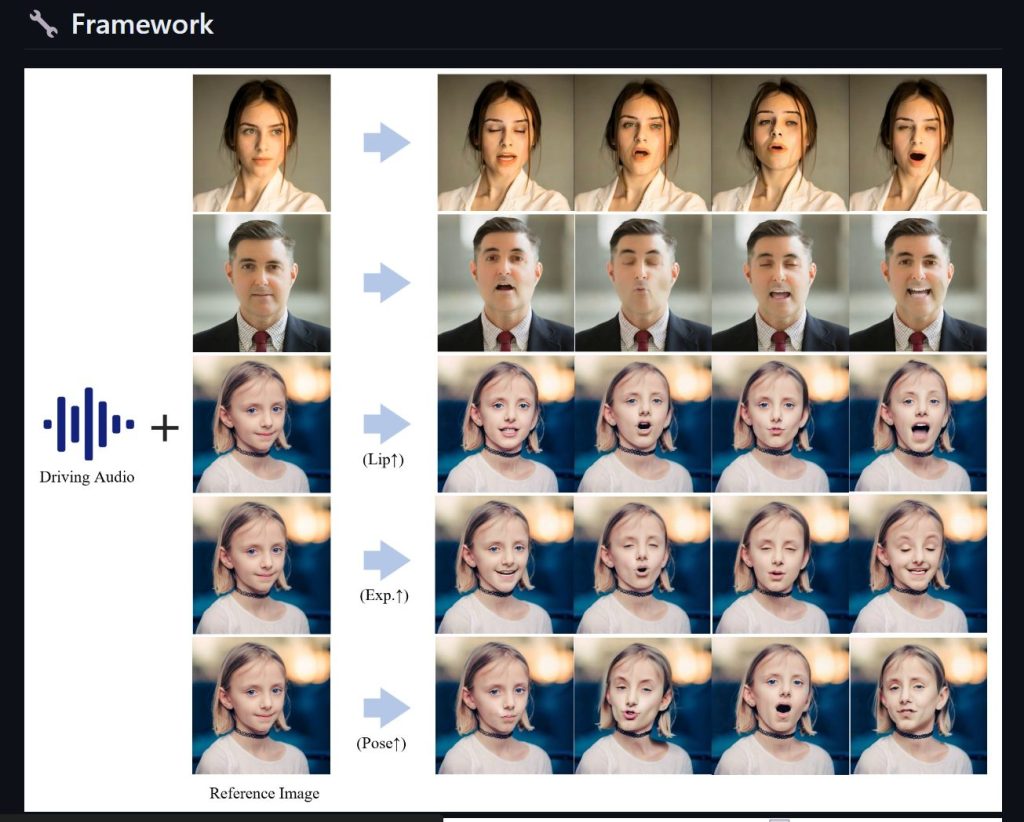

Fusion Lab 又有新款力作,Hallo AI 可以讓用戶僅需提供一張照片和一段語音,就能讓照片中的人物進行說話、唱歌甚至進行動作,為數字內容創作帶來了革命性的突破。

主要功能介紹:

- 語音動畫同步:用戶只需上傳一張照片及一段WAV格式的英語語音,Hallo AI就能使照片中的人物按語音內容進行動作,包括說話和唱歌。

- 動作自然流暢:結合精確的面部識別和動作捕捉技術,保證人物動作的自然流暢,令人印象深刻。

技術框架:

- 音頻處理:使用Kim_Vocal_2 MDX-Net的vocal removal模型分離語音。

- 面部分析:透過insightface進行2D和3D的臉部分析。

- 面部標記:利用mediapipe的面部檢測和mesh模型進行精確標記。

- 動作模組:AnimateDiff的動作模組為動作生成提供支持。

- 影像生成:StableDiffusion V1.5和sd-vae-ft-mse模型協同工作,用於生成和調整圖像細節。

- 聲音向量化:Facebook的wav2vec模型將WAV音頻轉換為向量數據。

安裝方法

盡量採用 Linux 平台,我這邊測試成功的有 Ubuntu 20 WSL 版本,就可以簡單三個步驟,部過前提要記得先安裝好 WSL CUDA 支援

1.建立虛擬環境

conda create -n hallo python=3.10

conda activate hallo

2.安裝相關的依賴

pip install -r requirements.txt

pip install .

3.要有 ffmpeg 支援

4.測試與驗證

python scripts/inference.py --source_image examples/reference_images/1.jpg --driving_audio examples/driving_audios/1.wav

最近更新:

- 在🤗Huggingface空間克隆了一個Gradio演示。

- 新增Windows版本、ComfyUI界面、WebUI和Docker模板。

參考資料

Hallo GitHub

Hallo Model

大神開發的Windows介面

Hallo 線上版本

Hallo Docker版

影片跳舞合成

by Rain Chu | 6 月 21, 2024 | AI, 影片製作

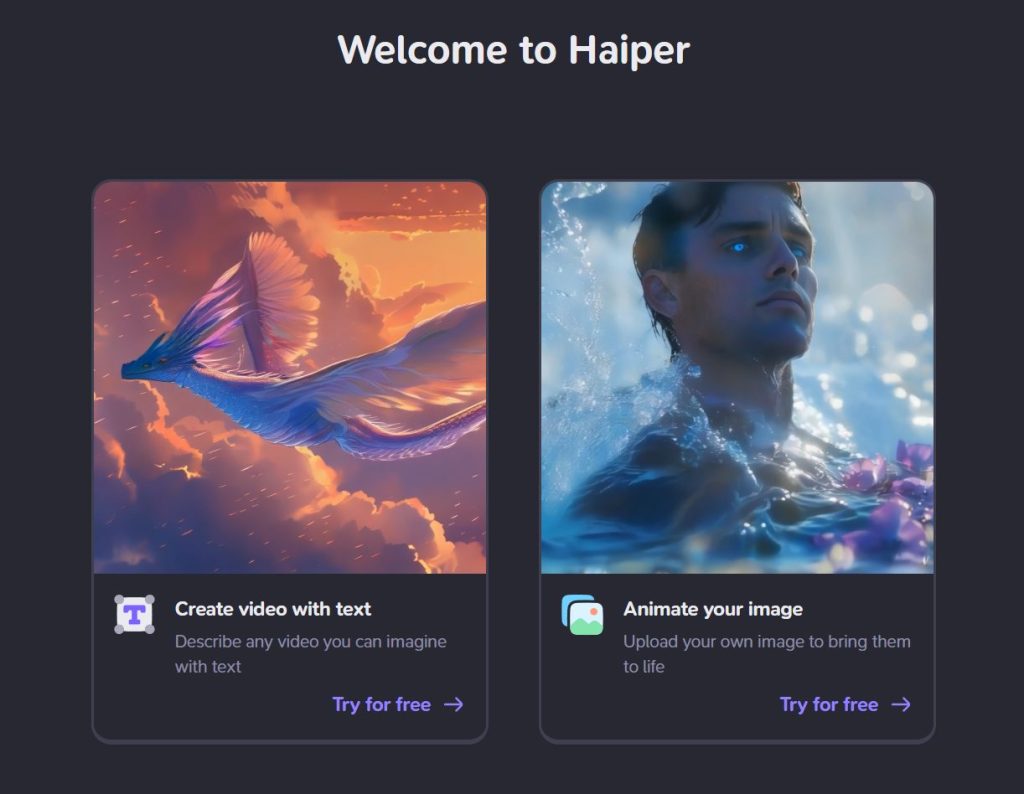

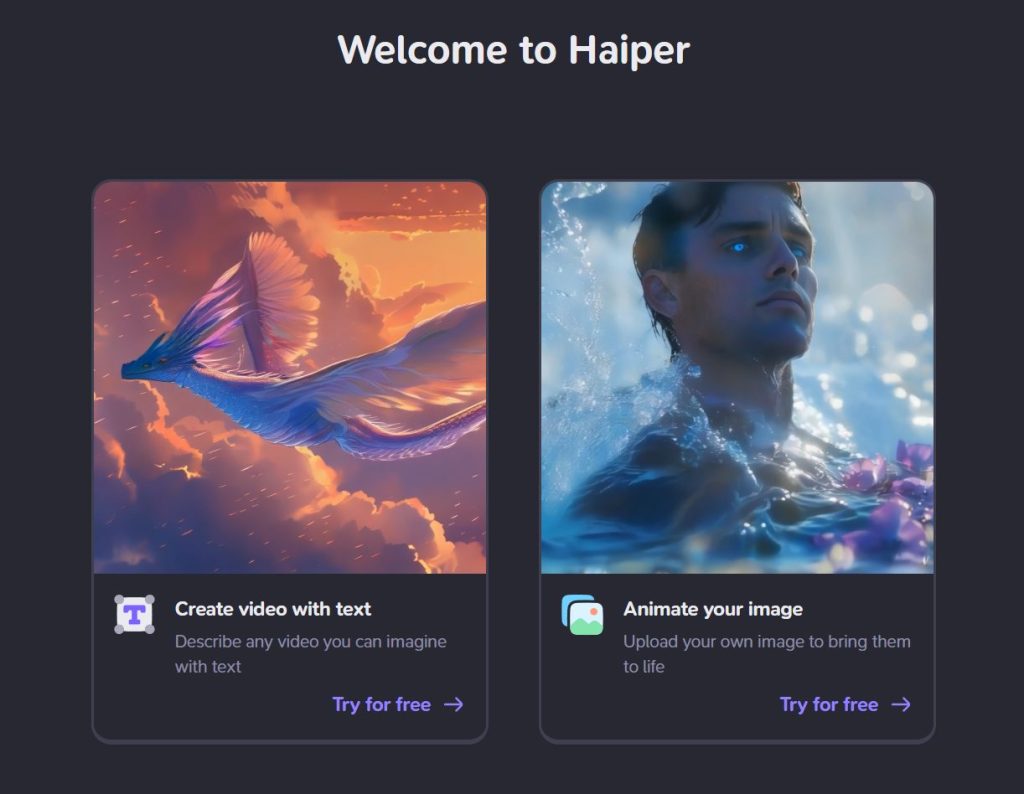

Haiper AI 是一個超酷且利用AI來創作視頻內容的創新平台。由來自 Google DeepMind、TikTok 及其他頂尖研究機構的校友創建,Haiper 將尖端的機器學習技術與創意相結合,致力於為使用者提供簡單直觀且強大的視頻創作工具。

核心功能

文本生成視頻:

Haiper 提供文本生成視頻的功能,使用者只需輸入文本描述,就能創作出引人入勝的動畫視覺故事。這項功能讓視頻創作變得簡單且高效,即使是沒有專業技術背景的使用者也能輕鬆上手。

圖像生成視頻:

除了文本生成視頻外,Haiper 還能將靜態圖像轉化為動態視頻。使用者可以通過拖放圖像,並利用 AI 技術賦予這些圖像新的生命,使其變得生動有趣。

視頻重繪:

Haiper 的視頻重繪工具允許使用者輕鬆修改視頻中的顏色、紋理及元素。這項功能讓使用者能夠根據自己的需求對現有視頻進行重新創作,提升視頻的視覺效果和吸引力 。

創意社區與使用者友好

Haiper 不僅是一個視頻創作工具,更是一個鼓勵創意和分享的社區,可以一鍵快速的發布你的作品,平台強調用戶互動,收集用戶反饋來不斷改進和發展其 AI 模型,確保其能夠滿足多樣化的創意需求。Haiper 的使命是通過技術的力量來激發創造力,讓每一個人都能夠輕鬆地表達自己的創意 。

更多信息請訪問 Haiper 官方網站。

參考資料

by Rain Chu | 6 月 21, 2024 | AI, 影片製作

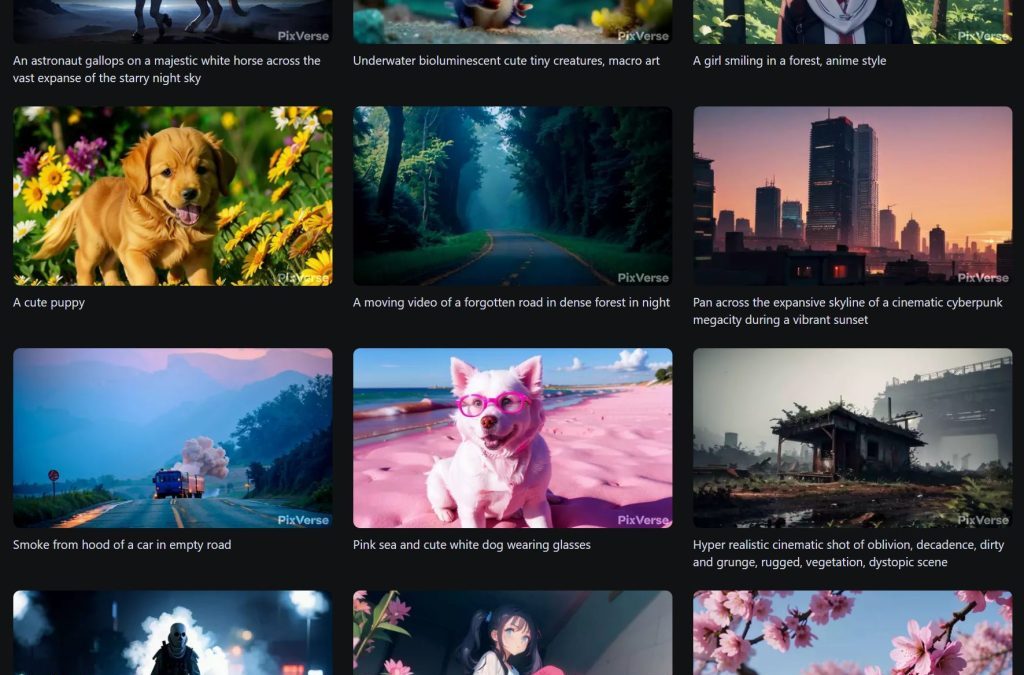

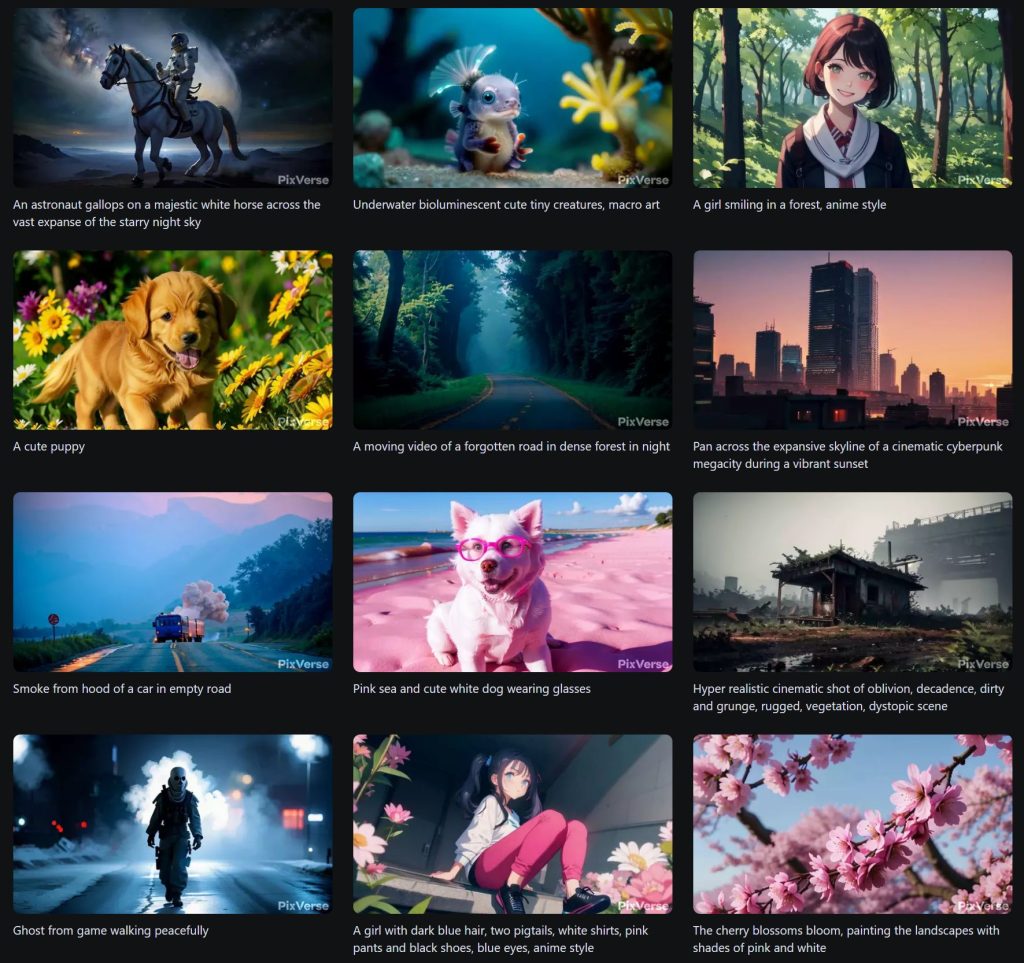

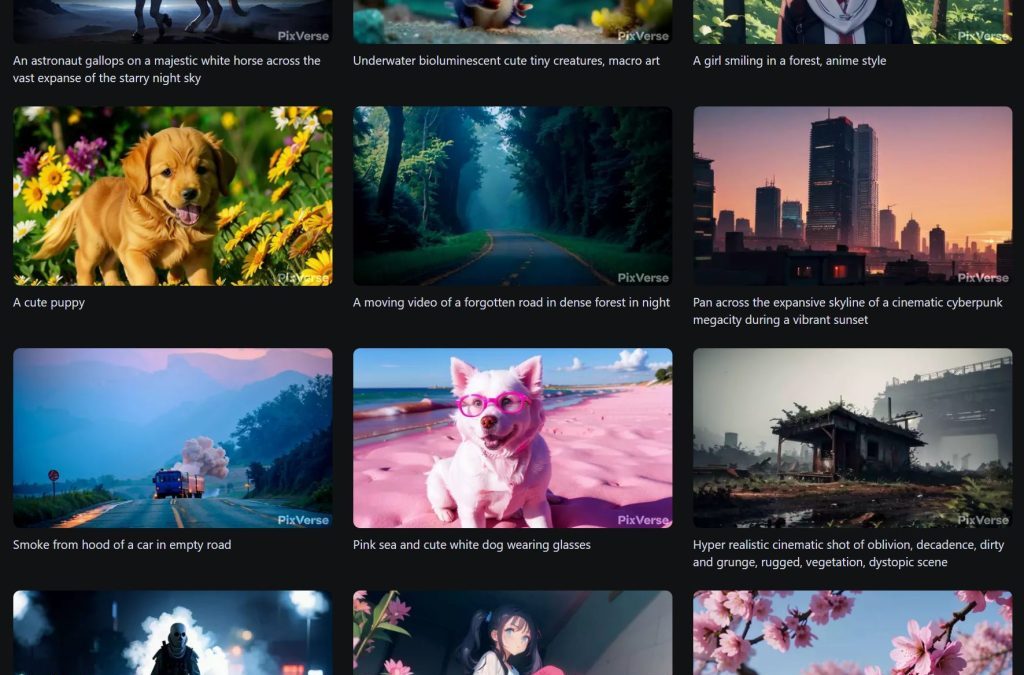

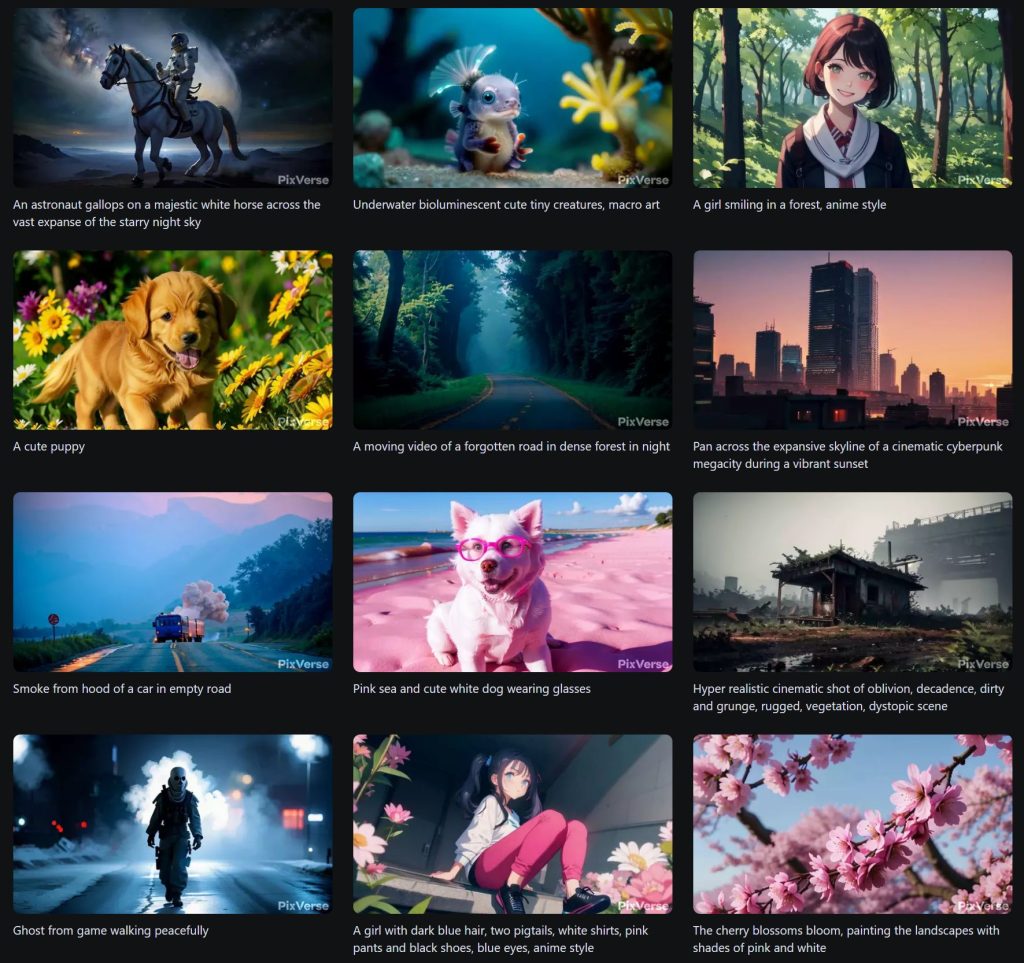

PixVerse是其中一個令人驚艷的AI工具,能夠簡化影片製作的流程,還能生成出超現實的效果。以下是PixVerse的一些亮點:

1. 超多寫實的電影場景

PixVerse 提供了一個豐富的電影場景庫,涵蓋了各種不同風格和題材的場景。無論是科幻未來城市還是古典歐洲城堡,使用者都可以輕鬆找到適合自己影片的背景。這些場景不僅僅是靜態圖片,而是經過精心設計和渲染的3D環境,能夠帶給觀眾身臨其境的視覺體驗。

2. 自由用遮罩控制需要運動的物件

在影片製作中,物件的運動和互動是至關重要的。PixVerse 讓使用者能夠通過遮罩技術,自由控制影片中各種物件的運動方向和速度。例如,在製作一部鯊魚主題的影片時,使用者可以使用遮罩來精確控制鯊魚的游泳方向,讓影片更加真實和生動。這種自由度讓影片製作變得更加靈活和創意十足。

3. 利用人物生成視頻功能

除了場景和物件運動,PixVerse 還具備利用人物生成視頻功能。使用者可以根據自己的需求,調整角色的外觀、動作和表情。這些角色不僅外觀真實,而且可以根據劇情需要做出自然的動作和反應。無論是需要一個動作明星還是日常生活中的普通人,PixVerse 都能夠快速生成,極大地節省了角色設計和建模的時間。

參考資料

https://pixverse.ai

近期留言