by Rain Chu | 3 月 10, 2025 | AI, 影片製作

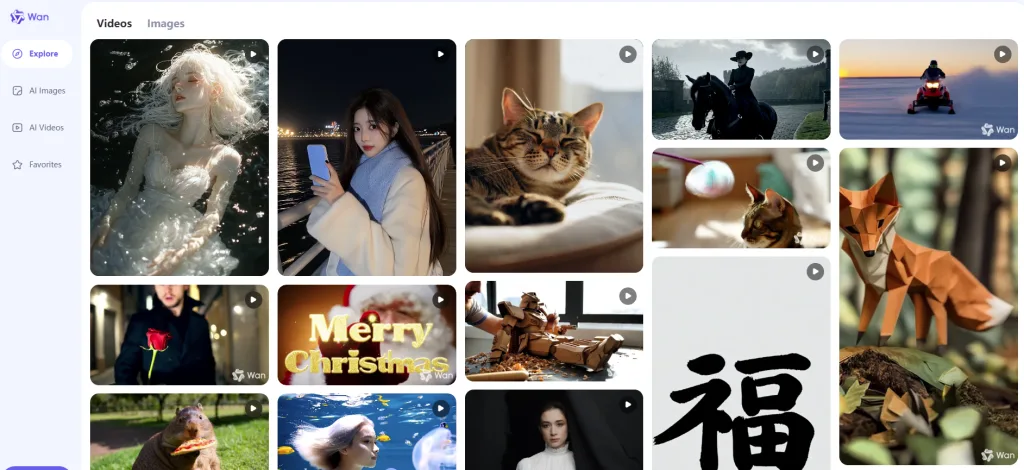

探索阿里巴巴開源的 AI 影片製作模型:Wan 2.1

阿里巴巴近期推出的開源影片生成模型——Wan 2.1,為創作者提供了一個強大且高效的工具。該模型不僅完全開源,還具備極快的生成速度,並融入了豐富的東方元素,如哪吒等,為影片創作帶來了新的可能性。

Wan 2.1 的主要特色

完全開源,兼容性強

Wan 2.1 採用 Apache 2.0 協議開源,這意味著開發者可以自由地使用、修改和分發該模型,甚至用於商業用途。此外,Wan 2.1 支援 ComfyUI 等圖形介面,方便用戶進行可視化操作,降低了技術門檻。

高效的影片生成速度

得益於先進的架構設計,Wan 2.1 在影片生成速度上表現優異。即使在消費級 GPU 上,如 RTX 3070 顯卡,使用 1.3B 參數模型即可流暢運行,生成 480P 分辨率的影片,更何況現在已經來到了RTX 5090,這將讓個人也能夠在本地設備上高效地進行影片創作。

豐富的東方元素融入

Wan 2.1 在影片生成中融入了大量的東方元素,特別是中國傳統文化中的角色和場景。例如,模型能夠生成包含哪吒等經典角色的影片,這為喜愛東方文化的創作者提供了更多的創作靈感和素材。

如何離線使用 Wan 2.1 進行影片創作

- 環境準備:首先,確保您的電腦具備足夠的硬體資源,建議使用至少 12GB 顯存的顯卡。

- 下載模型:從官方 GitHub 倉庫或 HuggingFace 平台下載 Wan 2.1 的模型檔案。

- 安裝依賴:根據官方指引,安裝所需的 Python 套件和其他依賴項。

- 運行 ComfyUI:啟動 ComfyUI,載入 Wan 2.1 模型,並按照介面提示輸入文本或上傳圖片,以生成對應的影片內容。

- 下載 ComfyUI 工作流 : JSON

參考資料

https://www.freedidi.com/18705.html

by Rain Chu | 6 月 27, 2024 | AI, 人臉辨識, 影片製作, 語音合成

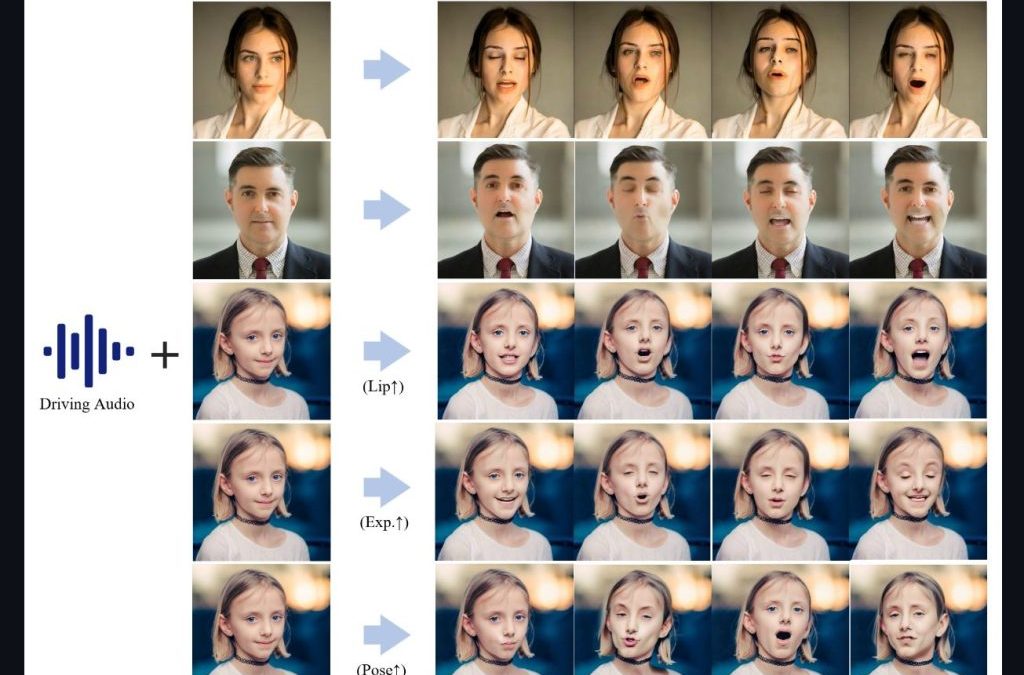

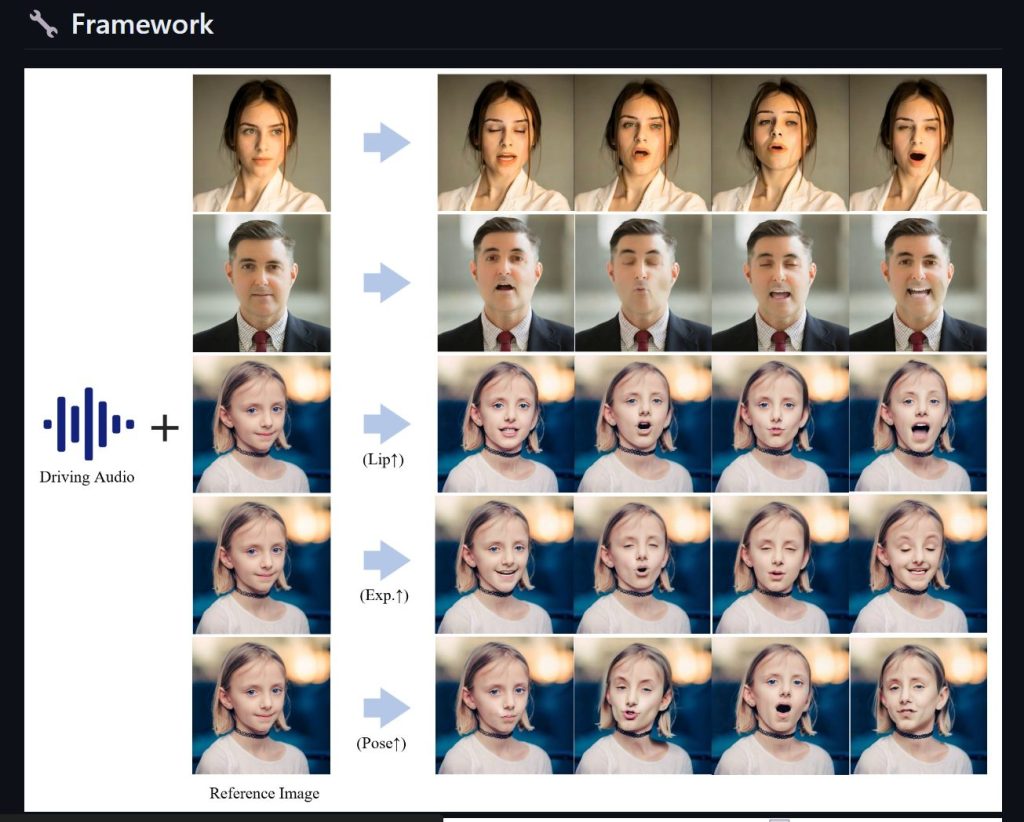

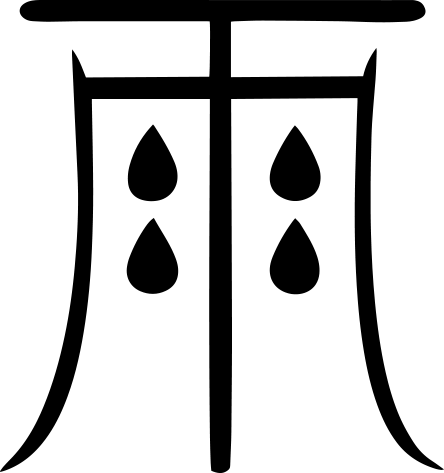

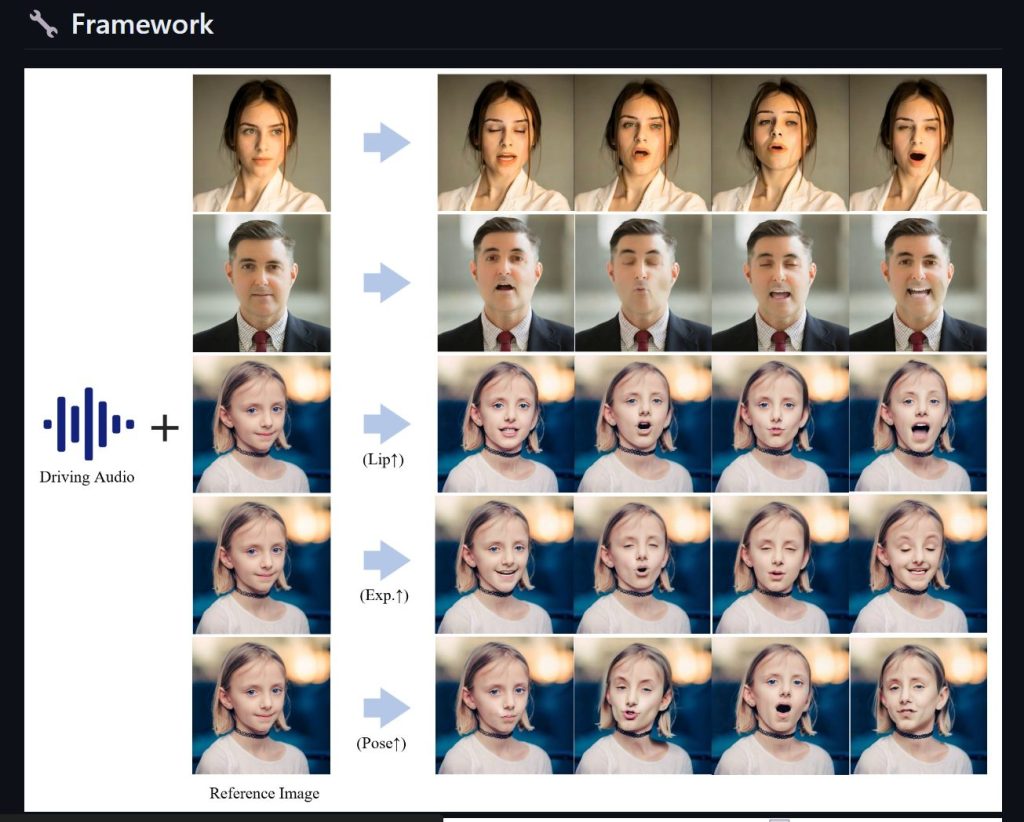

Fusion Lab 又有新款力作,Hallo AI 可以讓用戶僅需提供一張照片和一段語音,就能讓照片中的人物進行說話、唱歌甚至進行動作,為數字內容創作帶來了革命性的突破。

主要功能介紹:

- 語音動畫同步:用戶只需上傳一張照片及一段WAV格式的英語語音,Hallo AI就能使照片中的人物按語音內容進行動作,包括說話和唱歌。

- 動作自然流暢:結合精確的面部識別和動作捕捉技術,保證人物動作的自然流暢,令人印象深刻。

技術框架:

- 音頻處理:使用Kim_Vocal_2 MDX-Net的vocal removal模型分離語音。

- 面部分析:透過insightface進行2D和3D的臉部分析。

- 面部標記:利用mediapipe的面部檢測和mesh模型進行精確標記。

- 動作模組:AnimateDiff的動作模組為動作生成提供支持。

- 影像生成:StableDiffusion V1.5和sd-vae-ft-mse模型協同工作,用於生成和調整圖像細節。

- 聲音向量化:Facebook的wav2vec模型將WAV音頻轉換為向量數據。

安裝方法

盡量採用 Linux 平台,我這邊測試成功的有 Ubuntu 20 WSL 版本,就可以簡單三個步驟,部過前提要記得先安裝好 WSL CUDA 支援

1.建立虛擬環境

conda create -n hallo python=3.10

conda activate hallo

2.安裝相關的依賴

pip install -r requirements.txt

pip install .

3.要有 ffmpeg 支援

4.測試與驗證

python scripts/inference.py --source_image examples/reference_images/1.jpg --driving_audio examples/driving_audios/1.wav

最近更新:

- 在🤗Huggingface空間克隆了一個Gradio演示。

- 新增Windows版本、ComfyUI界面、WebUI和Docker模板。

參考資料

Hallo GitHub

Hallo Model

大神開發的Windows介面

Hallo 線上版本

Hallo Docker版

影片跳舞合成

近期留言