by Rain Chu | 3 月 17, 2025 | AI, Chat, Tool

DeepSeek R1 模型已經在 NVIDIA 平台上線,這是一個擁有 6710 億參數的開放式專家混合模型(MoE),專為解決需要高級 AI 推理的問題而設計的,但就是官方API不穩定,只能到處尋找替代的解決方案。

DeepSeek R1 的主要特點

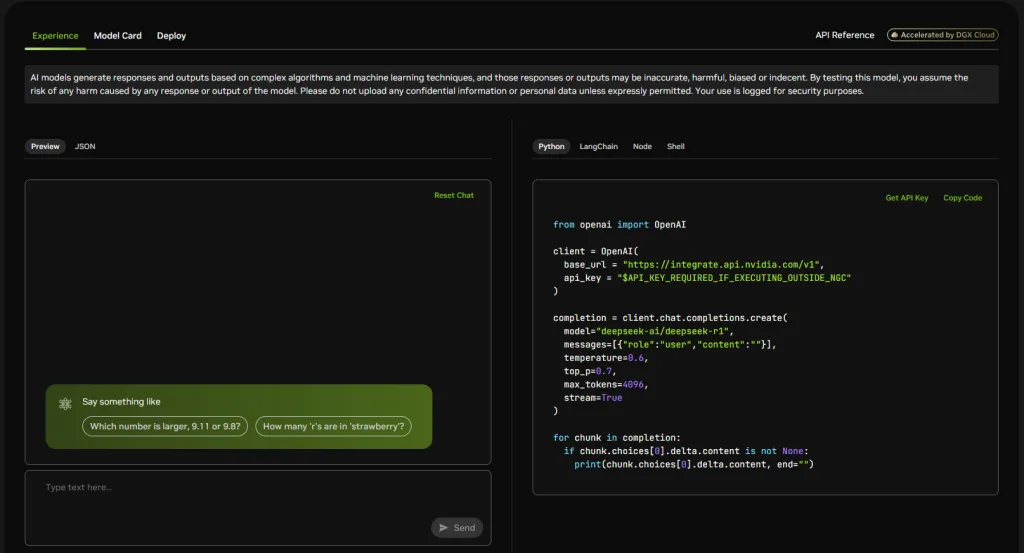

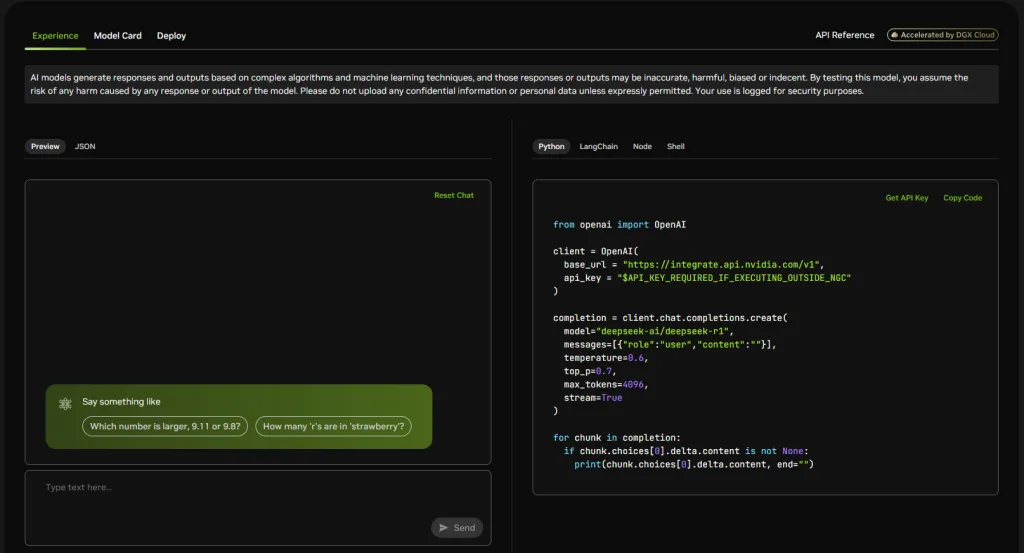

- API 友好性:DeepSeek R1 提供了多種 API 接口,支持 Python、LangChain、Node.js 和 Shell 等,方便開發者根據需求選擇合適的開發環境。

- 免費使用額度:NVIDIA 為個人和企業用戶提供了免費的使用額度。個人用戶可獲得 1000 點額度,企業用戶則可獲得 4000 點額度,讓更多人能夠體驗和使用該模型。

如何開始使用 DeepSeek R1

以下是使用 DeepSeek R1 的基本步驟:

- 註冊並獲取 API 密鑰:

- 前往 NVIDIA NIM 平台的 DeepSeek R1 頁面:

- 點擊右上角的「Login」或「Get API Key」,按照提示完成註冊並獲取 API 密鑰。

- 選擇開發環境並調用 API:

- Python:使用 OpenAI 兼容的客戶端調用 DeepSeek R1。 python複製編輯

- LangChain:可將 DeepSeek R1 集成到 LangChain 框架中,實現更複雜的語言處理任務。

- Node.js 和 Shell:NVIDIA 提供了相應的 SDK 和示例代碼,開發者可根據官方文檔進行集成。

用 python 來做示範

from openai import OpenAI

client = OpenAI(

base_url = "https://integrate.api.nvidia.com/v1",

api_key = "YOUR_API_KEY"

)

completion = client.chat.completions.create(

model="deepseek-ai/deepseek-r1",

messages=[{"role":"user","content":"你的問題內容"}],

temperature=0.6,

top_p=0.7,

max_tokens=4096,

stream=True

)

for chunk in completion:

if chunk.choices[0].delta.content is not None:

print(chunk.choices[0].delta.content, end="")

注意事項

- 使用額度:請留意您的免費使用額度,合理規劃 API 調用次數。

參考資料

https://build.nvidia.com/deepseek-ai/deepseek-r1

by rainchu | 12 月 24, 2024 | Linux, Ubuntu, Windows

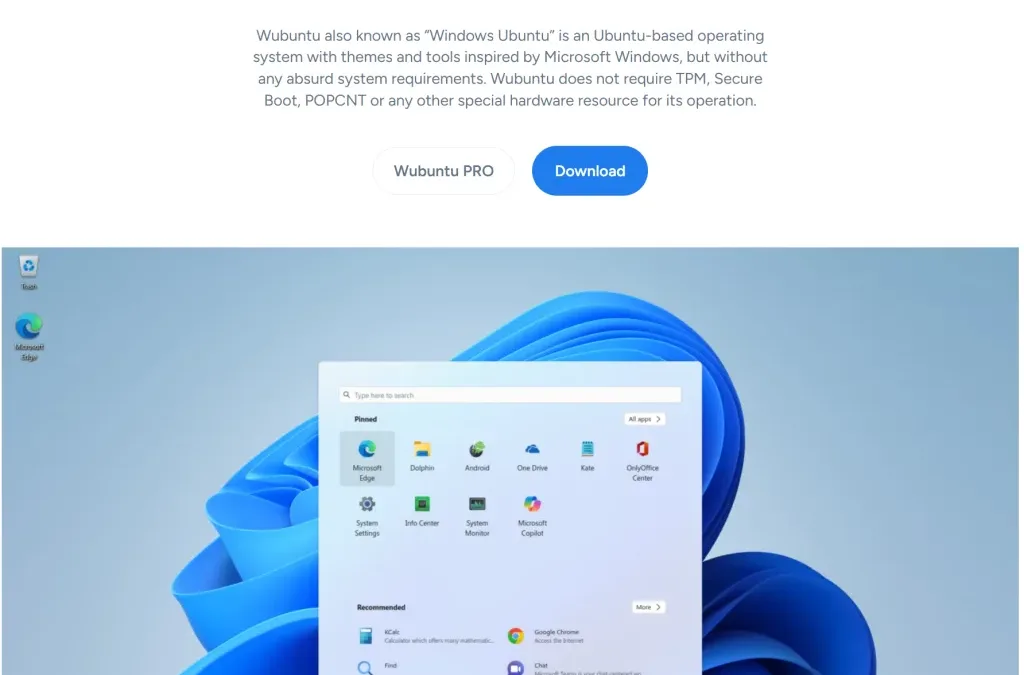

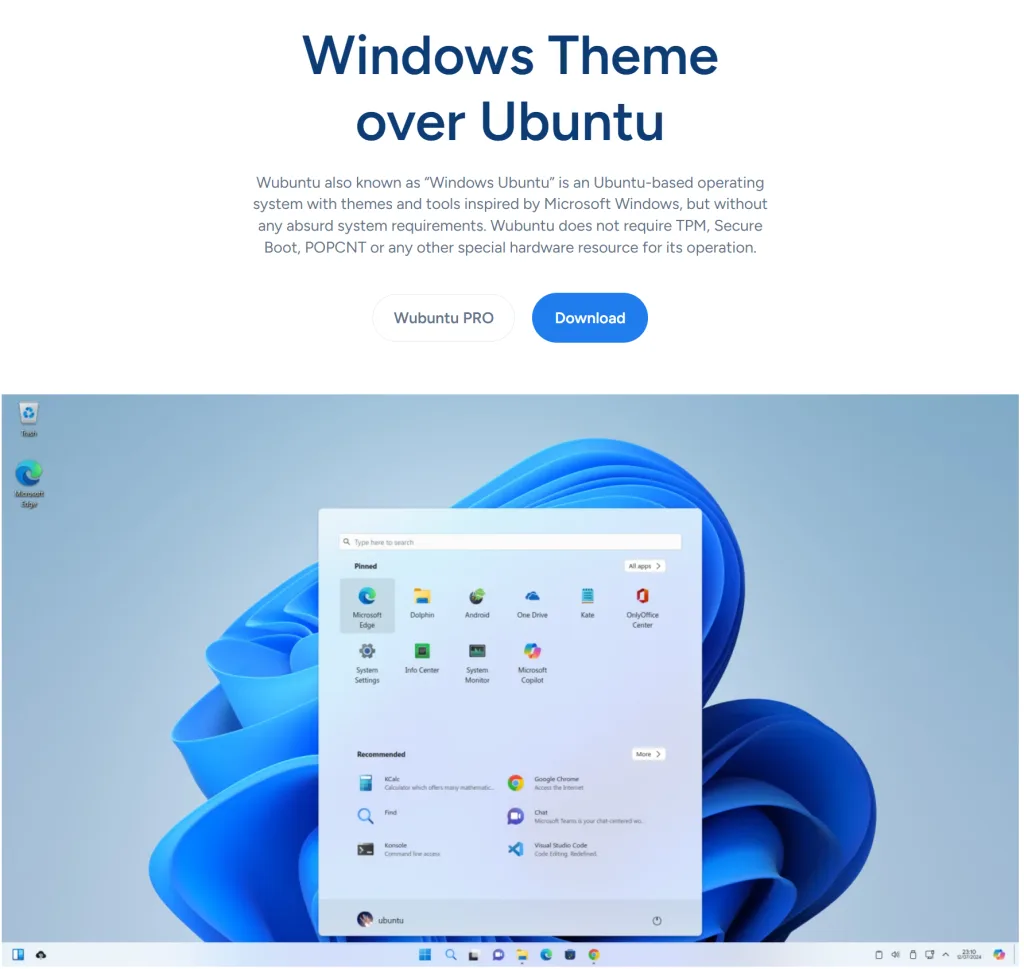

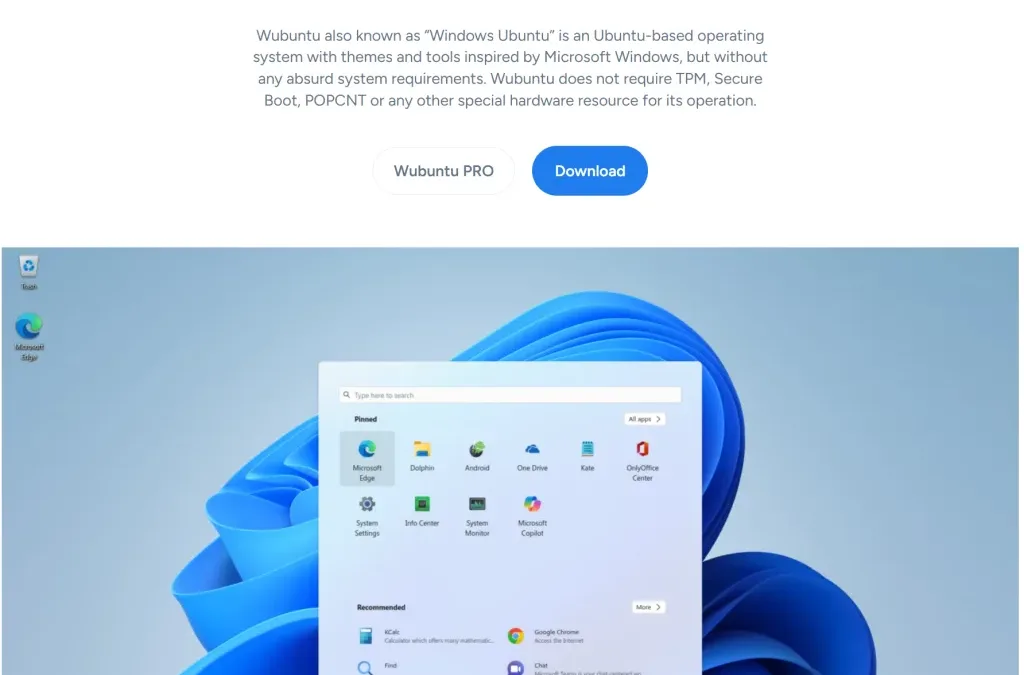

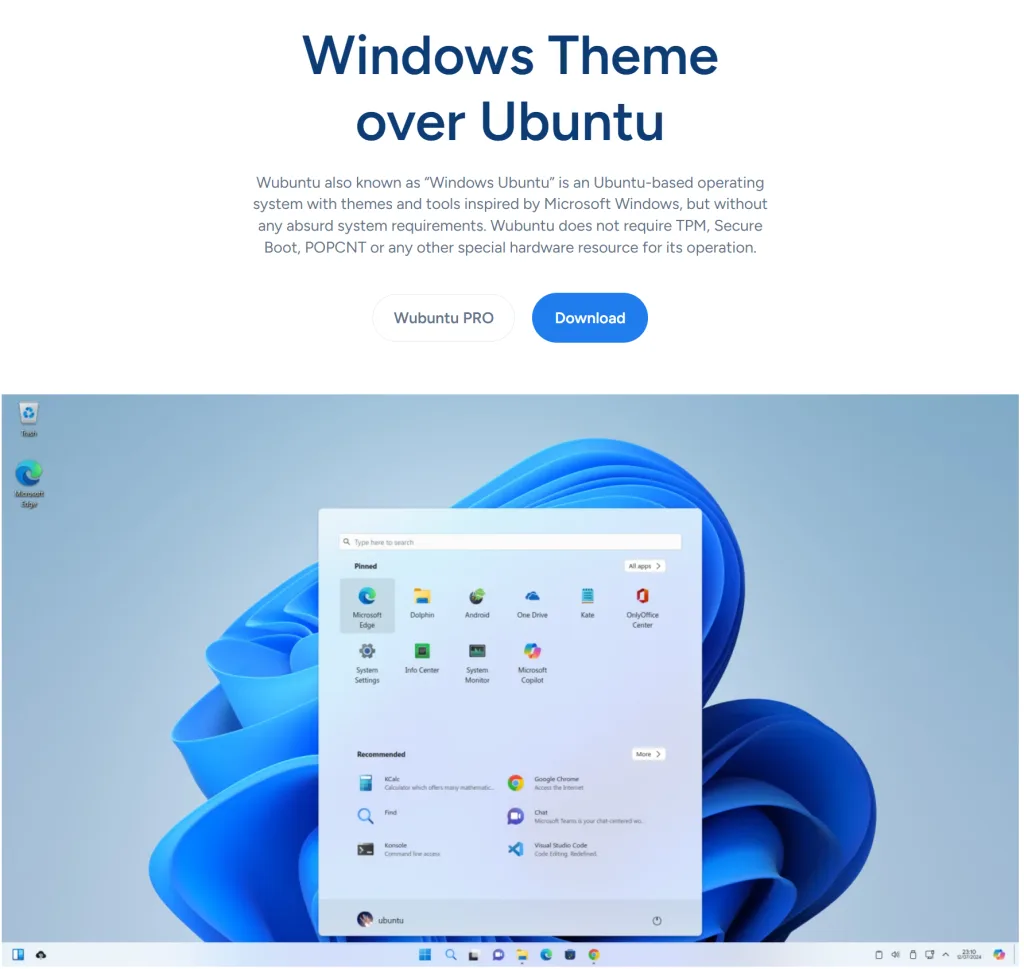

Wubuntu(全名為 Windows Ubuntu)是一款基於 Ubuntu 的作業系統,在提供與 Microsoft Windows 相似的主題和工具,但不需要高規格的系統要求,並且可以在 linux 環境下使用 exe 檔案和 Android 應用,也可以支援 Nvidia 顯卡和繁體中文。

Wubuntu

主要特色:

- Windows 應用程式相容性:透過優化的 Wine,讓Wubuntu 能夠順暢地執行多種 Windows 平台的應用程式。

- Android 和 PlayStore 相容性:內建的 Android 子系統允許直接從 PlayStore 安裝遊戲和應用程式。

- 適用於舊硬體設備:Wubuntu 不需要特殊的硬體要求,只需裝置支援 64 位元即可。

最新版本:

Wubuntu 的最新版本基於 Kubuntu 24.04.1 LTS,代號為「Winux」或「Windows Theme Over Linux」。

硬體需求:

- 64 位元雙核心 CPU

- 2 GB 記憶體(建議 4 GB)

- 20 GB 硬碟空間(建議使用 SSD)

PowerTools:

這是一組工具,提供類似於 Windows 系統的控制面板和設定,以及增強的 Windows 和 Android 子系統支援,還可以上網用 OneDrive 和 Google Drive。

下載與支援:

使用者可以透過官方網站下載 Wubuntu 的最新版本,安裝檔案是 ISO 檔案,是可以用 VM 安裝或是用 USB 隨身碟安裝。

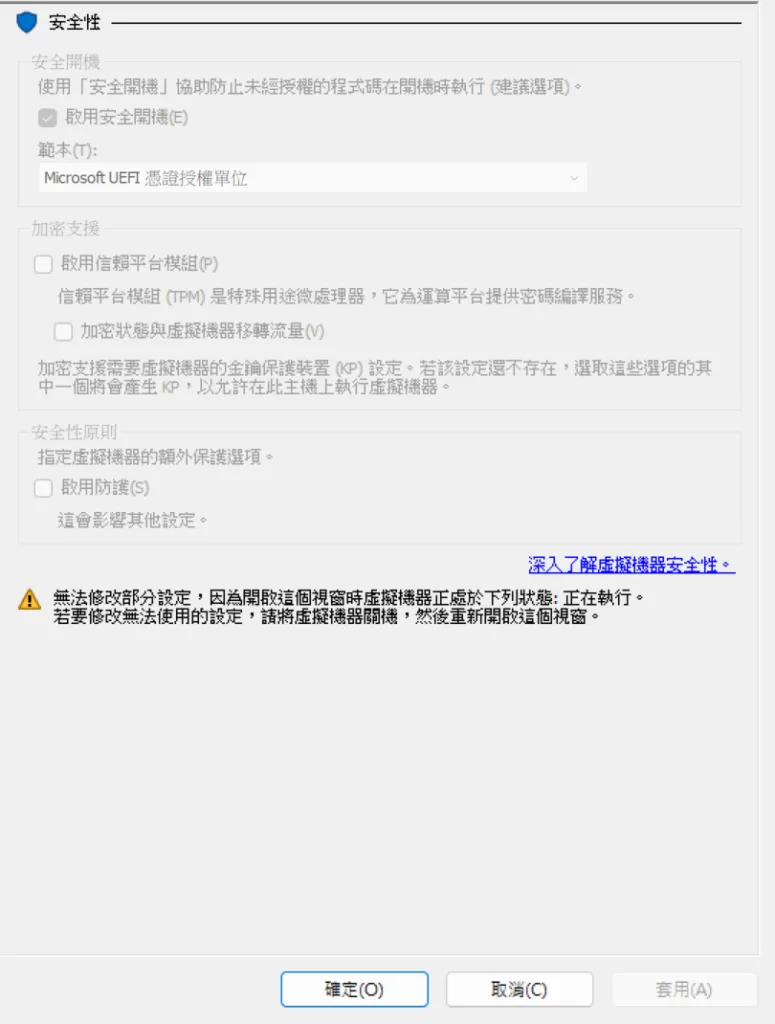

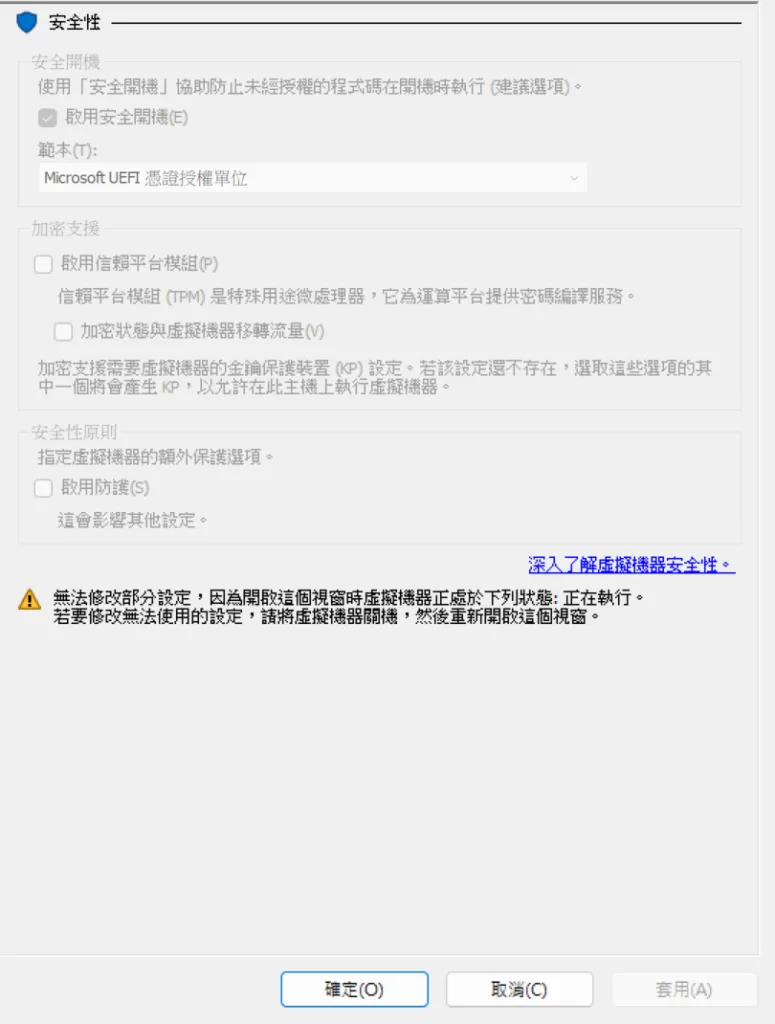

採用 Hyper-V

開機的安全性選項要選擇 Microsoft UEFI

注意事項:

Wubuntu 可能涉及一些版權和商標問題,以及使用者資料處理方面的爭議。

by rainchu | 9 月 23, 2024 | AI, 人臉辨識, 圖型處理, 影片製作

用有多張臉,即時更換人臉的開源軟體,而且有綠色直接使用版本,已經幫忙把環境都打包好了,給懶人使用,支援windows、MAC、GPU

必要條件

Git 原始碼

https://github.com/hacksider/Deep-Live-Cam.git

下載模型

- GFPGANv1.4

- inswapper_128.onnx (Note: Use this replacement version if an issue occurs on your computer)

並且將這兩個檔案放在 models 的目錄下

安裝相關依賴

pip install -r requirements.txt

參考資料

https://github.com/hacksider/Deep-Live-Cam

by Rain Chu | 11 月 8, 2023 | AI, 人臉辨識, 圖型處理, 影片製作, 繪圖

Rope以其令人矚目的功能,站在了這場技術革新的前沿。這款AI工具不僅能夠輕鬆去除臉部遮擋,更整合了多種高清化算法,讓處理速度快如閃電。然而,在介紹如何安裝和使用Rope之前,我們必須提醒每一位用戶:這項強大的技術應當用於正當的創造和學術研究,千萬別拿去做壞事。現在,讓我們詳細了解如何在您的本地設備上安裝並運行Rope。

安裝必要軟體

在開始使用Rope之前,需要先安裝一些必要的軟體:

- 安裝Python

- 安裝FFmpeg

- FFmpeg是處理影片不可或缺的組件,可以通過命令行進行安裝,或是參考我之前的ffmpeg教學。

- Nvidia顯卡安裝CUDA

- 為了充分發揮Rope的性能,Nvidia顯卡用戶應安裝CUDA 11.8,這對於AI運算至關重要。

安裝Rope

安裝了必要的軟體後,便可以開始安裝Rope:

- 下載Rope壓縮包

- 安装visual studio 2022

- 創建虛擬環境

- 使用Python建立一個新的虛擬環境,這有助於管理依賴包和版本。

- python -m venv venv

- 啟動虛擬環境

- 透過命令行啟動虛擬環境,準備安裝Rope。

- call venv\scripts\activate.bat

- 安裝依賴包

- 在虛擬環境中,使用pip指令安裝Rope需要的所有依賴包。

- pip install -r requirements.txt

- 如果安裝失敗,要先執行下面的指令

- pip install –no-cache-dir -r requirements.txt

- pip uninstall onnxruntime onnxruntime-gpu

- pip install onnxruntime-gpu==1.15.0

- 下載換臉模型

透過這些步驟,您可以在本地機器上成功安裝和配置Rope,並開始進行高效的臉部轉換。隨著AI技術的快速發展,Rope提供了一個既方便又強大的工具,使創意和創新更加無限。

操作指南:如何使用Rope進行批量換臉

請先確認安裝 Rope 已經成功,接著,遵循以下步驟來執行Rope的批量換臉功能:

- 打開命令提示字元

- 進入Rope的本地根目錄

- 激活虛擬環境

- 通過執行

call venv\Scripts\activate.bat指令來激活Rope的Python虛擬環境。

- 運行Rope主程式

- 使用

python run.py --execution-provider cuda指令,開始執行批量換臉處理。

自定義選項:提升處理質量與效率

Rope提供多個可選參數來滿足用戶的特定需求:

- 面部增強

- 加入

face_enhancer選項,可以對換臉後的面部進行增強處理,使其更加清晰細緻。

- python run.py –execution-provider cuda face_enhancer

- 調整輸出視頻質量

- 使用

--video-quality選項並指定一個0到50的數值(數值越小,輸出質量越高)。

- python run.py –execution-provider cuda –video-quality 1

- 指定內存使用

- 若需要管理程序的內存使用,可透過

--max-memory選項設定最大內存限制。

- python run.py –execution-provider cuda –max-memory 16

- 指定執行線程

- 對於較老的Nvidia顯卡,可使用

--execution-threads來指定執行線程數,以達到最佳運行效能。

- python run.py –execution-provider cuda –execution-threads 2

- 預設是4

使用方法可以看YT

Rope又一款强大的一键换脸AI!可消除脸部遮挡,多种高清化算法,飞一般的处理速度!本地安装与参数使用详解。 – YouTube

解除roop检测深度换脸 – YouTubehttps://www.youtube.com/watch?v=YH4hB3wmRcQ

roop新奇用法:一键直播换脸、批量换图 – YouTube

Rope 分支

https://github.com/Hillobar/Rope/

https://github.com/s0md3v/sd-webui-roop

by Rain Chu | 10 月 20, 2023 | AI, Tool

近年來,AI技術在多方面都已發光發熱,其中最具話題性的當屬Adept這家新創公司。微軟的Copilot雖然在Office365的範疇內有著出色的表現,但Adept則有著更宏大的願景——使所有的軟體都能夠被AI所操控。

Adept的目標是簡單而直接的:用一句話完成所有任務。他們打造了名為「AI助理」的概念,實際上是透過他們開發的ACT-1模型來實現。這款模型基於深度學習基礎模型Transformer所建構,使其能夠學習與模仿使用者的電腦操作,從而自動執行複雜的任務。舉例而言,使用者只需要在Adept的文本框中簡單輸入指令,ACT-1模型就能夠按照使用者的習慣,自動完成指令中的所有要求。

除此之外,Adept的市值和募資金額也非常驚人。在僅成立一年之內,該公司就成功獲得了超過4億美元的募資,投資方包括了Microsoft、Nvidia、Greylock等知名企業和創投機構。尤其值得一提的是,《Forbes》報導指出,該公司最近以10億美元的估值完成了B輪募資,這無疑再次證明了Adept的商業模型和技術潛力。

作為OpenAI的競爭對手,Adept逆勢籌資,並已經明確表示他們希望開發出新的AI工具。他們的目標是利用AI以全新的方式來操控電腦,真正讓AI成為每一位使用者的個人助理。

近期留言